Reformer: Google hebt Sprach-KI auf das nächste Level

Googles neue Sprach-KI "Reformer" kann ganze Romane auf einen Schlag verarbeiten. Das wird maschinelle Sprachverarbeitung auf das nächste Level bringen.

2019 war das Jahr der Sprach-KIs: Google, OpenAI und Nvidia entwickelten mächtige Systeme wie Transformer, BERT, GPT-2 und Megatron, deren Sprachverarbeitung weit über die Fähigkeiten bisheriger Systeme hinausgeht.

Diese auf Sprache optimierte Künstliche Intelligenz kann (mehr oder weniger) glaubhafte neue Texte generieren, vorhandene Texte zusammenfassen, sie übersetzen oder Fragen zu ihnen beantworten. Mächtige Sprach-KIs geben Menschen neue Möglichkeiten, sich global auszutauschen, zu lernen oder Computer anzuweisen.

Kontext is King

Damit Sprach-KI ihre anspruchsvolle Aufgabe nach dem Training gut beherrscht, braucht sie Kontext. Der steckt zum Beispiel in einem zu übersetzenden Satz.

Je größer der Kontext ist, den die KI erfassen kann, desto besser wird die Übersetzung. Kann die KI besonders viel Kontext erfassen, sind sogar Übersetzungen ganzer Seiten statt einzelner Sätze möglich.

Die weit verbreiteten LSTM-Netzwerke ("Long short-term memory") können bis zu hundert Wörter erfassen. Das reicht für einzelne Sätze.

Googles Transformer-Architektur war im Vergleich zu LSTM-Netzwerken schon eine deutliche Verbesserung: Sie kann tausende Wörter gleichzeitig verarbeiten und im Kontext auszuwerten. Das ermöglicht beispielsweise eine hochwertige Übersetzung ganzer Artikel statt einzelner Sätze oder die Zusammenfassung von wissenschaftlichen Quellen.

Doch die Transformer-Architektur verlangt nach viel Speicher und Rechenleistung: Sie besteht aus mehreren Schichten, von denen schon eine einzelne Schicht eine eigene Recheneinheit mit mehreren Gigabyte Speicher benötigt.

Daher ist aktuelle Version von Transformer nicht skalierbar: Größere Netzwerke könnten zwar mehr Wörter erfassen, würden die Hardwareanforderungen aber explodieren lassen. Das Netzwerk würde sehr langsam und noch teurer.

Reformer untersucht bis zu eine Million Wörter auf Kontext

Google hat daher eine besser skalierbare Lösung entwickelt: Sie heißt "Reformer" und bietet eine modifizierte Transformer-Architektur, die bis zu eine Million Wörter verarbeiten kann. Trotz des mehrschichtigen Aufbaus läuft sie vergleichsweise schlank auf nur einer Recheneinheit mit maximal 16 Gigabyte Speicher - die bietet jede Oberklasse-Grafikkarte.

Was hat Google verändert? Transformer betrachtet alle möglichen Wortpaare eines Textes, um den Kontext zu verstehen. Bei einem Text mit 100.000 Wörtern sind das zehn Milliarden Paare.

Reformer legt stattdessen bedeutungsähnliche Wörter in Gruppen zusammen und verarbeitet diese Gruppen anschließend parallel. Bei einer Übersetzung packt Reformer etwa Auto, Fahrzeug, car und vehicle in eine Gruppe, bevor die Übersetzungsarbeit beginnt, und betrachtet nicht noch dog, mother oder street. Diese Gruppierung reduziert laut Googles Forscher-Team die benötigte Rechenleistung sowie den Speicherplatz "drastisch".

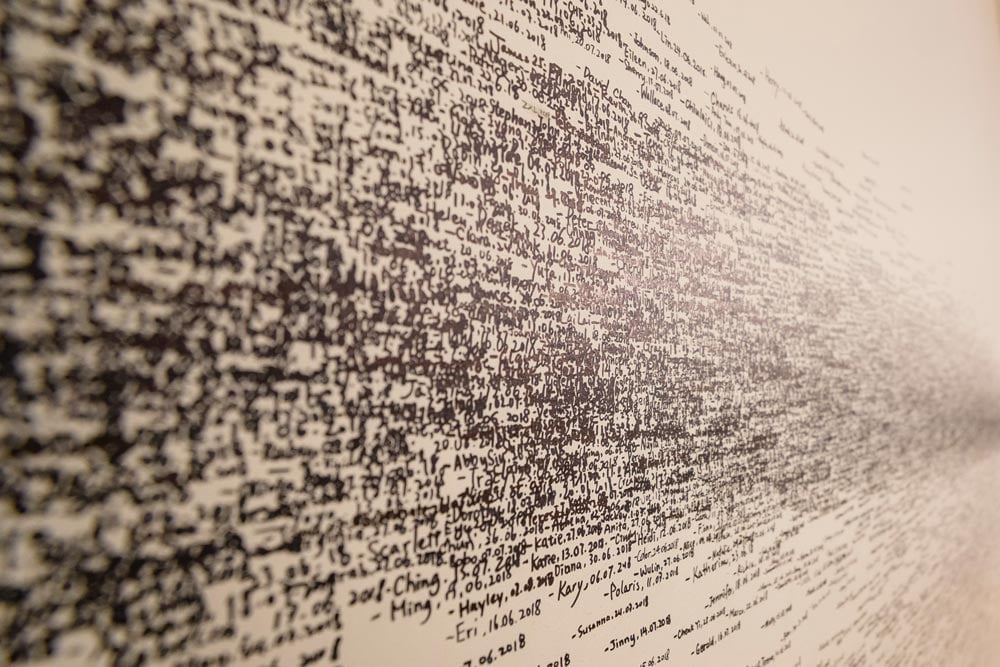

Dank der Gruppierungsmethode kann Reformer ganze Romane auf einen Schlag verarbeiten – Google testete das mit "Schuld und Sühne" von Fjodor Dostojewski aus dem Jahr 1866. Für Interessierte bietet Google ein Colab-Projekt an, in dem jeder die Reformer-KI mit Dostojewskis Klassiker auf Googles Cloud-Hardware trainieren kann. Praktischen Nutzen hat das Projekt nicht, es soll die Effizenz der neuen Architektur beweisen.

Reformer steckt in Googles zukünftigen Sprach-KIs - und kann auch Bilder

Reformer soll die Grundlage für Googles neue Generation Sprach-KI sein, die lange Texte effizient verarbeiten kann. Die Reformer-Reform wird, das ist absehbar, maschinelle Übersetzungen, Fake-Texte, Zusammenfassungen oder KI-Rollenspiele deutlich verbessern.

Spannend: Google gibt einen Ausblick, dass die Kontextverarbeitung von Reformer auch für die Vervollständigung unvollständiger Bilder verwendet werden könnte. Reformer für Bilder und Videos zeige "großes Potenzial", schreibt Google, auch wenn die Kernkompetenz der Architektur vorerst die Text- und Sprachverarbeitung sei.

Titelbild: OpenAI, Quelle: Google

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.