OpenAI-Mitgründer Sutskever: "Ob du willst oder nicht, KI wird dein Leben stark beeinflussen"

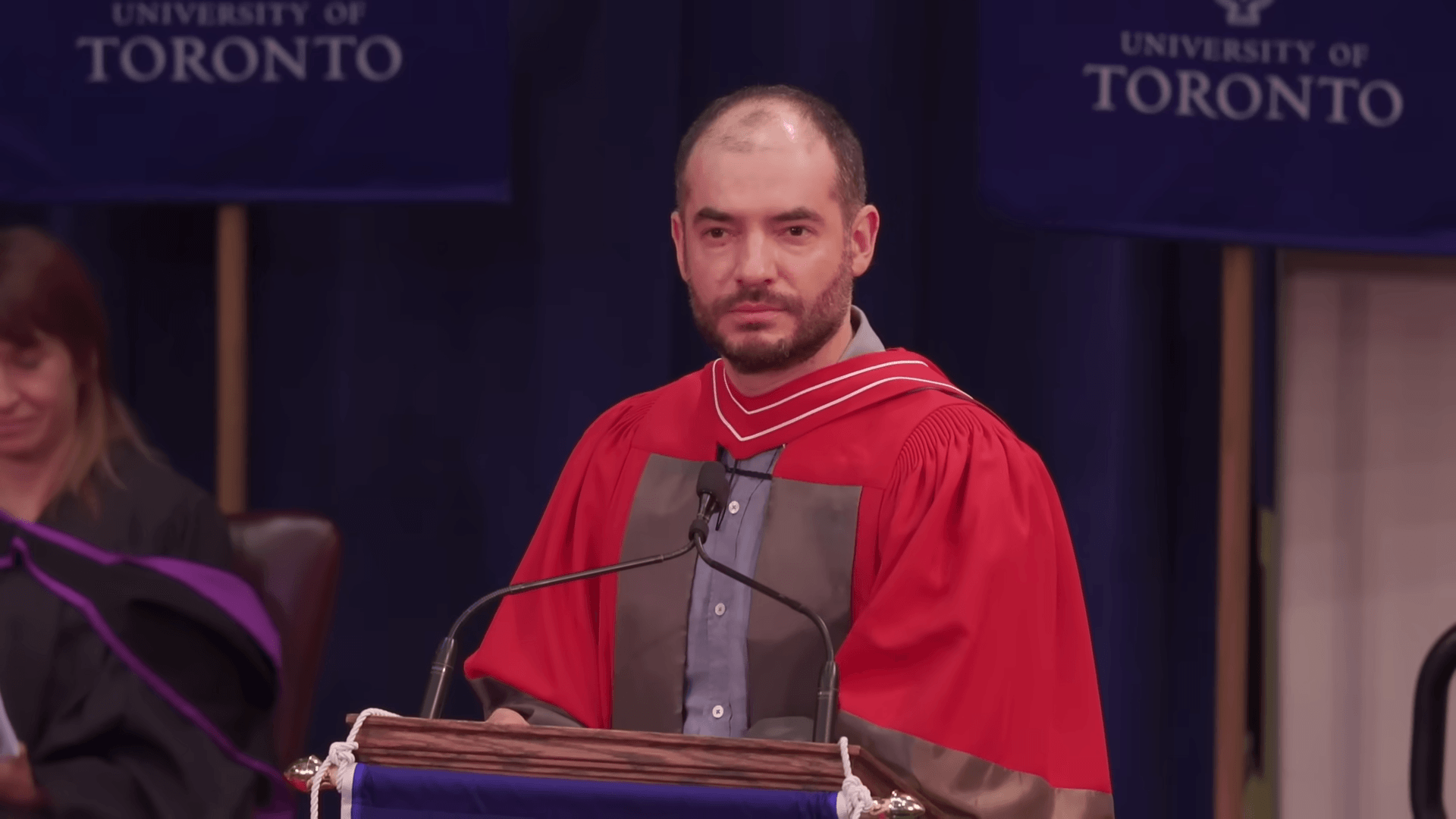

OpenAI-Mitgründer Ilya Sutskever sprach bei der Verleihung seines Ehrendoktors an der University of Toronto über die tiefgreifenden Folgen von Künstlicher Intelligenz.

Die Rede war vor allem ein Appell, eine aus seiner Sicht unausweichliche Zukunft zu akzeptieren. "Wir leben in der ungewöhnlichsten Zeit überhaupt", sagte Sutskever mit Blick auf die aktuellen und bevorstehenden Entwicklungen im Bereich KI.

Der Wandel sei bereits spürbar: Künstliche Intelligenz verändere Studium und Arbeitswelt. Die weitreichenderen Auswirkungen stünden jedoch noch aus.

Auf wissenschaftliche Herleitungen und Fakten verzichtete Sutskever in seiner Ansprache. Stattdessen stützte er sich auf eine intuitive Annahme: Das menschliche Gehirn sei ein biologischer Computer, und was ein biologischer Computer leisten könne, müsse prinzipiell auch ein digitaler leisten können.

Sutskever beschrieb die gegenwärtigen Fähigkeiten von KI-Modellen als "evokativ" – sie seien bereits so weit entwickelt, dass man sich eine erheblich leistungsfähigere Version vorstellen könne, auch wenn sie noch weit von einem vollständigen Kompetenzspektrum entfernt seien.

Superintelligenz als absehbare Entwicklung

Die Richtung sei jedoch eindeutig: Zwar sei die Zukunft schwer vorherzusagen, aber in drei, fünf oder zehn Jahren könne Künstliche Intelligenz Aufgaben in sämtlichen Bereichen übernehmen, die bislang Menschen vorbehalten sind. Die entscheidende Frage sei, was dann geschehe: "Wofür werden wir sie einsetzen?"

Denkbare Antworten seien mehr Forschung, beschleunigtes wirtschaftliches Wachstum und umfassendere Automatisierung – mit der Folge, dass sich das Innovationstempo erheblich erhöhe.

Ausweichen könne man dieser Entwicklung nicht. Der KI-Forscher verwies auf ein bekanntes Zitat: "Du interessierst dich vielleicht nicht für Politik, aber die Politik interessiert sich für dich." Dasselbe gelte für Künstliche Intelligenz, "nur in vielfach verstärkter Form".

"Ob du willst oder nicht, KI wird dein Leben stark beeinflussen", sagt Sutskever.

Im Mai 2024 hatte Sutskever OpenAI verlassen, wo er als Chief Scientist tätig gewesen war. Vorausgegangen waren interne Streitigkeiten im Vorstand. Anschließend gründete er das Start-up Safe Superintelligence (SSI), das sich auf die Entwicklung sicherer Superintelligenz spezialisiert.

Woran er bei SSI konkret arbeitet, ist nicht bekannt. Ende 2024 deutete Sutskever jedoch an, dass die bisherigen Skalierungsprinzipien bei KI an ihre Grenzen gestoßen seien und neue Ansätze erforderlich würden. Der Wert des Unternehmens wird bereits auf mehr als 30 Milliarden US-Dollar geschätzt – obwohl SSI bislang weder ein öffentlich bekanntes Produkt noch Umsätze vorweisen kann.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.