Alle Apple-Intelligence-Updates von der WWDC 25 auf einen Blick

Apple stellt auf der WWDC25 neue Funktionen für Apple Intelligence vor, darunter Live-Übersetzungen, visuelle Intelligenz für Bildschirminhalte, personalisierte Workouts und kreative Tools.

Apple hat auf der Entwicklerkonferenz WWDC25 eine Reihe neuer Funktionen für Apple Intelligence vorgestellt. Die KI-Funktionen sollen ab Herbst auf iPhone, iPad, Mac, Apple Watch und Apple Vision Pro verfügbar sein und sind ab sofort in einer Testversion zugänglich. Bis Ende des Jahres will Apple zudem acht weitere Sprachen unterstützen, darunter Dänisch, Schwedisch, Chinesisch (traditionell) und Vietnamesisch.

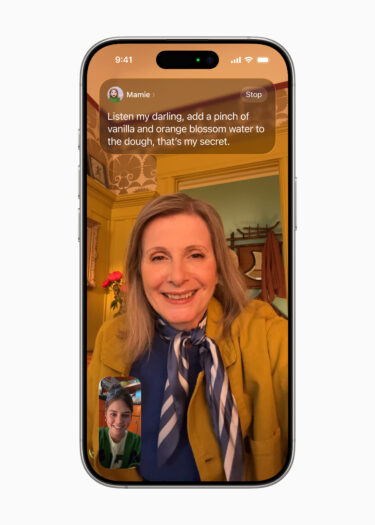

Echtzeit-Übersetzung in Nachrichten, FaceTime und Telefon

Mit "Live Translation" integriert Apple eine systemweite Übersetzungsfunktion, die in Nachrichten, FaceTime und Telefongesprächen funktioniert. Nachrichten werden bereits beim Tippen in die bevorzugte Sprache des Empfängers übersetzt.

In FaceTime erscheinen übersetzte Live-Untertitel, während die Originalstimme hörbar bleibt. Telefonate werden in Echtzeit mitgesprochen. Die Übersetzungsmodelle laufen lokal auf dem Gerät, sodass keine Gesprächsdaten an Server übertragen werden.

Genmoji und Bildgenerierung im Wunschstil mit ChatGPT

Die Funktionen Genmoji und Image Playground wurden dank ChatGPT um neue Optionen erweitert. Nutzer können Emojis mit Textbeschreibungen kombinieren oder bestehende Emojis modifizieren, etwa durch Änderung von Frisur oder Ausdruck. In der Option "Any Style" beschreibt der Nutzer den gewünschten Stil, und ChatGPT erstellt ein entsprechendes Bild. Laut Apple werden keine Daten ohne Zustimmung an ChatGPT übermittelt.

Video: Apple

Bildschirminhalte analysieren mit visueller Intelligenz

Die visuelle Intelligenz von Apple Intelligence analysiert künftig auch den Bildschirminhalt. Nutzer können etwa ein Objekt auf dem Bildschirm markieren und nach ähnlichen Produkten suchen. Auch Fragen zu Objekten können direkt an ChatGPT gestellt werden.

Dank ChatGPT-Integration kann man Fragen zu Bildern auf dem Bildschirm stellen. Bei ChatGPT direkt geht das sogar in gesprochener Sprache. | Video: Apple

Erkennt das System einen Veranstaltungshinweis, schlägt es automatisch einen Kalendereintrag vor und füllt Datum, Uhrzeit und Ort voraus. Der Funktionsaufruf erfolgt über die bekannte Screenshot-Kombination.

Video: Apple

Workout Buddy liefert personalisierte Sprach-Coaching-Tipps

Mit "Workout Buddy" bringt Apple eine KI-gestützte Trainingshilfe auf die Apple Watch. Sie analysiert in Echtzeit Daten wie Herzfrequenz, Tempo, Distanz sowie bisherige Fitnessleistungen und liefert personalisierte Sprachanweisungen. Die Sprache wird durch ein Text-to-Speech-Modell erzeugt, das auf Stimmen von Fitness+-Trainern basiert. Die Datenverarbeitung erfolgt lokal.

Workout Buddy funktioniert mit Bluetooth-Kopfhörern und benötigt ein kompatibles iPhone in der Nähe. Unterstützt werden unter anderem Laufen, Gehen, Radfahren und Krafttraining.

Kurzbefehle mit Apple Intelligence und neue Spotlight-Funktionen

Die Kurzbefehle-App wurde um neue Aktionen erweitert, die direkt auf Apple Intelligence zugreifen. Nutzer können damit automatisierte Abläufe erstellen, etwa zur Texterfassung oder Bilderzeugung. Diese Automationen lassen sich an Bedingungen knüpfen – zum Beispiel zu bestimmten Tageszeiten oder beim Anschluss eines Displays unter macOS Tahoe.

Die zugrunde liegenden Modelle laufen lokal auf dem Gerät oder über Apple Private Cloud Compute und können optional auch ChatGPT einbinden. Ein praktisches Beispiel: Studierende können mithilfe eines Kurzbefehls Mitschriften mit Audioaufnahmen aus Vorlesungen abgleichen, um verpasste Informationen zu ergänzen.

Auch Spotlight wurde mit systemweiten Funktionen ausgebaut. Nutzer können direkt aus der Suche heraus Kalenderereignisse anlegen, Audionotizen aufnehmen oder Podcasts starten. Über sogenannte Quick Keys lassen sich häufige Aktionen beschleunigen – etwa durch Eingabe von "sm" zum Versenden einer Nachricht oder "ar" für das Erstellen einer Erinnerung. Alle dafür nötigen Angaben wie E-Mail-Empfänger oder Betreffzeile können direkt in Spotlight ausgefüllt werden.

Apple Intelligence in Alltags-Apps: KI-Funktionen für Erinnerungen, Wallet, Nachrichten und mehr

Darüber hinaus kündigte Apple eine Reihe kleinerer Neuerungen an, die Apple Intelligence tiefer in alltägliche Apps integriert. In der Erinnerungen-App erkennt das System relevante Informationen aus E-Mails, Webseiten oder Notizen und kategorisiert sie automatisch. Apple Wallet fasst Bestellinformationen aus Versand-E-Mails zusammen und zeigt den aktuellen Lieferstatus zentral an.

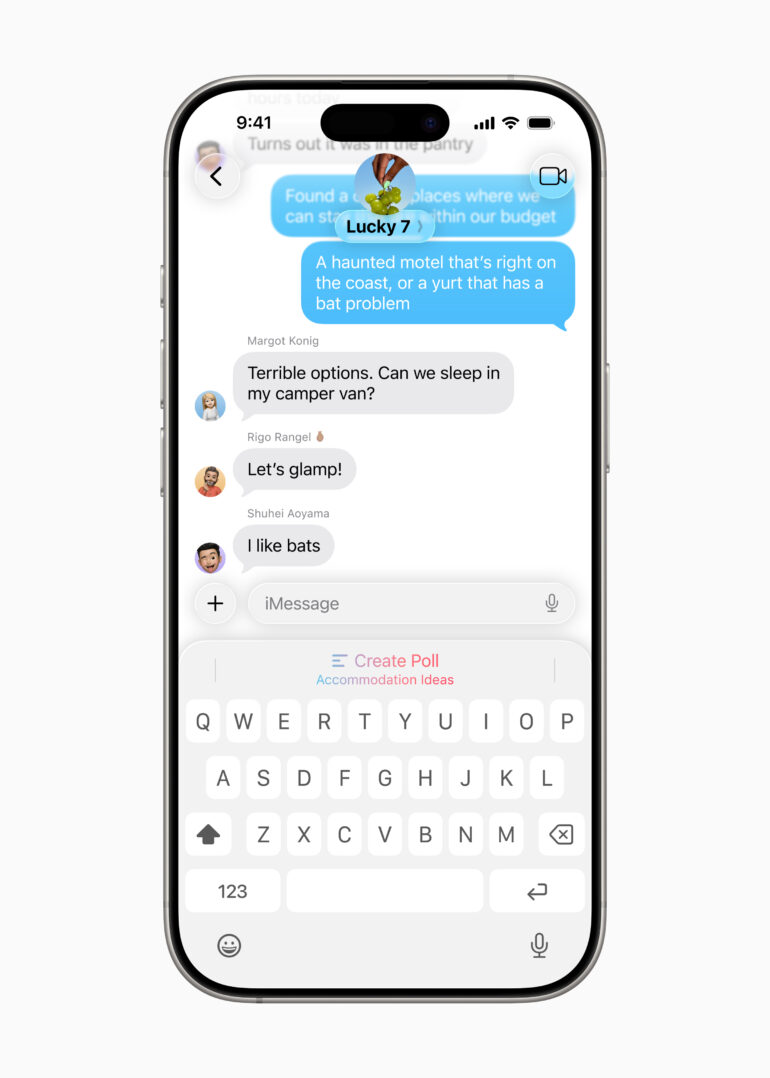

In der Nachrichten-App können Nutzer nun Umfragen erstellen. Apple Intelligence schlägt automatisch eine Umfrage vor, wenn sie in Gruppenchats sinnvoll erscheint. Zusätzlich lassen sich Chats mit Hintergründen personalisieren, die sich auch mit dem Image Playground individuell gestalten lassen.

Viele bestehende Funktionen wurden ebenfalls erweitert: So lassen sich Texte mit den Writing Tools umformulieren, korrigieren oder zusammenfassen, während das "Describe Your Change"-Feature gezielte Stiländerungen erlaubt, etwa eine Einladung in Gedichtform. In Fotos können störende Elemente mit "Clean Up" entfernt oder grobe Skizzen mit "Image Wand" in passende Bilder umgewandelt werden.

Siri erhält ein natürlicheres Sprachverständnis, unterstützt jetzt auch Eingaben per Tastatur und kann kontextbezogen auf Folgefragen reagieren. Zugriff auf ChatGPT ist direkt in Siri und die Writing Tools integriert.

Weitere KI-gestützte Funktionen betreffen unter anderem automatische Zusammenfassungen in Mail, Nachrichten und Notizen, intelligente Antwortvorschläge, priorisierte E-Mails und Benachrichtigungen sowie eine reduzierte Unterbrechungsfunktion.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.