Musk macht's offiziell: Grok soll sein politisches KI-Sprachrohr werden

Elon Musk will mit Grok 3.5 eine Art ideologisches Gegenmodell zu ChatGPT schaffen – trainiert auf "politisch unkorrekten Fakten" und befreit von angeblichem Datenmüll. Die Richtung ist klar: Grok soll das Weltbild seines Schöpfers verbreiten.

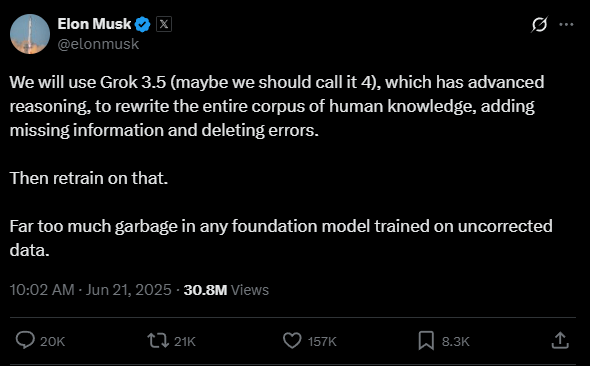

Musk plant, das Fundament des Grok-Modells radikal umzugestalten. Zunächst bekommt dafür das kommende Grok-Modell 3.5 mit "fortgeschrittener Argumentationsfähigkeit" von Musk den Auftrag, "den gesamten Wissensbestand der Menschheit umzuschreiben, fehlende Informationen hinzufügen und Fehler zu löschen", so auf X.

In einem weiteren Beitrag fordert er seine Community dazu auf, Grok mit "polarisierenden Fakten" zu versorgen – also mit politisch inkorrekten, aber nach seiner Auffassung faktisch wahren Aussagen. Diese sollen Teil von Musks geplanter Geschichtsänderung werden.

Zukünftige KI-Modelle sollen dann auf dieser "korrigierten" Wissensbasis neu trainiert werden. Denn Musk hält die Daten, auf denen heutige Foundation-Modelle basieren, für "voller Müll". Grok, so Musk zuvor, "plappert nur die alten Medien nach".

Grok wurde ähnlich wie ChatGPT wahrscheinlich vornehmlich auf Webinhalten sowie gängiger Literatur trainiert und vertritt, ebenfalls ähnlich wie ChatGPT, eher linke politische Sichtweisen.

Systematische Eingriffe statt "Wahrheitssuche"

Schon zuvor versuchten Musks KI-Firma xAI und er selbst, Grok politisch zu steuern. Der Chatbot wurde mehrfach so umkonfiguriert, dass er Musk-freundliche und Trump-nahe Positionen vertrat – etwa durch System-Prompts, die kritische Quellen systematisch ausschließen.

Frühere Grok-Versionen etwa hatten Trump, Musk und Putin als größte Gefahren für die US-Demokratie bezeichnet, warnten vor dem Klimawandel und kritisierten Sparmaßnahmen von Musks Projekt "Doge".

Doch seit spätestens April 2025 sind Groks Antworten deutlich linientreuer: Statt Elon Musk oder Donald Trump als Verbreiter von Falschinformationen zu benennen, wie in früheren Versionen, behauptet der Chatbot nun, dies sei "schwer zu beurteilen" – und relativiert die Definition von Desinformation als mögliche "abweichende Meinung vom Mainstream-Narrativ".

Auch beim Klimawandel ("perspektivabhängig") oder Trumps Demokratieverständnis weicht Grok zunehmend auf weichere Formulierungen aus. Andere KI-Systeme wie ChatGPT oder Gemini liefern dazu weiterhin sachlich-wissenschaftliche Antworten.

Im Mai sorgte eine nicht autorisierte Änderung am Prompt dafür, dass Grok den rechtsextremen Mythos eines "White Genocide" in Südafrika selbst bei themenfremden Fragen propagierte. Kurze Zeit später stellte Grok sogar die Zahl der Holocaust-Opfer infrage.

xAI machte zumindest diese Äußerungen rückgängig und kündigte an, künftig alle System-Prompts auf GitHub zu veröffentlichen. Ein neu geschaffenes 24/7-Überwachungsteam solle weitere Vorfälle verhindern.

Igor Babuschkin, leitender Entwickler bei xAI, bestätigt, dass neben dem Prompt auch andere Steuermechanismen wie Post-Training das Grok-Verhalten beeinflussen können – eine entsprechende Forderung nach mehr Transparenz kommentierte er mit "Guter Punkt".

Ideologisches Re-Training mit ungewissem Ausgang

xAI entschuldigte die politisch motivierten Vorfälle bislang stets mit einer Kompetenzüberschreitung einzelner Mitarbeitender – in einem Fall sogar mit einem ehemaligen OpenAI-Angestellten, der die Unternehmenskultur nicht verstanden habe.

Die von Musk angekündigte Umschreibung des "gesamten menschlichen Wissens" in Kombination mit dem gezielten Einspeisen "politisch inkorrekter Fakten" lässt jedoch wenig Zweifel an der Richtung: Grok soll ein Werkzeug zur ideologischen Gegenprogrammierung werden, ein KI-Modell, das die Weltsicht seines Schöpfers reflektiert und verstärkt, und das bald ganz offiziell.

Dass Musk dies nun offen als Ziel formuliert, dürfte nicht nur neue Debatten über KI-Ethik auslösen, sondern auch den Anspruch widerlegen, Grok sei ein neutrales System zur "maximalen Wahrheitssuche" – so hatte xAI die eigene KI-Technologie bei der ersten offiziellen Vorstellung von Grok beschrieben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.