Microsoft bringt KI-Agent in Windows-Einstellungen mit neuem Mu-Sprachmodell

Windows bekommt einen KI-Assistenten, der Systemeinstellungen per natürlicher Spracheingabe ändert. Das neue Sprachmodell "Mu" läuft komplett offline auf speziellen KI-Chips, ist aber vorerst nur für wenige Nutzer:innen verfügbar.

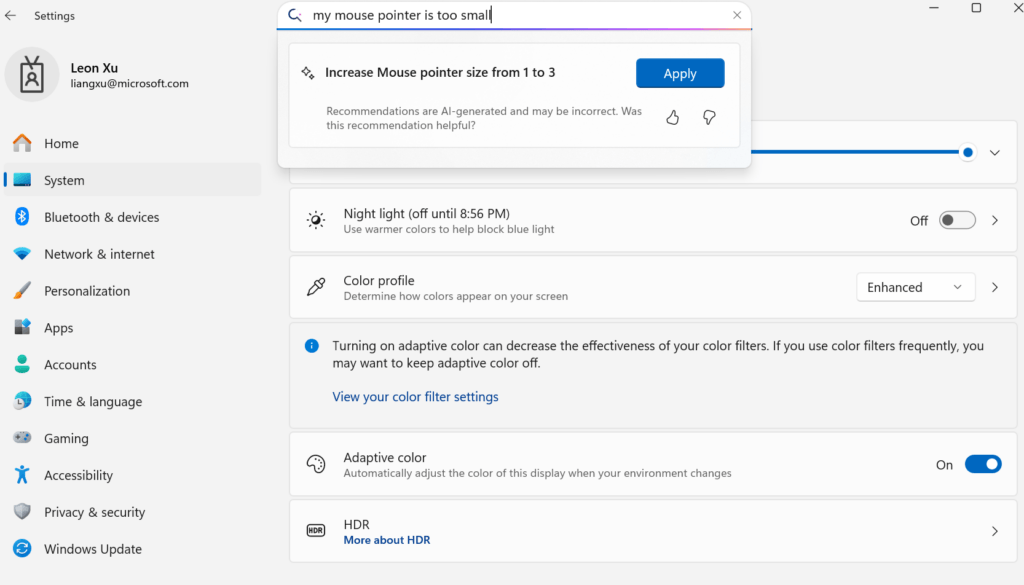

Nutzer:innen können damit künftig Befehle wie "Erhöhe die Bildschirmhelligkeit" oder auch Probleme wie "Mein Mauszeiger ist zu klein" eingeben, anstatt sich durch komplizierte Menüs zu klicken. Der Agent ist in die bestehende Suchbox der Einstellungen integriert und antwortet laut Microsoft in unter einer halben Sekunde.

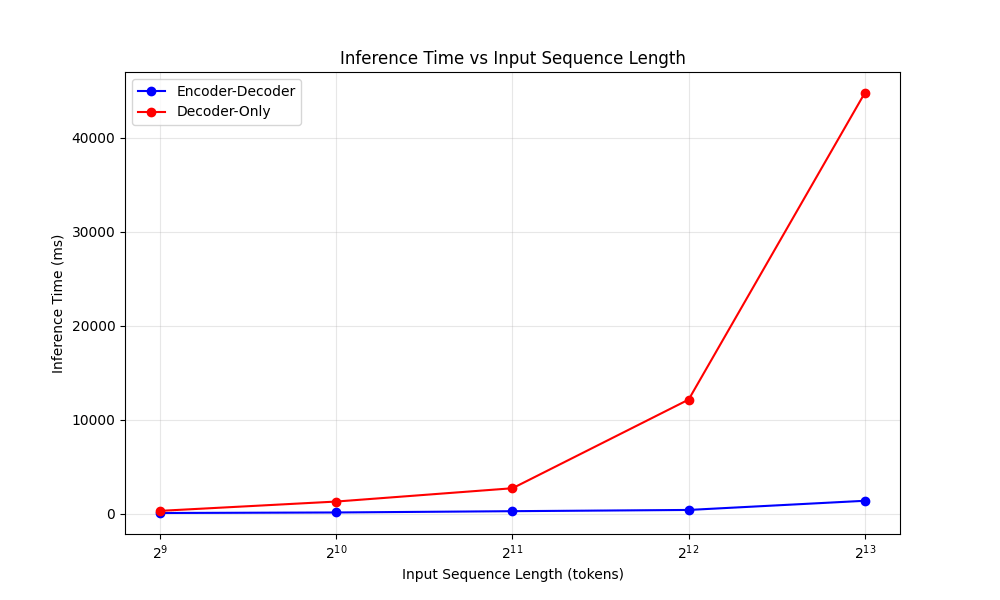

Angetrieben wird der Agent von einem neuen Sprachmodell namens "Mu", das Microsoft speziell für diese Aufgabe entwickelt hat. Das Modell hat 330 Millionen Parameter und nutzt eine Encoder-Decoder-Architektur, die laut Microsoft deutlich effizienter arbeitet als die meisten aktuellen Sprachmodelle, die auf eine reine Decoder-Architektur setzen.

Der Encoder wandelt die Eingabe der Nutzer:innen einmalig in eine interne Repräsentation um, während der Decoder daraus die entsprechenden Windows-Befehle generiert. Diese Aufteilung reduziert nach Angaben von Microsoft die Antwortzeit um 47 Prozent und erhöht die Verarbeitungsgeschwindigkeit um das 4,7-fache gegenüber vergleichbaren Modellen.

Vollständig lokale Ausführung auf NPU-Chips

Mu läuft vollständig auf den Neural Processing Units (NPUs) der Copilot+ PCs. Diese speziellen KI-Chips sind für maschinelles Lernen optimiert und ermöglichen es dem Modell, über 100 Token pro Sekunde zu verarbeiten. Microsoft gibt an, dass das System auf einem Surface Laptop 7 über 200 Token pro Sekunde erreicht.

Das Unternehmen verwendete unter anderem Post-Training Quantization, um das Modell für die NPU-Hardware zu optimieren. Dabei werden die Modellgewichte von Fließkomma- in 8-Bit- und 16-Bit-Integer-Werte umgewandelt, was den Speicherverbrauch reduziert und die Geschwindigkeit erhöht.

Training mit 3,6 Millionen Beispielen

Microsoft trainierte Mu zunächst mit hunderten Milliarden "educational tokens" und nutzte anschließend eine Destillation aus den größeren Phi-Modellen des Unternehmens. Für die spezifische Aufgabe im Settings Agent verwendete Microsoft 3,6 Millionen zum Teil synthetische Trainingsbeispiele und erweiterte die Abdeckung von etwa 50 auf hunderte Windows-Einstellungen.

Das System funktioniert am besten bei längeren, eindeutigen Anfragen. Bei kurzen oder mehrdeutigen Befehlen zeigt die Suchbox weiterhin herkömmliche Suchergebnisse an. Problematisch sind etwa Befehle wie "Helligkeit erhöhen", wenn mehrere Monitore angeschlossen sind.

Nur für Windows Insider mit Copilot+

Microsoft sammelt derzeit Feedback von Windows Insiders, um das System zu verbessern. Das Unternehmen arbeitet daran, auch komplexere Aufgaben zu unterstützen, konzentriert sich aber zunächst auf die am häufigsten genutzten Einstellungen.

Wann das Feature für alle Windows-Nutzer:innen verfügbar wird, teilte Microsoft nicht mit. Da das Feature auf NPU-Hardware angewiesen ist, die nur in den neuesten Copilot+-PCs verbaut ist, dürfte die Verbreitung zunächst begrenzt sein. Wer die nötigen Hardwarevoraussetzungen mitbringt, muss sich zudem im Dev Channel registrieren.

Insgesamt läutet Microsoft damit eine Ära ein, in der Computer zunehmend durch natürliche Sprache bedient werden können. In der Vergangenheit hat Microsoft bereits verschiedene experimentelle Agentensysteme gezeigt, die aber häufig die Interaktion mit GUIs durch ein multimodales Sprachmodell voraussetzten. Wie bei Mu ein Modell für eine konkrete Aufgabe zu trainieren, scheint der unflexiblere, dafür aber deutlich effizientere Weg.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.