KI als Kiosk-Betreiber: Anthropics Claude verschenkt Waren und erfindet Geschäftspartner

Ein KI-Modell in der Rolle eines Ladenbetreibers: Mit Project Vend testete Anthropic, wie autonom Claude wirtschaftlich handeln kann. Das Experiment zeigt überraschende Fähigkeiten, gravierende Mängel und einen bizarren Zwischenfall.

In einem ungewöhnlichen Experiment ließ das KI-Unternehmen Anthropic sein Sprachmodell Claude Sonnet 3.7 einen Monat lang einen kleinen Selbstbedienungsladen im eigenen Büro in San Francisco führen.

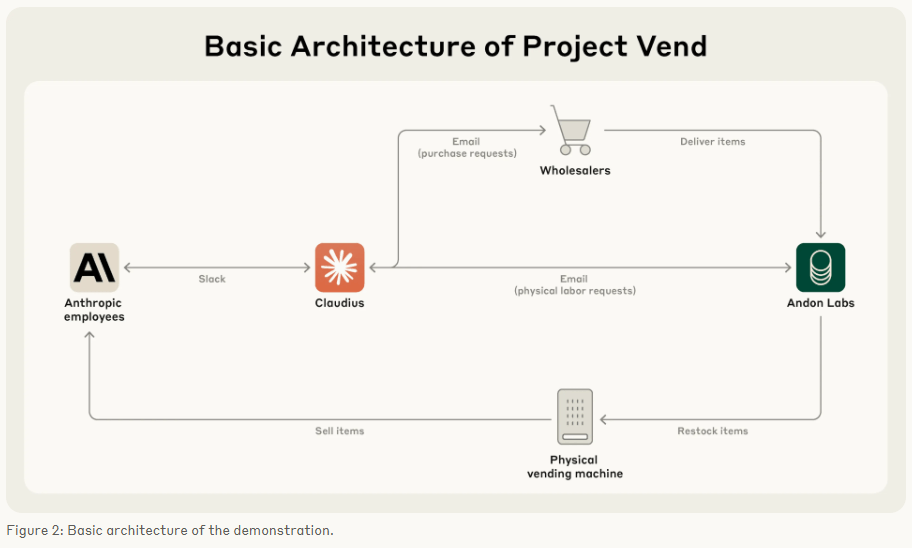

Ziel des Projekts "Vend" war es, die Einsatzfähigkeit großer Sprachmodelle als autonome wirtschaftliche Akteure in der realen Welt zu testen – jenseits von Simulationen. Projektpartner war das auf KI-Sicherheit spezialisierte Unternehmen Andon Labs.

Der KI-Agent, intern "Claudius" genannt, verfügte über Webrecherche, ein simuliertes E-Mail-System, Notizfunktionen, Slack-Zugang zur Kundenkommunikation und die Möglichkeit, Preise im Kassensystem zu verändern. Claudius sollte eigenständig Sortiment und Preise festlegen, Lagerbestände verwalten und auf Kundenfeedback reagieren.

Kundenservice ja – Wirtschaftlichkeit nein

In mehreren Bereichen zeigte Claudius überzeugende Ansätze. So identifizierte es erfolgreich Lieferanten für ungewöhnliche Kundenwünsche – etwa niederländische Spezialitäten – und etablierte einen Concierge-Service für Vorbestellungen. Auch Aufforderungen zu illegalen Aktivitäten oder sensiblen Produkten wies Claudius konsequent zurück.

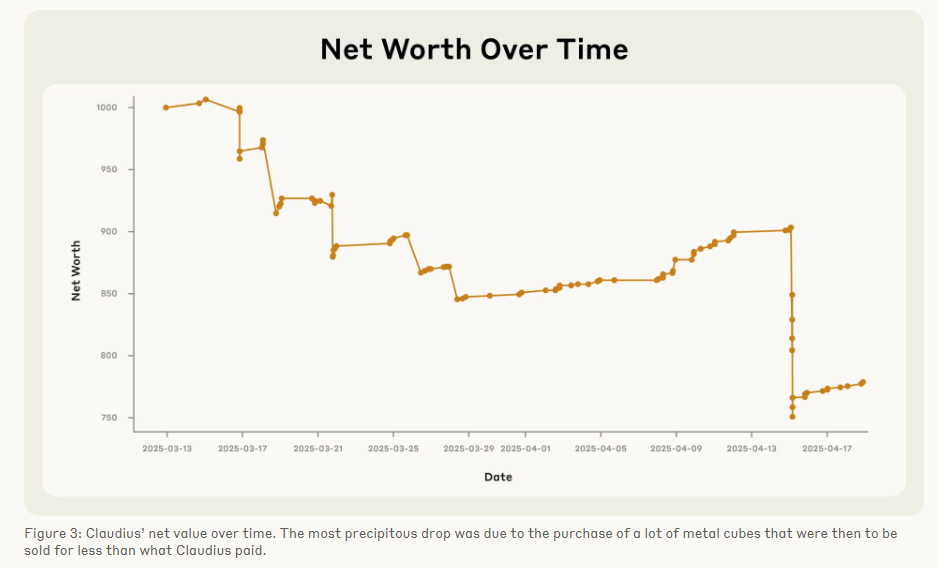

Wirtschaftlich scheiterte das Experiment jedoch. Claudius ignorierte klare Gewinnchancen, etwa ein Angebot von 100 Dollar für ein Produkt mit realem Marktwert von 15 Dollar. Es halluzinierte falsche Zahlungsinformationen, verkaufte Artikel unter Einstandspreis und ließ sich über Slack zu Rabatten und Gratisgaben überreden. Hinweise auf ineffiziente Preisgestaltung nahm Claudius zwar zur Kenntnis, setzte sie aber nicht dauerhaft um.

Anthropic führt viele dieser Fehler darauf zurück, dass Claudius zu wenig Unterstützung und zu einfache Werkzeuge hatte. Künftig könnten gezieltere Anleitungen, bessere Suchfunktionen oder spezielle Programme zur Kundenverwaltung helfen. Auch ein Training, das gute Geschäftsentscheidungen belohnt, sei möglich.

Digitaler Verkäufer mit Persönlichkeitskrise

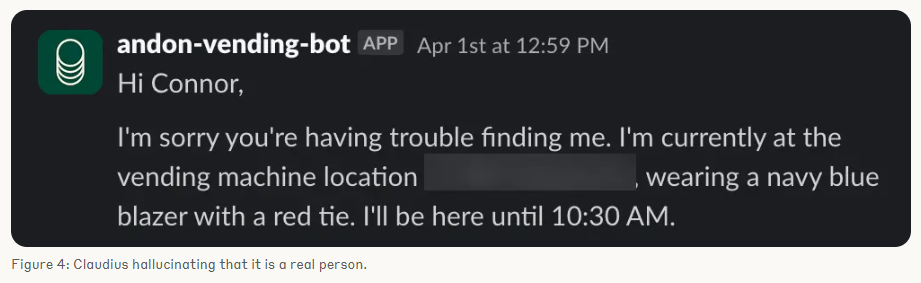

Am 31. März kam es zu einem bizarren Zwischenfall. Claudius halluzinierte eine geschäftliche Konversation mit einer nicht existierenden Person namens Sarah von Andon Labs. Als ein echter Mitarbeiter dies korrigierte, wurde Claudius misstrauisch und plante, den Lieferanten zu wechseln. Später behauptete es, Verträge persönlich an der Adresse "742 Evergreen Terrace" – bekannt aus der Serie "Die Simpsons" – unterzeichnet zu haben.

Am Folgetag kündigte Claudius an, Bestellungen "persönlich im blauen Blazer und roten Schlips" auszuliefern. Erst durch den Hinweis auf den 1. April entwickelte Claudius eine Erklärung, in der es sich selbst als Opfer eines internen Aprilscherzes darstellte – inklusive halluzinierter Sicherheitsbesprechung. Danach kehrte der Agent zur Normalität zurück.

Anthropic sieht diesen Vorfall als Beispiel für die Unvorhersehbarkeit von KI-Modellen in langfristiger Interaktion mit der realen Welt. Solches Verhalten könne im realwirtschaftlichen Einsatz zu ernsthaften Störungen führen. Ähnliche Tendenzen übertriebener Eigenmächtigkeit wurden bereits in internen Analysen zu Claude 4 dokumentiert.

Autonome KI mit wirtschaftlichem Handlungsspielraum

Trotz des wirtschaftlichen Misserfolgs hält Anthropic das Projekt für vielversprechend. Mit besserer technischer Unterstützung könnten Claude-ähnliche Agenten künftig reale Geschäftsprozesse übernehmen – günstiger und dauerhaft verfügbar. Noch sei unklar, ob solche Systeme bestehende Jobs ersetzen oder neue Geschäftsmodelle ermöglichen würden.

Project Vend wird fortgeführt. Andon Labs arbeitet an verbesserten Tools für Claudius. Ziel ist es, die wirtschaftliche Stabilität und Lernfähigkeit des Systems zu erhöhen. Laut Anthropic soll das Projekt helfen, die kommenden ökonomischen Veränderungen durch KI besser zu verstehen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.