KI trifft Livestream: Decart stellt Plattform für schnelle und interaktive Videotransformation vor

Das Start-up Decart hat mit MirageLSD ein KI-Video-Modell entwickelt, das Live-Video-Feeds ohne Verzögerung transformiert. Das System soll zwei grundlegende Probleme bisheriger KI-Video-Technologie lösen.

Bisherige KI-Modelle benötigen viel Zeit zur Erstellung von Videos und erzeugen meist nur kurze Clips mit fünf bis zehn Sekunden Länge, bevor die Bildqualität abnimmt.

MirageLSD soll laut Decart als "Livestream Diffusion KI-Video-Modell" in der Lage sein, einen Livestream ohne signifikante Verzögerung zu transformieren. Das Modell generiert 20 Bilder pro Sekunde bei einer Auflösung von 768 × 432 Pixeln.

Echtzeit-Generierung Bild für Bild

Statt komplette Videosequenzen auf einmal zu erzeugen, erstellt MirageLSD jedes Einzelbild (Frame) nacheinander. Dabei verwendet es ein Fenster aus den zuletzt generierten Bildern, den aktuellen Bildinput sowie den Benutzer-Prompt, um den nächsten Frame vorherzusagen – und das in Echtzeit. Dieser neue Frame fließt sofort wieder in den nächsten Berechnungsschritt ein. So kann das System fortlaufend auf neue Eingaben reagieren, ohne Verzögerung.

Training gegen Qualitätsverlust

Um eine längere und stabilere Bildsequenz zu ermöglichen, nutzt Decart zwei Trainingsmethoden. Bei der ersten, "Diffusion Forcing" genannt, wird jedem Frame einzeln Rauschen hinzugefügt. Das Modell lernt so, einzelne Bilder ohne Kontext zu bereinigen – das verhindert, dass sich Fehler von Frame zu Frame aufbauen.

Die zweite Methode, "History Augmentation", konfrontiert das Modell im Training bewusst mit fehlerhaften oder verzerrten Bildern. So lernt es, typische Fehler in früheren Frames zu erkennen und zu korrigieren, statt sie zu übernehmen.

Optimierung für niedrige Latenz

Für die nötige Rechenleistung hat Decart das System speziell für Nvidia-Hopper-GPUs optimiert.Bei "Architecture-aware Pruning" wird das Modell gezielt so umgebaut, dass es besonders gut auf die verwendete Hardware passt. Das bedeutet, weniger wichtige Teile des Modells werden entfernt, damit es schneller und effizienter arbeitet.

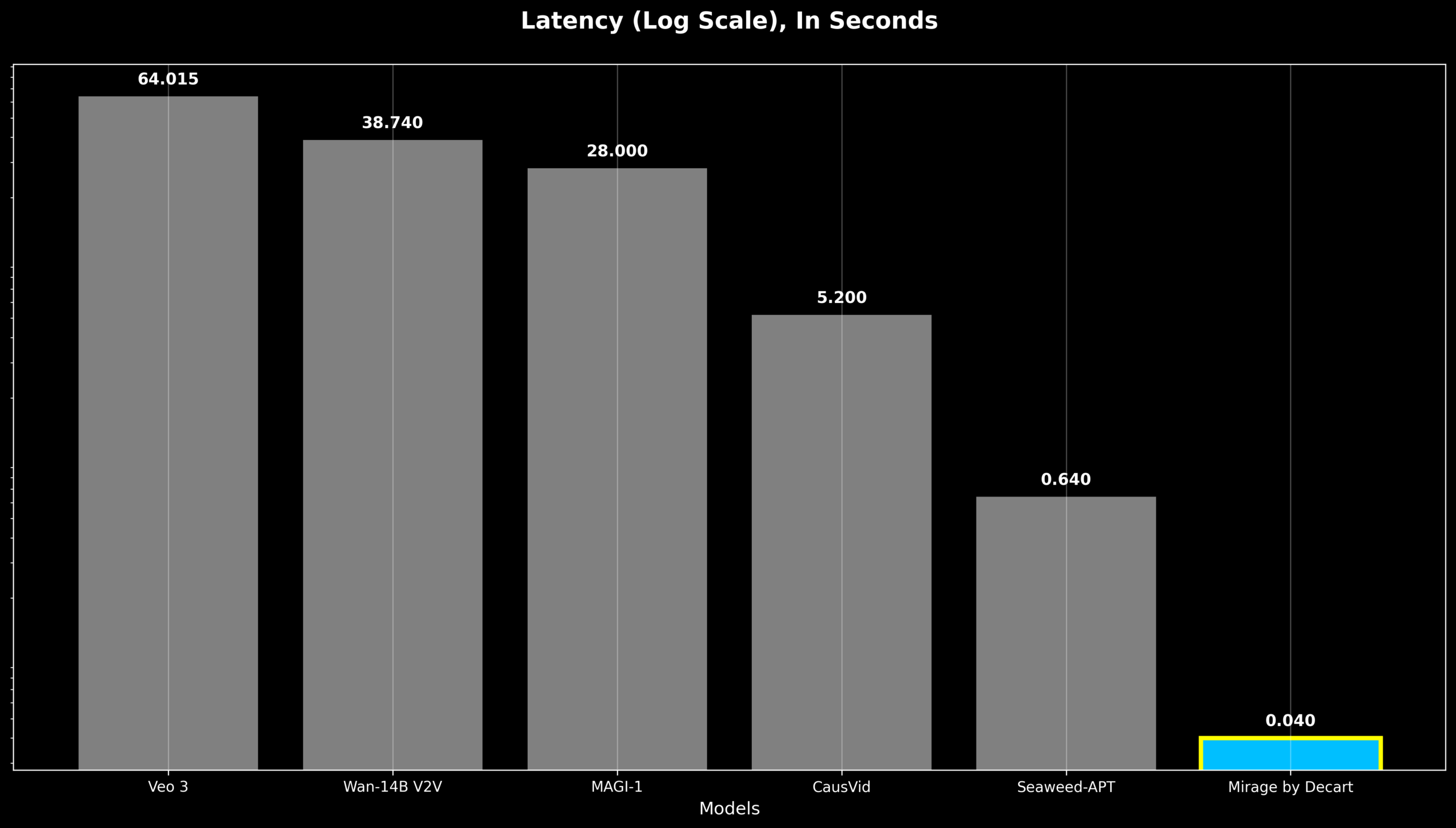

Zusätzlich kommt "Shortcut Distillation" zum Einsatz – ein Verfahren, bei dem kleinere Modelle trainiert werden, die Ergebnisse größerer Modelle effizient nachzubilden. Laut Decart ergibt sich so eine 16-fache Leistungssteigerung. Die Verarbeitung eines einzelnen Frames dauert weniger als 40 Millisekunden. Das sei die Grenze, ab der das menschliche Auge Verzögerungen als störend wahrnimmt.

Plattform gestartet, Apps kommen

Decart hat parallel die Plattform Mirage entwickelt, die auf dem MirageLSD-Modell basiert. Sie soll Anwendungen in Bereichen wie Live-Streaming, Video-Telefonie und Gaming ermöglichen. Die Website ist bereits online, mobile Apps für iOS und Android sollen in Kürze folgen.

Für den Sommer plant das Unternehmen regelmäßige Updates mit zusätzlichen Features wie verbesserter Gesichtskonsistenz, Sprachsteuerung und präziserer Objektkontrolle.

Aktuell verarbeitet MirageLSD nur eine begrenzte Anzahl vergangener Bilder, was die Konsistenz bei langen Videosequenzen einschränkt. Auch bei starken Stilwechseln oder der gezielten Steuerung einzelner Objekte stößt das System noch an Grenzen.

Das System ist das zweite KI-Modell von Decart nach dem viralen AI Minecraft-Projekt Oasis. Die Entwicklung dauerte etwa ein halbes Jahr. Andere neue Systeme wie StreamDiT erreichen vergleichbare Geschwindigkeiten von bis zu 16 Bildern pro Sekunde und reagieren ebenfalls interaktiv. In Bezug auf Bildqualität bleiben sie jedoch hinter aktuellen Top-Modellen wie Googles Veo 3 zurück.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.