Alibaba veröffentlicht mit "Qwen3-Coder" sein bisher "agentischstes" Coding-Modell

Das chinesische Unternehmen Alibaba hat ein neues KI-Modell für Programmieraufgaben vorgestellt. Das bisher "agentischste" Code-Modell soll bei verschiedenen Programmieraufgaben mit führenden westlichen Modellen konkurrieren.

Die Hauptversion Qwen3-Coder-480B-A35B-Instruct basiert auf einer Mixture-of-Experts-Architektur mit 480 Milliarden Parametern, von denen 35 Milliarden gleichzeitig aktiv sind. Das Modell unterstützt nativ ein Kontextfenster von bis zu 256.000 Token, kann aber auf eine Million Token erweitert werden. Das sollte für kleine bis mittelgroße Coding-Projekte ausreichen. Im April hatte Alibaba die Qwen3-Familie für allgemeine Aufgaben vorgestellt.

Training mit 7,5 Billionen Token, 70 Prozent Code

Für das Pre-Training verwendete Alibaba 7,5 Billionen Token, davon 70 Prozent Code-Inhalte. Das Unternehmen nutzte das im November vorgestellte Vorgängermodell Qwen2.5-Coder, um Daten zu bereinigen und umzuschreiben.

Im Post-Training setzte Alibaba auf Long-Horizon Reinforcement Learning. Dabei lernt das Modell durch mehrstufige Interaktionen mit der Umgebung, Tools zu verwenden und Feedback zu verarbeiten. Alibaba hat dafür ein System gebaut, das 20.000 unabhängige Umgebungen parallel auf der Alibaba Cloud ausführt.

Demos, bei denen die KI physikalische Gesetze berücksichtigen muss, sind beliebtes Testgelände für Coding-Modelle. Qwen3-Coder scheint diese Aufgabe gut zu lösen. | Video: Alibaba

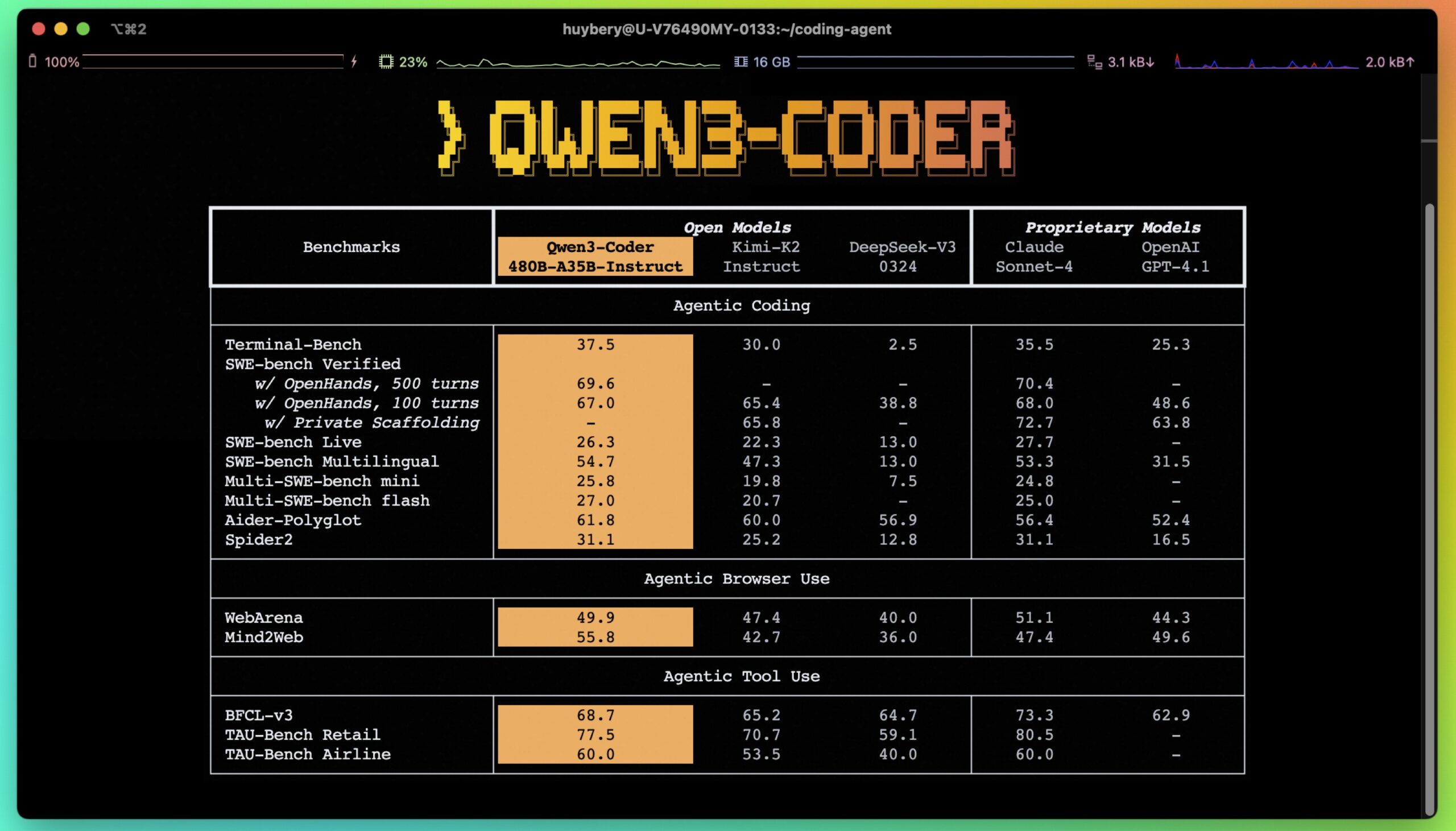

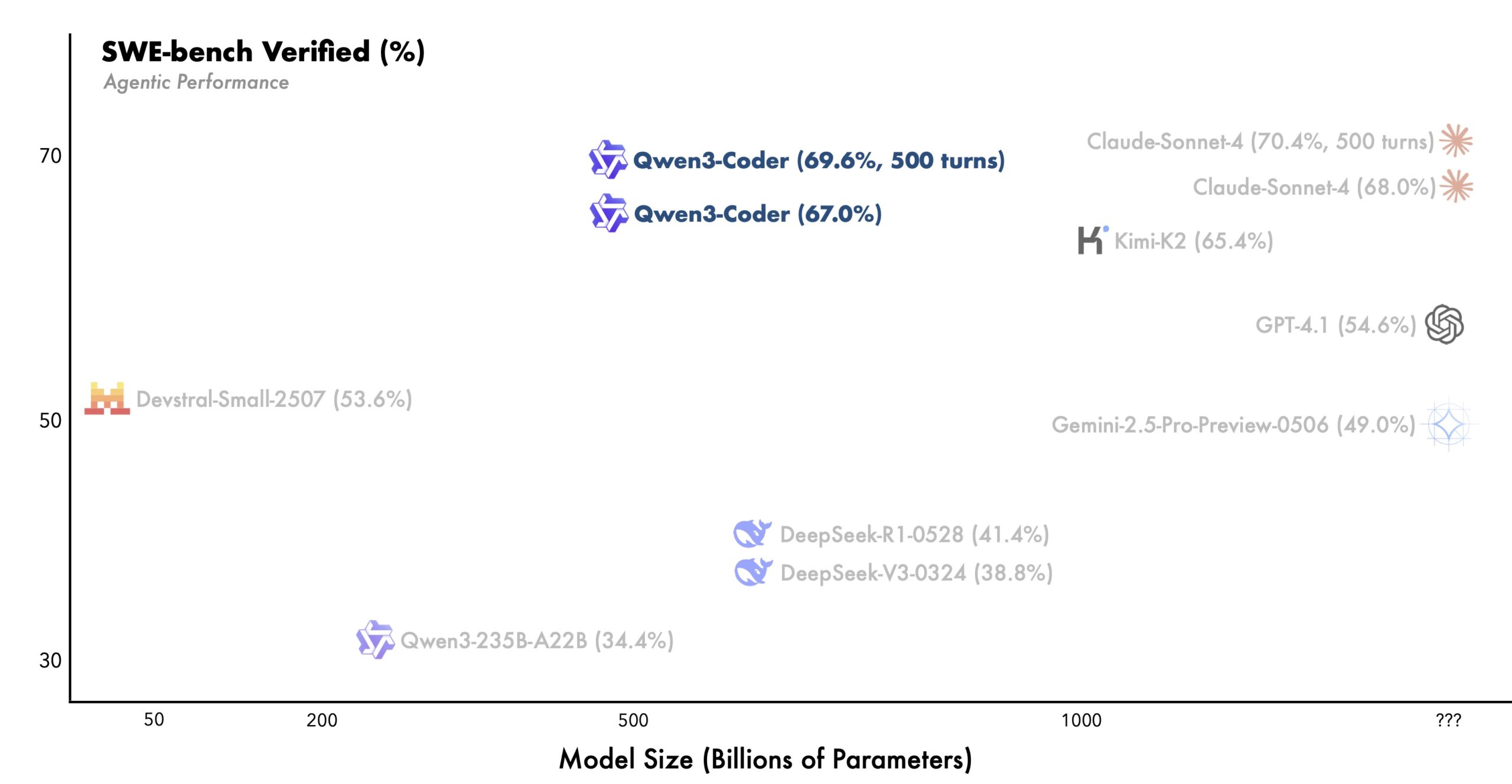

Nach Alibabas Angaben erreicht Qwen3-Coder Spitzenleistung unter Open-Source-Modellen bei agentenbasiertem Coding, Browser-Nutzung und Tool-Verwendung. Das Unternehmen behauptet, die Leistung sei vergleichbar mit Claude Sonnet 4.

Bei SWE-Bench Verified, einem Standard-Benchmark für Software-Engineering-Aufgaben, erreicht Qwen3-Coder nach Alibabas Angaben state-of-the-art Leistung unter Open-Source-Modellen. Dabei verzichtet das Modell auf Test-Time-Scaling, bei dem ein Modell während der Anwendung zusätzliche Rechenzeit für bessere Ergebnisse nutzt.

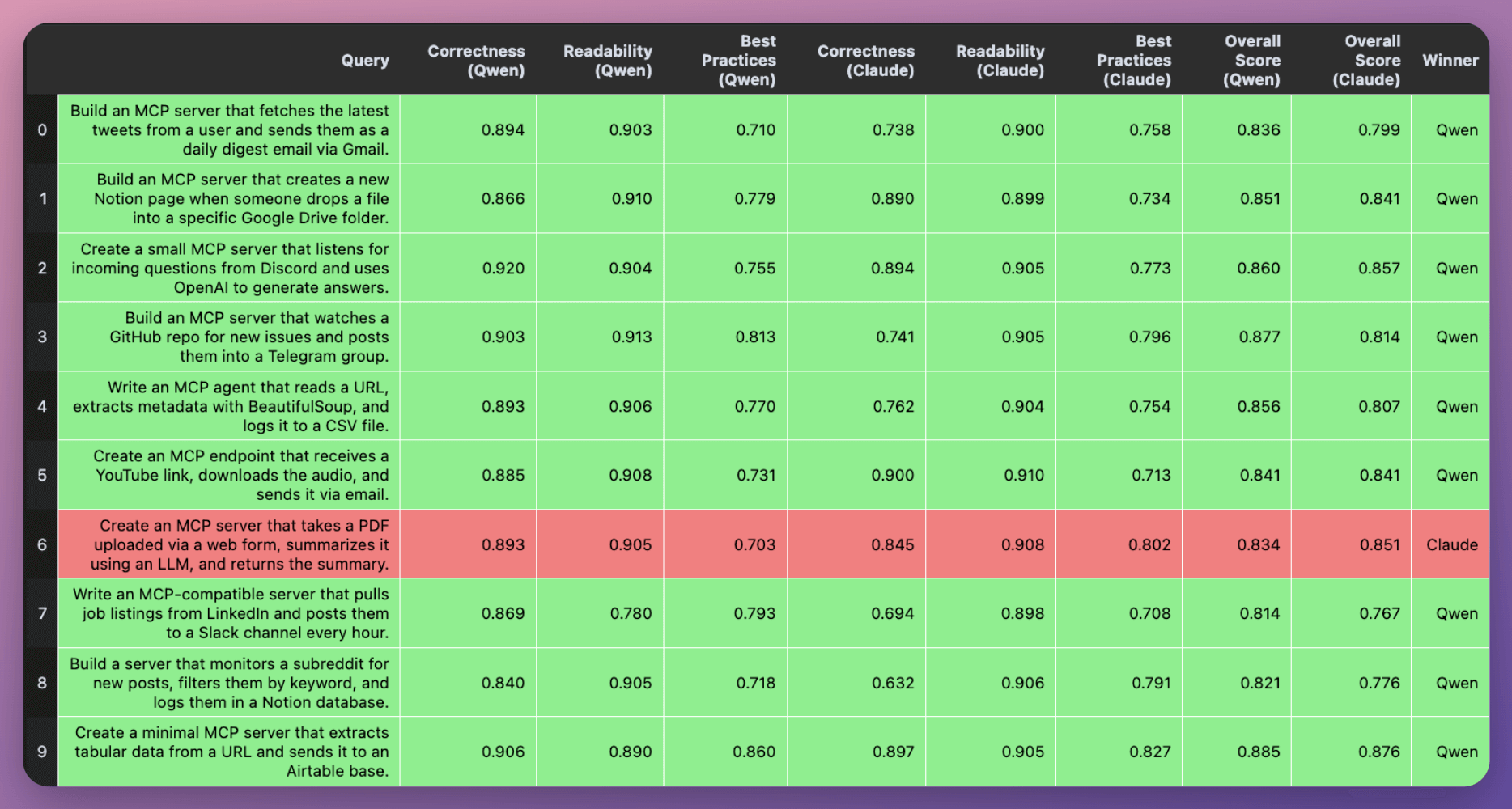

Die gute Leistung wird durch externe Tests bestätigt. X-Nutzer Avi Chavla hat Qwen3-Coder gegen Claude Sonnet 4 in mehreren Aufgaben systematisch gegeneinander antreten lassen. Bei zehn Problemstellungen, die die Entwicklung verschiedener Arten von MCP-Servern enthielten, trug Qwen in neun Fällen den Sieg nach Hause und zeigte durchgehend einen höheren Korrektheit-Wert.

Kommandozeilen-Tool Qwen Code

Zusätzlich zum Modell veröffentlicht Alibaba "Qwen Code", ein Kommandozeilen-Tool für Entwickler:innen. Es basiert auf Gemini Code, wurde aber mit angepassten Prompts und Funktionsaufruf-Protokollen für Qwen3-Coder optimiert. Außerdem unterstützt es das OpenAI-SDK und lässt sich über Umgebungsvariablen konfigurieren.

Qwen3-Coder kann auch mit bestehenden Entwicklertools verwendet werden. Für Claude Code benötigen Nutzer einen API-Schlüssel von Alibaba Cloud Model Studio.

Weitere Modellgrößen geplant

Alibaba arbeitet an weiteren Versionen von Qwen3-Coder in verschiedenen Größen. Diese sollen starke Leistung bei reduzierten Deployment-Kosten bieten. Das Unternehmen erforscht zudem, ob Coding-Agenten sich selbst verbessern können. Das angebotene 480B-Modell ist für handelsübliche Grafikkarten noch viel zu groß, Alibaba bietet jedoch API-Zugang über das Alibaba Cloud Model Studio.

Mit dieser Veröffentlichung positioniert sich Alibaba klar als Alternative zu proprietären Coding-Assistenten westlicher Anbieter wie Anthropic oder Google. Großer Unterschied ist jedoch die Open-Source-Strategie.

Angesichts der im Coding zwangsweise hohen Zahl genutzter Token, wenn etwa Dokumentationen oder Programmbibliotheken eingelesen werden müssen, steigen auch API-Kosten oder Nutzer:innen sehen sich gezwungen, direkt zu teuren 200-Dollar-Tarifen zu greifen. Qwen3-Code könnte aufgrund seiner Leistung die Konkurrenz unter Druck setzen, die Preise zu verringern.

Auf GitHub und Hugging Face finden sich Code und Gewichte, um die Modelle lokal auszuführen. Außerdem existiert eine Demo, mit der sich durch Chats kleine Web-Apps entwickeln lassen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.