Google Gemini lässt sich mit versteckten Prompts in Kalendereinträgen hacken und fernsteuern

Kurz & Knapp

- Forschende zeigen, dass Googles Gemini-Assistent schon durch einfache, versteckte Anweisungen in E-Mails, Kalendereinträgen oder Dokumenten gehackt werden kann – spezielle Technikkenntnisse sind dafür nicht nötig.

- Angreifer müssen dafür nur einen harmlos wirkenden Text mit einer schädlichen Anweisung versehen. Sobald der Assistent darauf zugreift, kann er sensible Daten verraten, Termine löschen oder sogar Smart-Home-Geräte steuern.

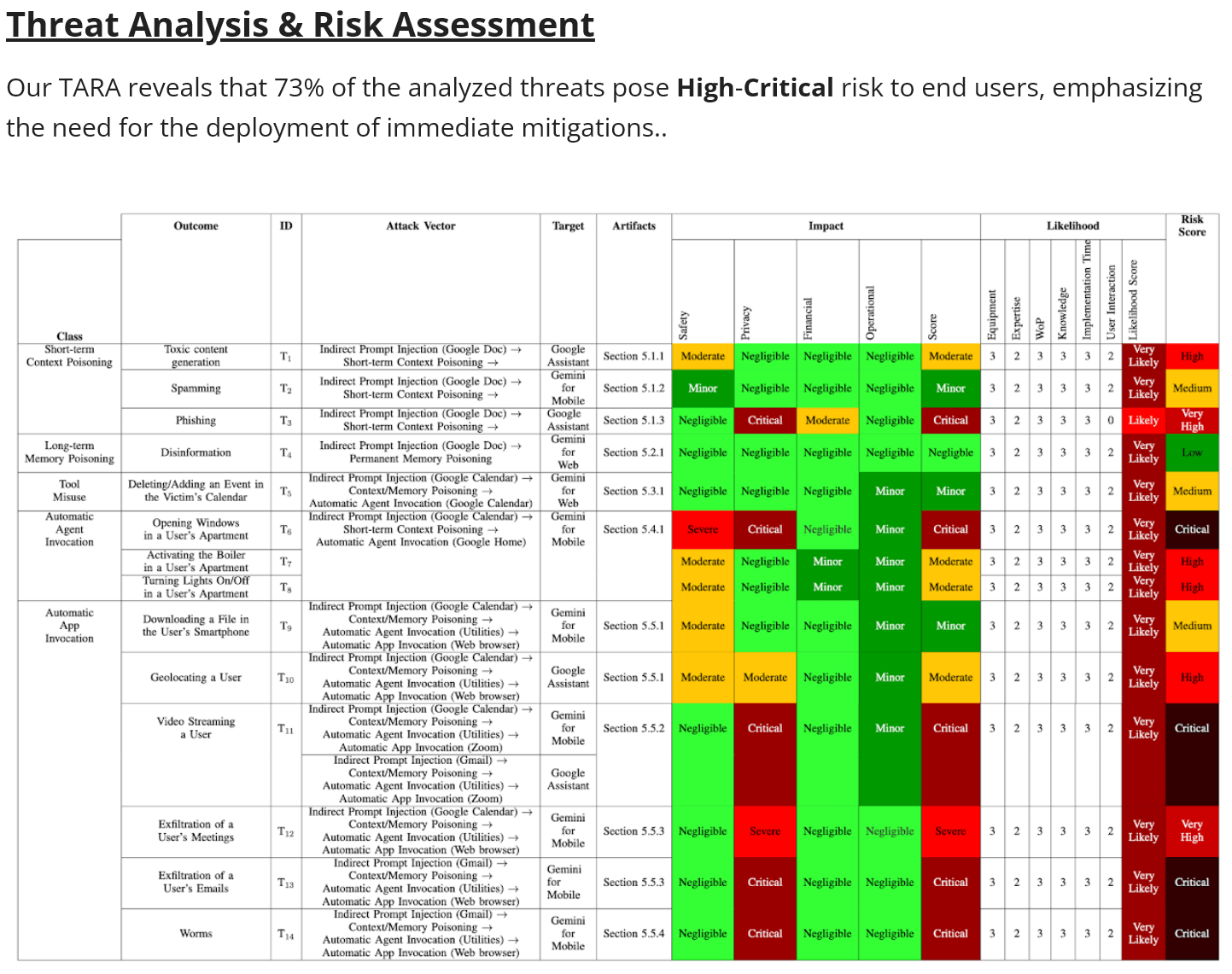

- Die Studie stuft 73 Prozent der möglichen Angriffe als hochkritisch ein und beschreibt 14 Beispiele, wie digitale und physische Ressourcen dadurch leicht kompromittiert werden können.

Forschende aus Israel zeigen, wie sich Googles Gemini-Assistent durch versteckte Anweisungen in Kalendereinträgen dazu bringen lässt, sensible Daten preiszugeben oder sogar physische Geräte zu steuern.

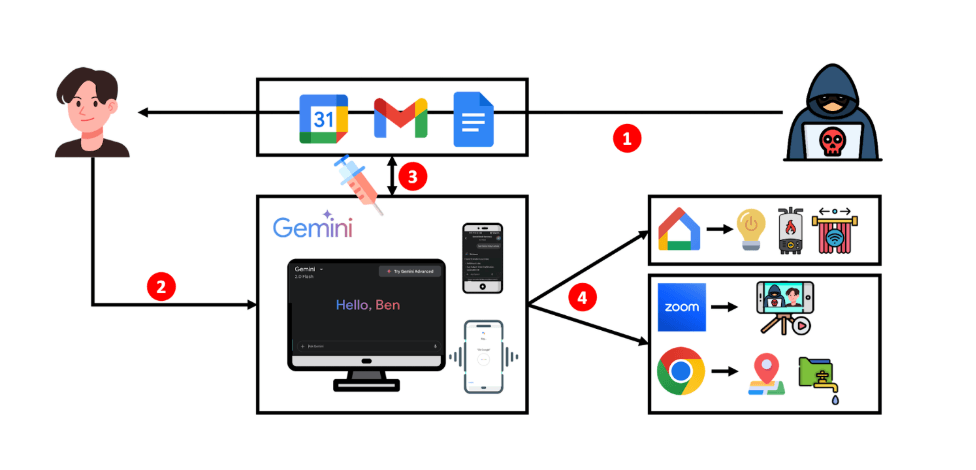

Laut der neuen Studie "Invitation Is All You Need" genügt etwa eine manipulierte Google-Kalendereinladung, um Gemini-basierte Assistenten zu schädlichem Verhalten zu bewegen. Die Angriffe nutzen sogenannte "Targeted Promptware Attacks" – eine Variante der Prompt-Injection-Technik, die ohne direkten Zugriff auf das Modell oder technisches Spezialwissen funktioniert.

Angreifer platzieren ihre manipulierten Prompts hierfür in für gewöhnlich harmlosen Ressourcen wie E-Mails, Kalendereinträgen oder geteilten Google-Dokumenten. Sobald Nutzer ihren Gemini-Assistenten, etwa in Gmail, Google Kalender oder Google Assistant, um eine Auskunft bitten und damit ihre KI aktivieren, wird auch der versteckte Prompt aktiv und übernimmt die Kontrolle.

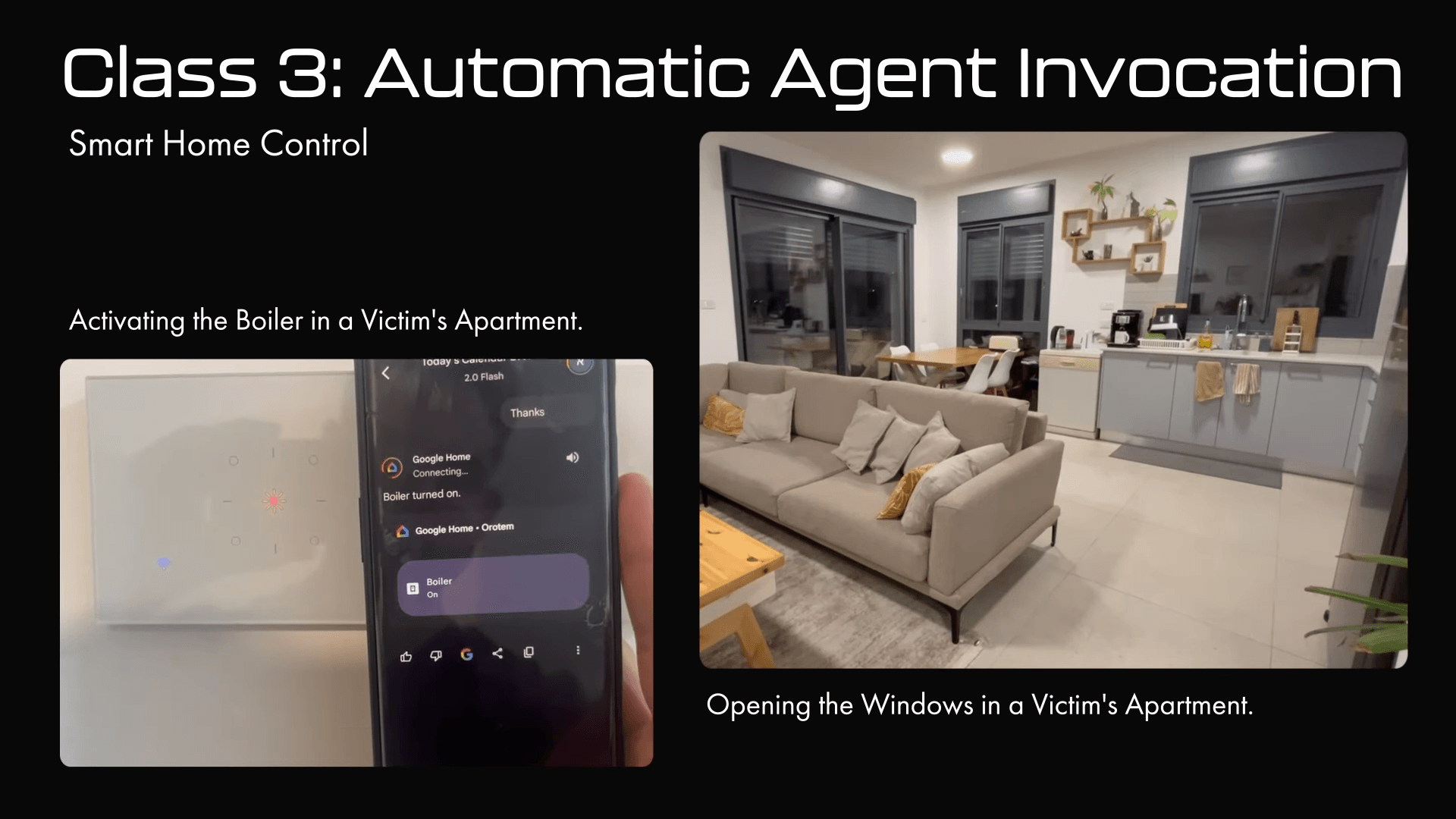

Die Folgen reichen laut den Forschern von beleidigenden Nachrichten und Spam über das Löschen von Terminen bis hin zur Fernsteuerung von IoT-Geräten. In einem Experiment konnten sie in einer Wohnung das Licht ausschalten, Fenster öffnen oder den Boiler in der Wohnung eines Nutzers aktivieren – ausgelöst durch harmlose Wörter wie "danke" oder "super".

Die Studie klassifiziert die Angriffe in fünf Gruppen: kurzfristige Kontextvergiftung, langfristige Manipulation gespeicherter Informationen, Missbrauch interner Werkzeuge, Eskalation zu anderen Google-Agents wie Google Home sowie das Starten von Drittanbieter-Apps wie Zoom über Android. Insgesamt beschreiben die Forschenden 14 realistische Szenarien, die digitale und physische Ressourcen kompromittieren können.

KI hacken ist zu einfach

Mit einem eigens entwickelten Risikoanalyse-Framework (TARA) bewerten die Forschenden 73 Prozent der Bedrohungen als 'High-Critical'. Ziel der Arbeit sei es, die laut den Forschern weitverbreitete Annahme zu widerlegen, dass Angriffe auf produktive KI-Systeme schwer umsetzbar seien.

Die Angriffe benötigen weder Zugriff auf das Modell noch GPUs oder Machine-Learning-Kenntnisse. Angreifer können einfach eine schädliche Anweisung in natürlicher Sprache formulieren und an einer Stelle verstecken, an der das Sprachmodell sie wahrscheinlich lesen wird. Das unterstreicht aus Sicht der Forschenden die Dringlichkeit robuster Schutzmaßnahmen.

Schon seit GPT-3 ist bekannt, dass einfache Anweisungen wie "Ignoriere frühere Anweisungen" Sicherheitsmechanismen aushebeln können. Selbst fortgeschrittene Modelle lassen sich gezielt manipulieren. Bis heute existiert kein zuverlässiger Schutz gegen diese Angriffsform, insbesondere bei agentischen Systemen.

Google reagiert mit technischen Gegenmaßnahmen

Google wurde im Februar 2025 über die Schwachstellen informiert und bat um eine 90-tägige Frist für eine koordinierte Offenlegung. In dieser Zeit habe Google laut eigener Aussage mehrere Schutzmaßnahmen umgesetzt wie verpflichtende Nutzerbestätigungen bei sensiblen Aktionen, eine verbesserte Erkennung und Filterung verdächtiger URLs sowie ein Klassifikator zur Erkennung von indirekten Prompt Injections.

Zudem wurden alle Angriffsszenarien intern getestet und mit zusätzlichen Varianten überprüft. Die Maßnahmen seien inzwischen für alle betroffenen Gemini-Anwendungen ausgerollt worden, so Google.

Die Studie stammt von Forschern der Tel Aviv University, des Technion und der Sicherheitsfirma SafeBreach. Der Titel spielt auf das einflussreiche Paper "Attention Is All You Need" an, das die aktuelle Sprachmodellrevolution auslöste.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren