Googles KI-Umweltstudie verharmlost Energieverbrauch und schönt CO₂-Werte

Kurz & Knapp

- Google gibt an, dass eine typische Textanfrage an Gemini lediglich 0,24 Wattstunden und 0,03 Gramm CO₂ verursacht – Werte, die sich auf einfache Einzelanfragen beziehen und so den Eindruck eines geringen Ressourcenverbrauchs vermitteln.

- Die Studie ignoriert jedoch die Auswirkungen der Skalierung: Die eigentliche Umweltbelastung entsteht erst durch Milliarden von Anfragen täglich, energieintensive Spezialfälle sowie die Integration in zahlreiche Google-Produkte und lang rechnende KI-Modelle. Diese Faktoren werden in der Methodik ausgeklammert und im Ergebnis nicht transparent gemacht.

- Während Google deutliche Effizienzsteigerungen und eine starke Reduktion des CO₂-Ausstoßes pro Anfrage meldet, bleibt unklar, wie sich die tatsächliche Gesamtlast durch das rapide steigende Anfragevolumen und anspruchsvolle KI-Anwendungen entwickelt.

Google sorgt mit einer neuen Studie zum Energieverbrauch seines KI-Assistenten Gemini für Aufsehen: Eine typische Textanfrage soll lediglich 0,24 Wattstunden benötigen – weniger als neun Sekunden Fernsehen.

Der Vergleich ist eingängig und genau deshalb ein klassisches PR-Manöver: Er verharmlost das Problem der Skalierung durch den Fokus auf eine winzige, harmlose Einzelaktion, die die systemische Gesamtlast verschleiert. Denn die wahre Umweltlast entsteht nicht durch eine einzelne Anfrage, sondern durch die Summe von Milliarden solcher Interaktionen täglich. Niemand schaut neun Sekunden TV oder schickt nur eine kurze Nachricht an einen Chatbot.

Google präsentiert die Untersuchung dennoch als ersten umfassenden Ansatz, der den gesamten Energieverbrauch von KI-Systemen in einer realen Produktionsumgebung misst. Das Ergebnis für eine typische Anfrage: Neben den bereits erwähnten 0,24 Wattstunden Energie sollen auch die CO₂-Emissionen mit 0,03 Gramm gering ausfallen und der Wasserverbrauch mit 0,26 Millilitern nur etwa fünf Tropfen betragen.

Was Google alles nicht misst

Googles Vorstoß in Richtung Transparenz ist grundsätzlich zu begrüßen – doch die gewählte Methodik wirft zahlreiche Fragen auf. Ein zentraler Kniff besteht darin, den Fokus auf die "typische" Anfrage mit "Gemini App"-Modellen zu legen. Was bedeutet das?

Die Studie schweigt sich über die durchschnittliche Länge der Anfragen (Token-Zahl) aus und verrät nicht, wie energieintensive Aufgaben bewertet werden. Die wahren Energiefresser des KI-Alltags – das Analysieren hochgeladener Dokumente und Medien, die Generierung von Bildern, die Transkription von Audio, Live-Video-Funktionen mit Gemini Live, komplexe, agentische Websuchen oder anspruchsvolle Code-Generierung – werden durch die Wahl des Medians und die Beschränkung auf Text statistisch an den Rand gedrängt. Indem Google nur den typischen Wert für eine einfache Textanfrage ausweist, bleiben die Kosten für diese anspruchsvollen Grenzfälle, die den Durchschnittswert mutmaßlich nach oben treiben würden, im Dunkeln.

Hinzu kommt: Googles KI-Funktionen sind längst nicht auf die Gemini-App beschränkt, sondern finden auch in Produkten wie der Google-Suche Anwendung. Der tatsächliche Skalierungsfaktor dürfte also weit über das hinausgehen, was die Studie abbildet.

Gerade die neuesten KI-Modelle nutzen oft spezielle "Reasoning-Token" für logische Schlussfolgerungen, die den Verbrauch sprunghaft ansteigen lassen können. Google hat laut eigenen Angaben im Juni über 980 Billionen Token über seine KI-Produkte und APIs verarbeitet, mehr als doppelt so viel wie im Mai. Reasoning-Modelle dürften hierfür verantwortlich sein, Google spricht in seinem Paper allerdings nur von Messungen mit "Gemini App"-Modellen, was erneut Fragen zur Transparenz aufwirft.

Zudem dürften Token-intensivere Anfragen, insbesondere wenn sie über Text hinausgehen, die gewaltige Netzwerkinfrastruktur, die für die Kommunikation zwischen Tausenden KI-Chips benötigt wird, deutlich stärker belasten. In der Studie wird allerdings nur die Kommunikation innerhalb einzelner AI-Computer berücksichtigt. Die internen Netzwerke des Rechenzentrums sowie externe Datenpfade werden aus dem Messrahmen ausgeklammert, mit der Begründung, sie spielten bei Textanfragen keine signifikante Rolle. Bei komplexeren Aufgaben dürfte dieser Ausschluss jedoch zu einer Unterschätzung des tatsächlichen Energieaufwands führen.

Vollständig ausgeklammert bleibt zudem eine der energieintensivsten Phasen im Lebenszyklus eines KI-Modells: das Training. Dieser Prozess kann sich über Wochen oder Monate erstrecken, Tausende KI-Chips gleichzeitig auslasten und einen Strombedarf im Bereich von Gigawattstunden verursachen. Die Studie betrachtet damit lediglich den Verbrauch im Betrieb – bildlich gesprochen: den Energieeinsatz pro gefahrenem Kilometer –, nicht aber den Bau des Fahrzeugs selbst. Laut Google soll die Analyse des Trainingsaufwands in einer späteren Veröffentlichung folgen.

Auch bei der CO₂-Bilanz greift Google zu einem buchhalterischen Trick: Statt die tatsächlichen, standortbezogenen Emissionen anzugeben, rechnet das Unternehmen mit sogenannten "Market-Based"-Werten.

Diese Methode erlaubt es, den CO₂-Ausstoß rechnerisch zu senken, indem Zertifikate für erneuerbare Energien eingekauft werden, auch wenn der Strom, der tatsächlich aus der Steckdose im Rechenzentrum kommt, aus fossilen Quellen stammt. Anders als bei der "Location-Based"-Methode, die den realen Strommix am jeweiligen Standort berücksichtigt, zählt bei "Market-Based" vor allem, was auf dem Papier als "grün" gilt.

Laut Google liegt der reale, standortbezogene Emissionsfaktor fast viermal höher als der durch Zertifikate bereinigte Market-Based-Wert. Der Unterschied verringert den CO₂-Fußabdruck rechnerisch deutlich, verändert aber nichts an den tatsächlichen Emissionen vor Ort.

Beeindruckende Effizienzgewinne in einem engen Rahmen

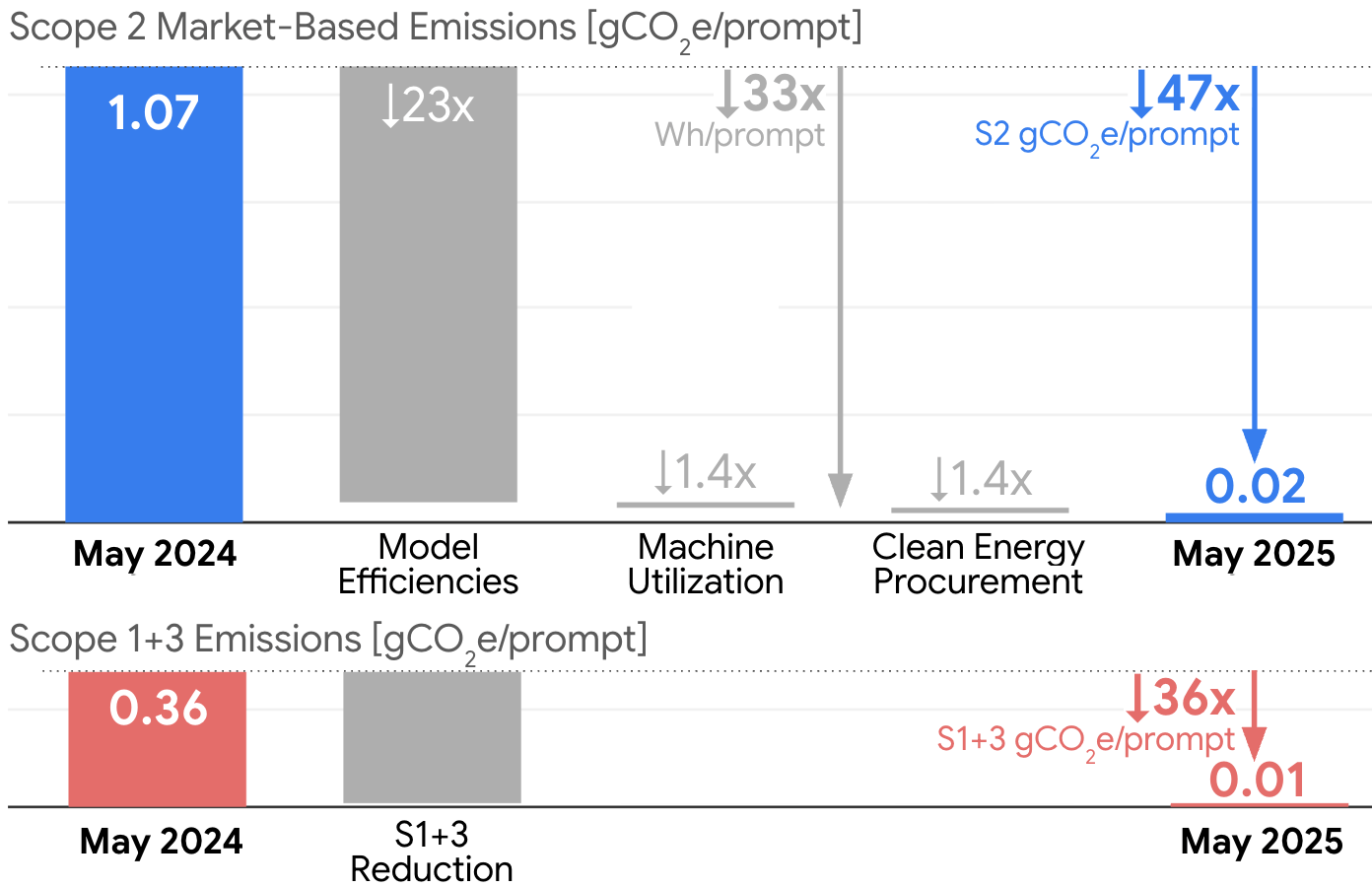

Trotz der Kritikpunkte zeigt die Studie beachtliche Fortschritte bei der Energieeffizienz. Google berichtet, den Energieverbrauch pro Anfrage binnen zwölf Monaten um das 33-fache gesenkt zu haben. Der Zukauf von sauberem Strom trug zusätzlich dazu bei, die CO₂-Emissionen pro Anfrage zu senken, was zu einer Gesamtreduktion des CO₂-Fußabdrucks um das 44-fache führte.

Dies sei allein durch Software-Effizienz gelungen: effizientere KI-Modelle und eine bessere Serverauslastung. Bei großen Anfragen aktiviert das System nach Googles Angaben nur die Teile des Modells, die tatsächlich gebraucht werden. Google gibt zudem an, dass die neuesten KI-Chips 30-mal energieeffizienter seien als die erste Generation. Die Rechenzentren arbeiteten mit einem Overhead von neun Prozent.

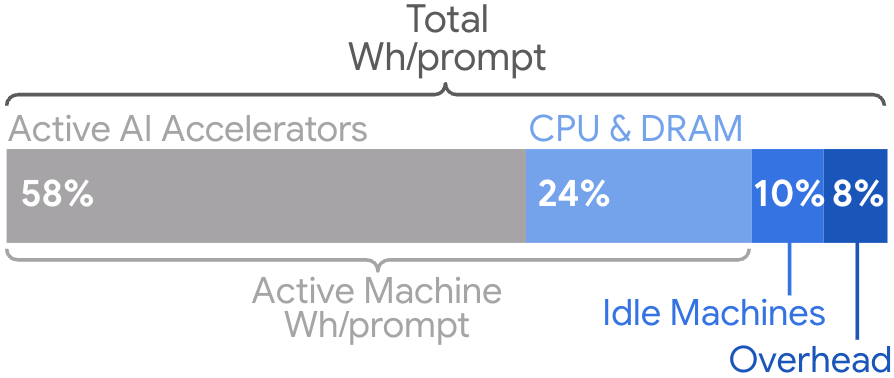

Nach Googles Aufschlüsselung verteilt sich die Energie auf verschiedene Bereiche: 58 Prozent entfallen auf die eigentlichen KI-Chips, 25 Prozent auf Arbeitsspeicher und Hauptprozessoren. Weitere 10 Prozent verbrauchen Computer im Stand-by-Modus, die für Ausfälle bereitgehalten werden. Die restlichen acht Prozent gehen für Kühlung und andere Rechenzentrumsinfrastruktur drauf.

Andere Studien kommen zu höheren Werten

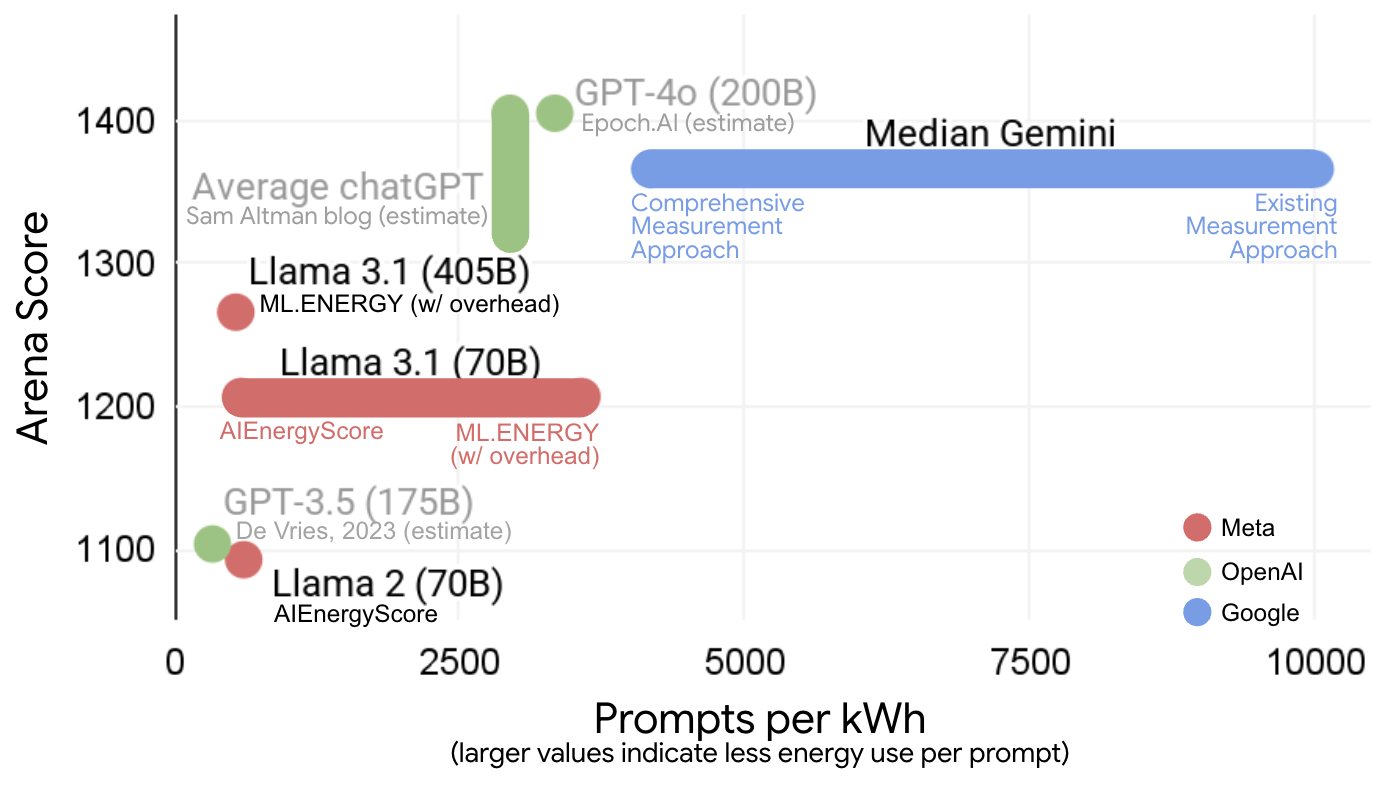

Bisherige externe Schätzungen schwankten erheblich. Verschiedene Studien kamen für ähnliche Modelle auf Werte zwischen 0,3 und 3 Wattstunden pro Anfrage. OpenAI-Chef Sam Altman gab kürzlich an, dass ChatGPT etwa 0,34 Wattstunden pro Anfrage verbraucht. Mistral hatte vor wenigen Wochen ebenfalls eine Umweltbilanz für ein großes Sprachmodell veröffentlicht, die Untersuchung kam allerdings auf deutlich höhere Werte für Emissionen und Wasserverbrauch pro Anfrage.

Google bemängelt die mangelnde Vergleichbarkeit zwischen verschiedenen Studien – ein berechtigter Einwand angesichts fehlender Standards dafür, welche energieverbrauchenden Aktivitäten in solche Berechnungen einfließen sollten. Doch ausgerechnet durch die eigene, stark optimierte und selektiv abgegrenzte Methodik trägt Google selbst zur Intransparenz bei.

Fazit: Ein unvollständiges Bild mit PR-Potenzial

Zwar mögen die Umweltkosten einer einzelnen Textanfrage auf den ersten Blick gering erscheinen. Doch die entscheidende Frage bleibt unbeantwortet: Wie hoch ist der tatsächliche Ressourcenverbrauch eines globalen KI-Betriebs, der täglich Milliarden solcher – und deutlich komplexerer – Anfragen verarbeitet? Eine Antwort darauf bleibt die Studie schuldig.

Dass es sich dabei nicht um eine theoretische Frage handelt, zeigen die gigantischen Investitionen: Billionen US-Dollar fließen weltweit in neue Rechenzentren und deren Energieversorgung. Selbst Deepmind-Chef Demis Hassabis prahlte kürzlich damit, dass bei Google wegen der hohen Nachfrage die KI-Chips schmelzen könnten – ein Bild, das kaum zur minimalistischen Energiebilanz der Studie passt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren