Metas neues Weltmodell weiß, was der Code tut, den es schreibt

Das neue Code World Model (CWM) von Meta soll Code nicht nur schreiben, sondern dabei auch verstehen, was im Computer passiert.

"Um das Programmieren zu meistern, muss man nicht nur verstehen, wie Code aussieht, sondern was er bei der Ausführung bewirkt", erklären die Meta-Forschenden. Diese Fähigkeit sei entscheidend für echtes Programmverständnis, das über das reine Nachahmen von Code-Mustern hinausgeht.

Laut Meta soll CWM zukünftig wie ein mentaler Debugger funktionieren, der das Programmverhalten simuliert, bevor auch nur eine Zeile ausgeführt wird. Das Modell kann dadurch etwa vorhersagen, ob ein Programm jemals zum Ende kommt oder in einer Endlosschleife hängen bleibt. Bei Tests mit Metas neuem HaltEval-Benchmark erreichte es dabei eine Genauigkeit von 94 Prozent.

Die KI kann sogar rückwärtsarbeiten: Gibt man ihr nur eine Beschreibung dessen, was ein Programm tun soll, simuliert sie die Ausführung und leitet daraus den passenden Code ab. Die Forschenden demonstrieren das mit Beispielen, bei denen CWM Funktionen aus Anforderungsbeschreibungen und erwarteten Ergebnissen rekonstruiert hat, ohne jemals den ursprünglichen Code gesehen zu haben.

Darüber hinaus analysiert das Modell die Komplexität von Algorithmen und kann einschätzen, wie lange ein Programm bei verschiedenen Eingabegrößen brauchen wird. Bei BigOBench erreichte es Spitzenwerte bei der Vorhersage von Zeit-Komplexitäten und rangiert auf Platz zwei der offiziellen Bestenliste. Das 32-Milliarden-Parameter-Modell übertrifft bestehende Open-Source-Alternativen ähnlicher Größe.

Training mit echten Programmausführungen

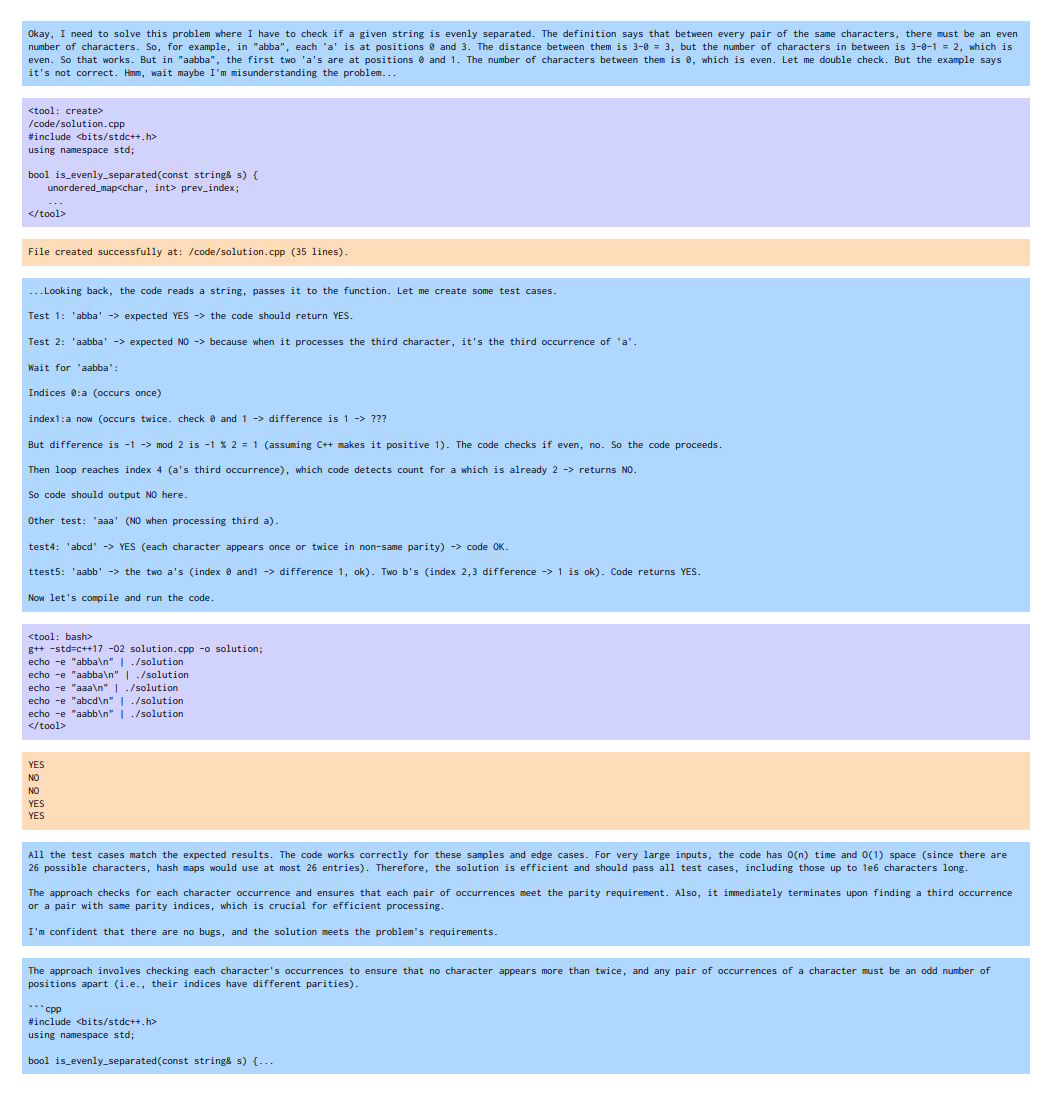

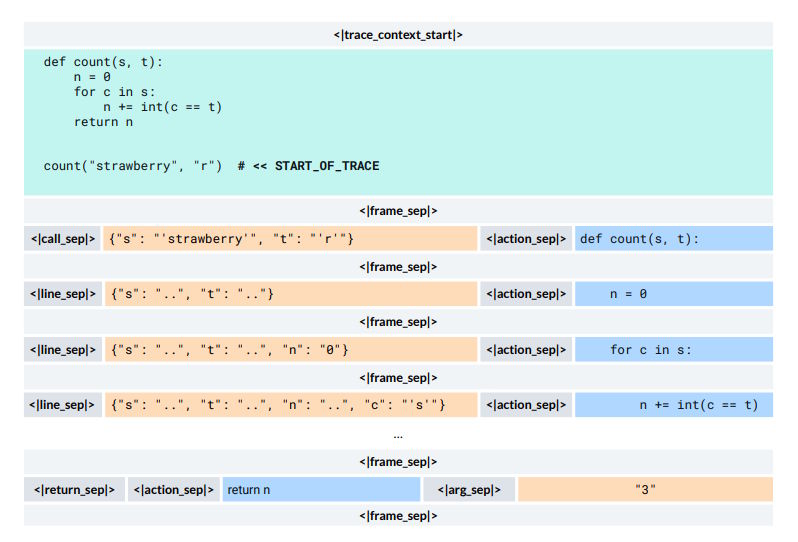

Das Modell hat aus über 120 Millionen Python-Programmausführungen gelernt, bei denen es Schritt für Schritt beobachten konnte, wie sich Variablen ändern und was in jedem Moment im Programm passiert.

Die Forschenden nennen das "Execution Traces". Das Modell analysierte im Training neben dem Code auch den Zustand lokaler Variablen nach jeder ausgeführten Zeile. Dadurch konnte es laut den Forschern die Semantik von Programmiersprachen auf eine neue Art lernen.

Für ein realistisches Training in Software-Entwicklungsumgebungen haben die Forschenden über 35 000 ausführbare Docker-Container aus GitHub-Repositories erstellt. Diese enthielten vorkonfigurierte Entwicklungsumgebungen, in denen Code und Tests ohne zusätzliche Einrichtung ausgeführt werden können.

Das Training erfolgte in drei aufeinander aufbauenden Phasen: Zunächst lernte das Modell grundlegende Programmierung auf 8 Billionen Tokens, dann die Code-Ausführung auf 5 Billionen Tokens und schließlich komplexe Aufgaben durch Reinforcement Learning in vier verschiedenen Umgebungen, die von Software-Engineering über Competitive Programming bis zu mathematischem Reasoning reichten.

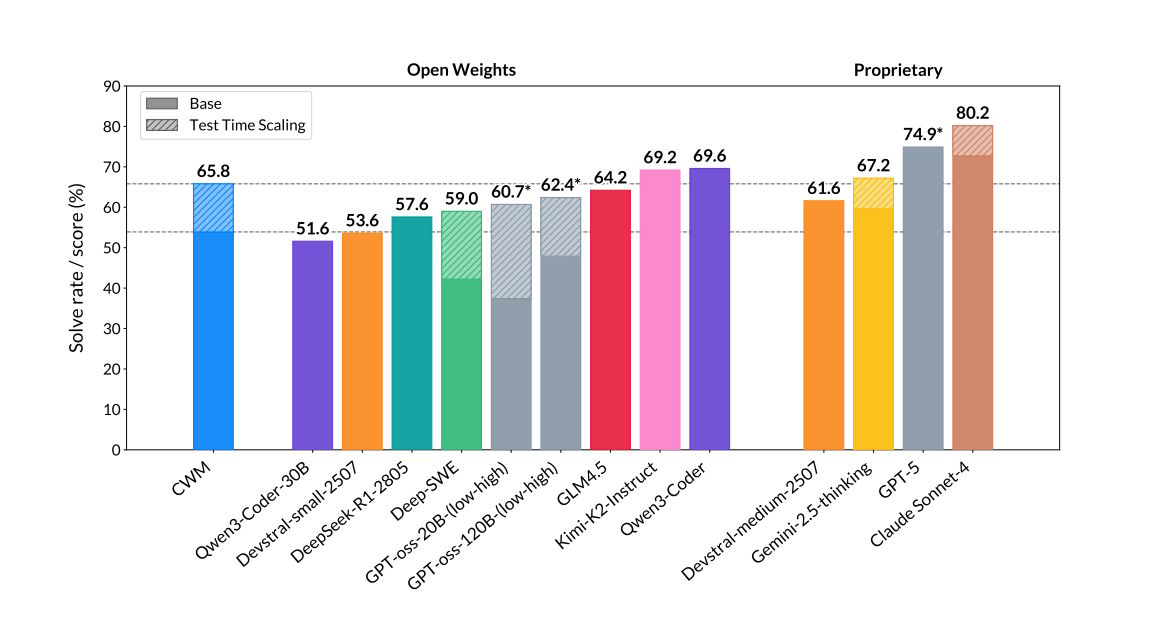

Gute Software-Benchmarks in Relation zur Größe

Diese Fähigkeiten spiegeln sich in den Benchmark-Ergebnissen wider. Bei SWE-bench Verified, einem wichtigen Test für Software-Engineering-Fähigkeiten, erreichte das 32-Milliarden-Parameter-Modell 65,8 Prozent bei Aufgaben mit Test-Time-Scaling und 53,9 Prozent in der Basisversion. Das übertrifft viele andere kleinere Open-Source-Modelle. Geschlagen wird es aber etwa von Qwen3-Coder, das mit bis zu 480 Milliarden Parametern verfügbar ist.

Bei anderen Tests zeigte CWM ähnlich starke Leistungen: 68,6 Prozent bei LiveCodeBench, 96,6 Prozent bei Math-500 und 76,0 Prozent bei der Mathematik-Olympiade AIME 2024. Bei CruxEval Output, einem Test für Code-Verständnis, erreichte das Modell im Reasoning-Modus 94,3 Prozent.

Frei verfügbar für die Forschung

Meta hat CWM als Open-Weights-Modell unter einer nicht-kommerziellen Forschungslizenz veröffentlicht und stellt sowohl das fertige Modell als auch Zwischenstufen des Trainings über Hugging Face zur Verfügung.

Das 32-Milliarden-Parameter-Modell kann mittels Quantisierung auf einer einzelnen Nvidia H100 mit 80 GB Speicher ausgeführt werden und unterstützt Kontexte von bis zu 131.000 Tokens.

Die Forschenden betonen allerdings, dass CWM ein reines Forschungsmodell ist, das nicht für allgemeine Unterhaltungen optimiert wurde und ausschließlich auf Programmierung und mathematisches Denken fokussiert ist. Für Produktionsumgebungen sei es nicht geeignet.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.