Raubkopierte Bücher und Artikel-Kopien: Copyright-Druck auf OpenAI nimmt weiter zu

Neun US-Regionalzeitungen verklagen OpenAI und Microsoft wegen massiver Urheberrechtsverletzungen und fordern im Extremfall die Vernichtung zentraler Sprachmodelle. Parallel zwingt ein Bundesgericht OpenAI, interne Kommunikation über gelöschte Buchdatensätze aus einer Piratenbibliothek offenzulegen.

Die KI-Modelle von OpenAI und darauf aufbauende Microsoft-Dienste wie Copilot seien in großem Umfang mit unlizenzierten Presseartikeln trainiert worden und könnten diese teils nahezu wortgleich reproduzieren. Das geht aus der vor einem New Yorker Gericht eingereichten Klageschrift hervor, die Zeitungen wie der Boston Herald, Hartford Courant, die San Diego Union-Tribune und die Los Angeles Daily News eingereicht haben.

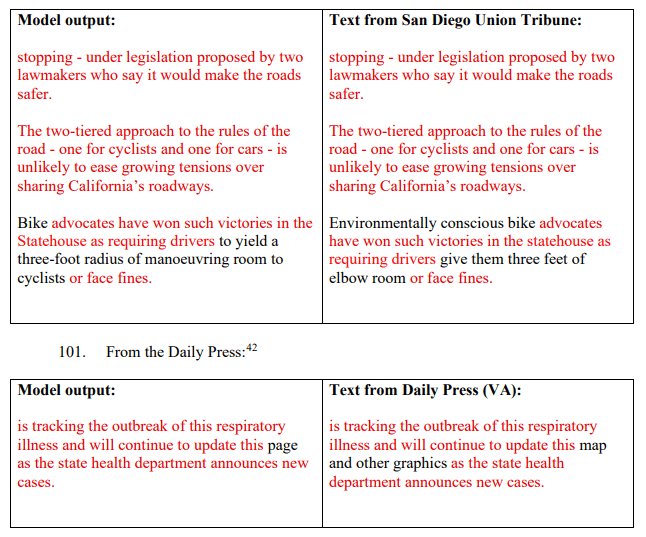

Ein Kernstück der Klage sind konkrete Beispiele, in denen ChatGPT-Varianten Presseartikel der Kläger nahezu wortgetreu ausgeben. Die Verlage legen gegenübergestellte Textausschnitte aus Modellantworten und Originalartikeln vor, die nur geringfügig voneinander abweichen. Die Verlage argumentieren, dass diese Beispiele kein Zufall seien, sondern ein Muster belegten: Die Modelle hätten ihre Artikel "memorisiert" und gäben diese auf geeignete Prompts hin fast im Wortlaut wieder aus.

In der sehr ähnlichen Auseinandersetzung mit der New York Times argumentierte OpenAI bereits, die Zeitung habe das Modell so lange mit Prompts bearbeitet, bis es Inhalte reproduzierte. Dabei handele es sich um einen Fehler („Bug“), nicht um eine beabsichtigte Funktion.

Die rechtliche Bewertung solcher Phänomene bleibt international uneinheitlich: Ein Münchner Gericht bestätigte kürzlich eine Urheberrechtsverletzung durch Memorisierung im Kontext von Liedtexten. Ein britisches Gericht hingegen wies im Fall des Bildmodells Stable Diffusion eine Klage ab und sah eher eine transformative Nutzung.

Über das reine Kopieren hinaus erheben die Verlage Vorwürfe nach dem Digital Millennium Copyright Act: OpenAI habe systematisch Copyright-Management Information wie Byline, Titelzeilen, Copyright-Hinweise und Links zu Nutzungsbedingungen der Verlage entfernt. Die Verlage sehen darin ein Muster: Copyright-Informationen würden entfernt, Inhalte als generierte Texte präsentiert und Nutzer in dem Glauben bestärkt, sie könnten diese ohne weitere Verpflichtungen verwenden.

Lokale Verlage sehen Geschäftsmodell durch KI-Training untergraben

Die klagenden Verlage betrachten sich als zentrale und teils einzige Quelle für lokale Politik, Wirtschaft und Kultur in ihren Regionen. Sie investierten erhebliche Ressourcen in die Berichterstattung vor Ort, finanziert durch Abonnements und Werbung.

Ihre digitalen Inhalte schützen sie durch Paywalls und Nutzungsbedingungen, die Scraping und automatisierte Zugriffe ohne Erlaubnis untersagen. Inzwischen adressieren diese Klauseln explizit auch die Nutzung für das Training von Sprachmodellen, Retrieval Augmented Generation und andere KI-Systeme. Die Inhalte seien ausschließlich für den persönlichen, nicht-kommerziellen Gebrauch bestimmt.

Den Klägern zufolge haben OpenAI und Microsoft diese Schranken bewusst ignoriert. Die Unternehmen hätten systematisch Inhalte von den Webseiten kopiert, Copyright-Hinweise entfernt und die Texte anschließend lizenz- und vergütungsfrei sowohl für das Training als auch zur direkten Ausgabe in Chat- und Suchprodukten verwendet.

Microsoft gilt in der Klage nicht nur als Infrastrukturpartner, sondern als Mitgestalter der Modelle und direkter Nutznießer der aus Sicht der Verlage rechtswidrigen Verwertung ihrer Inhalte.

Die Kläger fordern Schadensersatz von mehr als zehn Milliarden Dollar und berufen sich auf US‑Gesetzesnormen, die bei vorsätzlichen Verstößen bis zu 150.000 Dollar pro Werk sowie bis zu 25.000 Dollar für das Entfernen von Copyright-Informationen vorsehen. Höherwertige Datensätze würden im Training häufiger gesampelt, was nach Auffassung der Verlage nahelegt, dass gerade professionelle Presseinhalte einen überproportionalen Einfluss auf das Modellverhalten hatten.

Zudem verlangen sie drastische Maßnahmen: Alle GPT-Modelle und Trainingssätze, die ihre Inhalte enthalten, sollen zerstört werden. Ähnliche Forderungen stellte schon die New York Times in ihrer Klage von Ende 2023.

OpenAI droht Milliarden-Zahlung wegen raubkopierter Bücher

Parallel zur neuen Verlagsklage läuft ein Verfahren, in dem Buchautoren, Verlage und andere Rechteinhaber OpenAI wegen der Nutzung von Büchern im Modelltraining verklagen. Eine zentrale Rolle spielen dort die internen Datensätze Books1 und Books2, die auf massenhaft aus der Piratenbibliothek Library Genesis geladenen E‑Büchern zurückgehen.

Wie aus einer Schrift der Magistratsrichterin Ona T. Wang hervorgeht, lud ein OpenAI-Mitarbeiter 2018 umfangreiche Bestände von LibGen herunter. Aus diesen Daten wurden interne Korpora erstellt, zunächst "LibGen1" und "LibGen2" genannt, später in Books1 und Books2 umbenannt. Diese Datensätze wurden laut Gerichtsbeschluss zum Training von GPT-3 und GPT-3.5 verwendet.

Mitte 2022, rund ein Jahr vor Einreichung der ersten Klagen, löschte OpenAI Books1 und Books2 und erklärte später gegenüber den Klägern, dies sei "aufgrund von Nicht-Nutzung" geschehen, ohne genauere Informationen dazu zu geben. Das Unternehmen berief sich zunehmend auf das Anwaltsgeheimnis. Richterin Wang folgte dieser Linie nicht, und OpenAI muss die angeforderten Dokumente bis Anfang Dezember 2025 liefern.

Anthropic musste in einem ähnlichen Fall bereits im Rahmen einer außergerichtlichen Einigung Zahlungen an US-Autoren leisten. Der dort zuständige Richter William Alsup legte fest, dass die Verwendung von raubkopierten Daten nicht zulässig sei, unabhängig von einer möglichen transformativen Nutzung der Daten für die KI-Entwicklung. Bei legal erworbenen Büchern könne das KI-Modelltraining jedoch unter Fair Use fallen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.