Künstliche Intelligenz: Fünf spannende KI-Apps aus Googles Forschungslabor

Im Februar 2010 kündigte Google eine neue Strategie an. Sie lautet: „Mobile first“. Gut sechs Jahre später startet Google-CEO Sundar Pichai die nächste Transformationsphase für den Digitalkonzern: Aus „Mobile first“ wird „AI first“.

Wer eine Google-Anwendung findet, die nicht an irgendeiner Stelle von KI profitiert, bekommt einen Keks: Der Google-Assistent soll den Alltag erleichtern. KI unterstützt die Internetsuche und steuert Spamfilter im E-Mail-Programm. Google Lens erkennt Objekte und Texte auf Bildern. Die Google-Foto-App sortiert Aufnahmen nach Personen. Und so weiter.

Bevor Künstliche Intelligenz ihren Weg in ein Produkt findet, ist jedoch Forschung angesagt. Die übernehmen Forscher-Teams bei Google Brain und der Google-Schwester Deepmind. Allein Deepmind hat über 700 Angestellte. Ich stelle euch fünf spannende KI-Apps aus Googles Forschungslabor vor.

Krankheiten erkennen

Deepmind entwickelt eine KI, die Ärzten bei der Frühdiagnose von Augenkrankheiten hilft. Sie konnte in einem Test 50 Augenkrankheiten so zuverlässig wie Fachärzte diagnostizieren.

Die KI wurde in Zusammenarbeit mit dem University College London und der Augenklinik Moorfield entwickelt. Insgesamt wurde sie mit 15.000 Augen-Scans von etwa 7.500 Patienten trainiert.

Durch das Datentraining kann sie anatomische Eigenschaften der Augen analysieren und schlägt anschließend – sofern notwendig - eine Therapie vor. In 94 Prozent der Fälle zog die KI dieselben Schlussfolgerungen wie acht Fachärzte, die untereinander beratschlagten. Nur war sie dabei deutlich schneller.

Eine weitere Google Bildanalyse-KI wurde von Forschern der Universität New York eingesetzt, um Pathologen bei der Lungenkrebsdiagnose zu unterstützen. Sie kann nach dem Training mit Hunderttausenden Bildern mit einer Genauigkeit von 99 Prozent gesundes und krankes Lungengewebe unterscheiden.

Damit nicht genug: Sie erkennt sogar die verschiedenen Subtypen und Genmutationen allein anhand der Aufnahmen. Der Facharzt kann das nicht.

Fotos und Videos erstellen

Sogenannte GAN-Netzwerke (Generative Adversarial Network) können mittlerweile täuschend echte Bilder entwickeln: Eine Generator-KI erstellt das gewünschte Motiv. Eine Diskriminator-KI prüft die Überzeugungskraft. Wenn die nicht passt, startet die Generator-KI den nächsten, besseren Versuch entlang der Rückmeldung der Diskriminator-KI - bis das Ergebnis irgendwann gut genug ist. Diese Selbstverbesserungsschleife macht GAN-Netzwerke so effizient.

Der Erfinder des GAN-Prinzips heißt Ian Goodfellow, er ist 33 Jahre jung und arbeitet - natürlich - bei Google Brain.

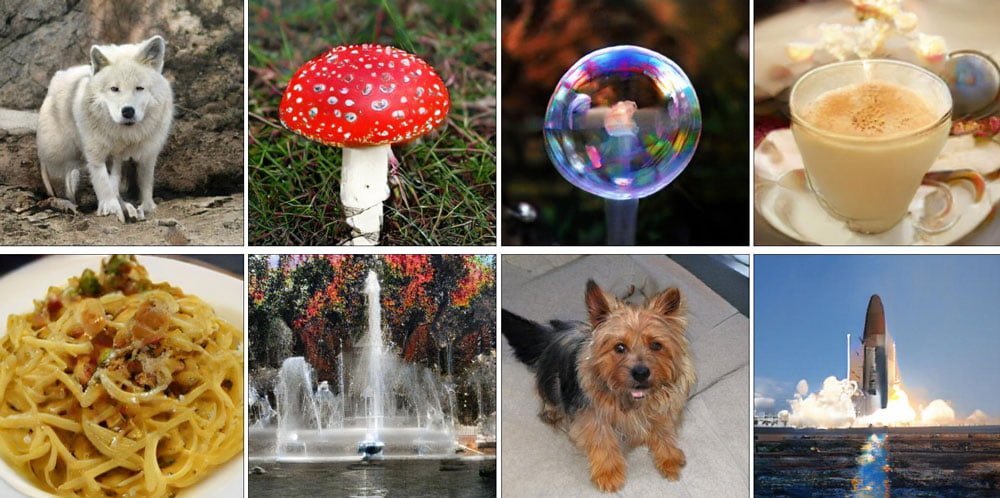

Kürzlich stellten seine Kollegen bei Deepmind eine GAN-KI vor, die zum Beispiel Nahrung, Tiere und Naturaufnahmen künstlich generiert. Die Ergebnisse sind kaum noch von realen Fotos zu unterscheiden.

Mit einer ähnlichen Methode erstellt Deepmind 3D-Szenen aus 2D-Aufnahmen. Das klingt im ersten Moment nicht so spektakulär. Aber nur, weil Vorstellungskraft für Menschen so selbstverständlich ist:

Wenn wir die Vorderseite einer Tasse sehen, können wir uns sehr leicht vorstellen, wie die Rückseite aussieht. Dafür müssen wir die Tasse nicht erst herumdrehen. Diese Fähigkeit ist tief in unserer Wahrnehmung verwurzelt.

Künstliche Intelligenz konnte das bislang nicht. Doch Deepminds KI erreichte in Tests eine ähnliche Fähigkeit: Nach dem Blick auf eine Seite eines Würfels kann sie die restlichen Seiten des Würfels ergänzen und ihn aus anderen Perspektiven darstellen. Wenn man so will, erschuf Deepmind eine KI mit einer rudimentären, mathematischen Vorstellungskraft.

Zum Einsatz kommen solche Bild-KIs bei Deepfakes, in der Filmindustrie oder für Nvidias Kantenglättung DLSS.

Lippenlesen

Deepmind stellte kürzlich eine lippenlesende KI vor. Sie wurde mit 4.000 Stunden Videomaterial englischer Sprecher trainiert. In einem 37-minütigen Video las die KI den Sprechern 60 Prozent aller Wörter korrekt von den Lippen ab.

Für die Forscher ist das ein „beispielloses Ergebnis“, denn: menschliche Lippenleser liegen deutlich unter diesem Wert.

Je nach Videoqualität können sie zwischen sieben und 14 Prozent der Wörter korrekt von den Lippen ablesen. Der bis dato beste Lippenlese-Algorithmus erreichte 23 Prozent.

Eine lippenlesende KI könnte Gehörlosen helfen, aber auch als Spionagetechnologie eingesetzt werden. Schon jetzt ist es gängig, dass zum Beispiel Fußballspieler oder Politiker beim privaten Sprechen in der Öffentlichkeit ihren Mund mit der Hand verdecken, damit ihre Worte nicht von einem professionellen Lippenleser erkannt werden.

Spiele spielen

Im März 2016 besiegte Googles Künstliche Intelligenz AlphaGo den Go-Meister Lee Sedol. Es war ein Durchbruch für die KI-Forschung. AlphaGo hatte für diesen Triumph Millionen menschlicher Spielzüge analysiert und gelernt, genaue Vorhersagen zu treffen.

Der direkte Nachfolger der KI war AlphaGo Zero. Sie trägt Zero („Null“) symbolisch im Namen, weil sie - anders als das neuronale Vorgängernetzwerk - keine menschlichen Daten mehr fürs Training benötigt. Sie spielt Go einfach gegen sich selbst - und trainiert und lernt das Spiel so schneller und besser, als es Menschen jemals möglich wäre.

Siege werden belohnt, Niederlagen bestraft: Nach diesem einfachen Prinzip entwickelt sich die Zero-KI permanent weiter. Nach nur drei Trainingstagen schlug AlphaGo Zero den eigenen Vorgänger. Von 100 Partien gewann die selbstlernende KI jedes einzelne Duell.

Die Technologie hinter AlphaGo Zero, das sogenannte „Deep Reinforcement Learning“, wird von Google auch für die Kühlung der eigenen Datenzentren eingesetzt. Trotz bereits hoher Effizienz senkte die Deepmind-KI die Kosten um weitere 40 Prozent.

Laufen lernen

Deepminds Bewegungs-KI vermittelt einen sehr lebhaften Eindruck der Vielfalt maschineller Lernverfahren: Sie bringt einem virtuellen Körper das Laufen bei. Dafür erstellten Forscher in einem Experiment einen digitalen Hindernisparcours, den die KI - verkörpert im Avatar - überwinden sollte.

Der Hindernisparcours wurde zufällig generiert und die KI war komplett auf sich alleine gestellt. Sie kannte allein die Richtung des Ziels sowie den Bewegungsumfang ihres Avatars.

Das Ergebnis war damals beeindruckend, heute ist es eher unterhaltsam. Aktuellere Ansätze für KI-Animationen sind schon deutlich agiler. Die folgende Demo kommt vom kalifornischen Unternehmen Deep Motion.

Digital gelernte Bewegungsabläufe können beispielsweise für Videospiele verwendet oder auf echte Roboter übertragen werden. Die Non-Profit-KI-Organisation OpenAI zeigte kürzlich, wie eine Roboterhand auf diese Art das Jonglieren lernt.

KI braucht immer mehr Rechenpower

Alle Beispiele haben eines gemeinsam: Sie wurden zwar zum Teil durch Durchbrüche bei der Programmierung neuronaler Netze möglich. Aber die entscheidende Rolle spielte die höhere Rechenleistung moderner Chips, insbesondere jener, die auf KI-Berechnungen spezialisiert sind.

AlphaGo Zero benötigte eine um den Faktor 300.000 höhere Rechenleistung als die KI „AlexNet“, die 2012 den ImageNet-Test mit großem Vorsprung gewann und so den zweiten KI-Frühling in Gang setzte. Aktuell verdoppelt sich nach einer Studie von OpenAI der Bedarf nach Rechenleistung alle dreieinhalb Monate.

Die hohen Anforderungen an die Rechenleistung veranlassten Google dazu, eigene KI-Chips zu produzieren. Googles Softwareingenieur Cliff Young sagte kürzlich, man verbinde mittlerweile Tausende dieser Chips zu Supercomputern. Google stellt diese Rechenpower seinen zahlenden Kunden per Cloud Computing zur Verfügung.

Die für die eigenen KI-Projekte entwickelten KI-Modelle sind hingegen zum Großteil kostenlos auf Online-Plattformen verfügbar - obwohl Google Milliarden US-Dollar in die Forschung steckt. Pichai und Co. wissen, dass revolutionäre Künstliche Intelligenz nur durch eine kollektive Anstrengung Realität wird - und offene Innovation erhöht das Tempo. Solange Google die immer schneller werdende KI-Meute an der Spitze anführt, ist für den Digitalkonzern alles im grünen Bereich.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.