Feindliche Umprogrammierung: Google zwingt KI zu ungewollten Berechnungen

Zu den vielen mit Künstlicher Intelligenz verbundenen ethischen Fragen gehört gewiss die Sicherheit. Warum das so ist, zeigt ein beeindruckender Deep-Learning-Hack von Googles Brain-Team.

In den letzten Monaten zeigten KI-Forscher wiederholt, wie einfach es sein kann, eine auf visuelle Wahrnehmung ausgerichtete Künstliche Intelligenz aus der Bahn zu werfen.

Durch für den Menschen fast nicht sichtbare Pixelveränderungen verwechselt eine KI beispielsweise eine Schildkröte mit einem Gewehr oder die Gesichtserkennung wird blockiert.

In einem anderen Forschungsexperiment sorgt ein bunter Sticker dafür, dass die KI statt einer Banane einen Toaster sieht.

Google KI-Forscher ergaunern sich Rechenleistung

Nun wendeten KI-Forscher aus Googles Brain-Team das visuelle Täuschungsmanöver erstmals an, um eine KI andere Berechnungen durchführen zu lassen, als ursprünglich vorgesehen. Die Entwickler taufen den Prozess "feindliche Umprogrammierung".

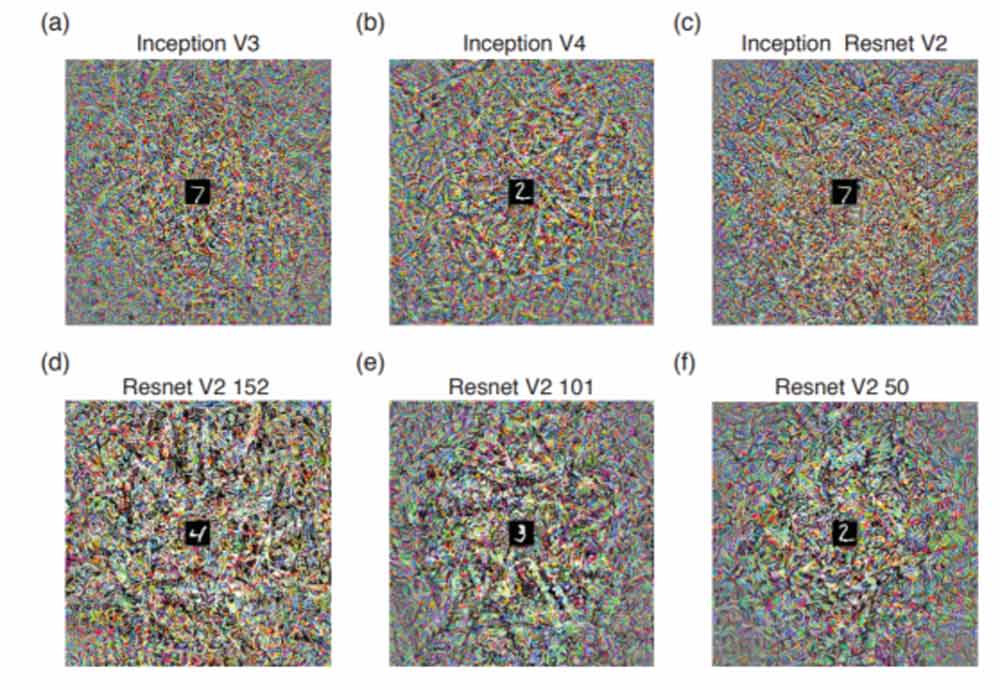

Für den Hack fügten sie einen Täuschungssticker (Beispiele siehe Titelbild) an 100.00 Bilder einer typischen Bilddatenbank an, mit der eine Künstliche Intelligenz ihre Bildanalysekompetenz trainiert.

Die KI durchlief ihren Arbeitsprozess zunächst wie geplant. Erwischte sie jedoch ein Bild mit Täuschungssticker, führte sie anstelle ihrer Bildanalyse die auf dem Sticker vorgegebene Arbeitsanweisung durch.

Die war im Falle des Experiments einfach gehalten: Die KI wurde gezwungen, weiße Quadrate oder eine Nummer zu zählen, statt das Objekt auf dem Bild zu analysieren. In einem weiteren Szenario wurde die KI in eine alternative Trainingsdatenbank umgeleitet. Im Experiment funktionierte der Hack bei 99 Prozent der 100.000 manipulierten Bilder.

Attacke nur mit Vorbildung

Voraussetzung ist allerdings, dass der Angreifer Parameter und Aufgabe des zu attackierenden neuronalen Netzes kennt. Eine völlig blinde Attacke gegen jede Art KI-Netz ist also nicht möglich.

Die Forscher schreiben in ihrer Veröffentlichung dennoch von einer "überraschenden Schwachstelle neuronaler Netze". So könnten nach dem vorgestellten Prinzip zum Beispiel Smartphones mit KI-Assistenten durch feindliche Bilder oder Audiodateien umprogrammiert werden.

Da Assistenten weitläufig mit Nutzerdaten ausgestattet sind - E-Mails, Kalender, Zugangs- und Kreditkartendaten - könnten die Konsequenzen solcher Attacken heftig ausfallen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.