Künstliche Intelligenz: Algorithmus soll Gesichtserkennung verhindern

Künstliche Intelligenz automatisiert vieles, auch die Überwachung. Allerdings kann sie diese ebenso verhindern - oder zumindest erschweren. Ein Hin und Her zeichnet sich ab.

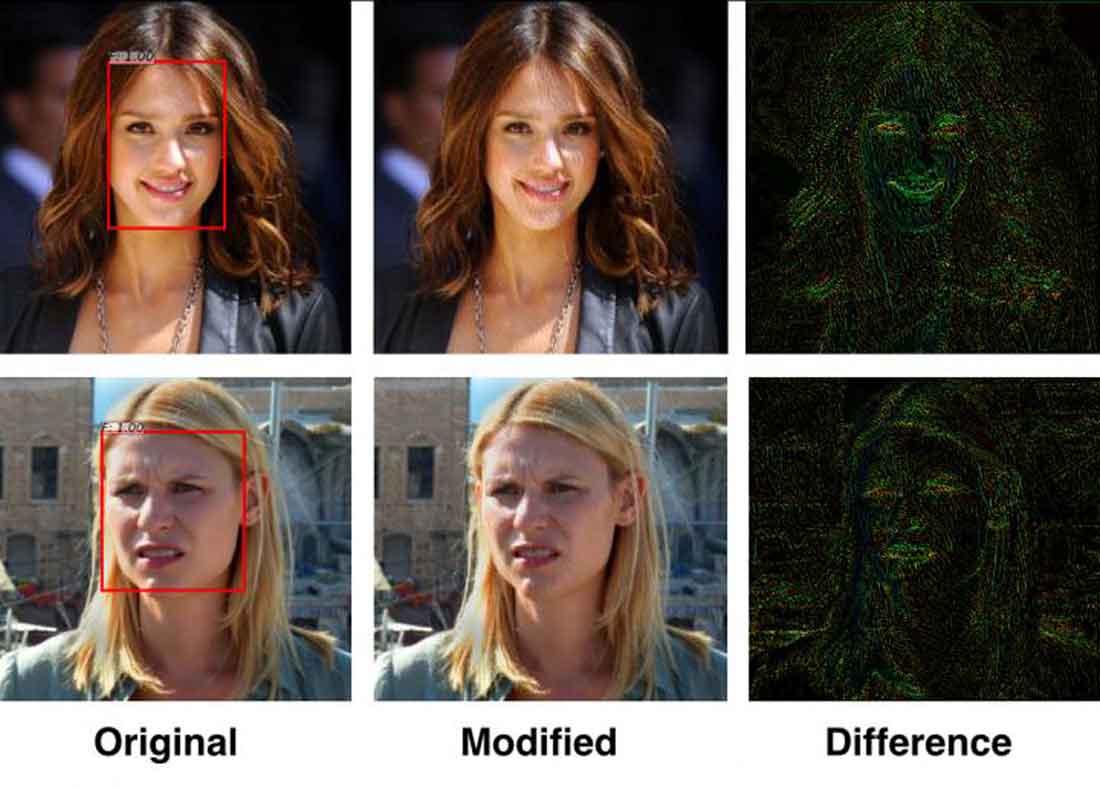

KI-Forscher der Universität Toronto stellen einen Algorithmus vor, der eine Gesichtsanalyse-KI davon abhalten kann, ihren Job erfolgreich zu machen. Dafür verändert die Gegner-KI jene Stellen im Gesicht, die die Analyse-KI als Orientierungspunkte für die Gesichtserkennung verwendet.

Wenn die Analyse-KI beispielsweise die Augenwinkel auswertet, um eine Person zu identifizieren, verändert die Gegner-KI die Pixelstruktur an den Augenwinkeln minimal. Diese für das menschliche Auge kaum oder nicht wahrnehmbare Anpassung (siehe Titelbild) soll ausreichen, um eine Identifizierung zu verhindern.

Entwickelt wurde das Störverfahren nach dem gleichen Prinzip, nach dem auch eine Gesichtserkennungs-KI optimiert wird - nur eben umgekehrt:

Zwei miteinander konkurrierende neuronale Netze verbessern sich gegenseitig. Die Gegner-KI legt der Analyse-KI ein verändertes Foto zur Erkennung vor. Ist die Analyse-KI erfolgreich, gilt der Versuch als gescheitert und die Gegner-KI passt das Foto erneut an - bis die Analyse-KI kontinuierlich versagt.

Der digitale Foto-Schredder fürs KI-Zeitalter

Das Verfahren schützt natürlich nicht vor einer Echtzeit-Analyse des eigenen Gesichts. Aber es könnte für Fotos benutzt werden, die man ins Internet hochlädt. So wäre man im Fall der Fälle schwieriger über verschiedene Kanäle hinweg aufspürbar.

Hinzu kommt, dass neben dem eigenen Gesicht viele weitere Informationen in einem Bild stecken können. Beispielsweise kann eine Aufnahme Daten enthalten über den Aufenthaltsort, verwendete Produkte und Objekte und womöglich weitere Personen. Wenn die Gesichtsanalyse nicht mehr stattfindet, können diese Informationen schwieriger einem persönlichen Profil zugeordnet werden.

Die Anti-Gesichtsanalyse-KI erinnert an das Prinzip eines Papierschredders, durch den man wichtige Unterlagen laufen lässt, bevor man diese potenziell anderen Menschen zugänglich macht. Neben der De-Identifikation von Fotos soll sie auch Bildersuchen und die automatisierte Analyse von Emotionen oder Herkunft verhindern können.

Die Entwickler wollen ihre Gegner-KI via Webseite oder App veröffentlichen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.