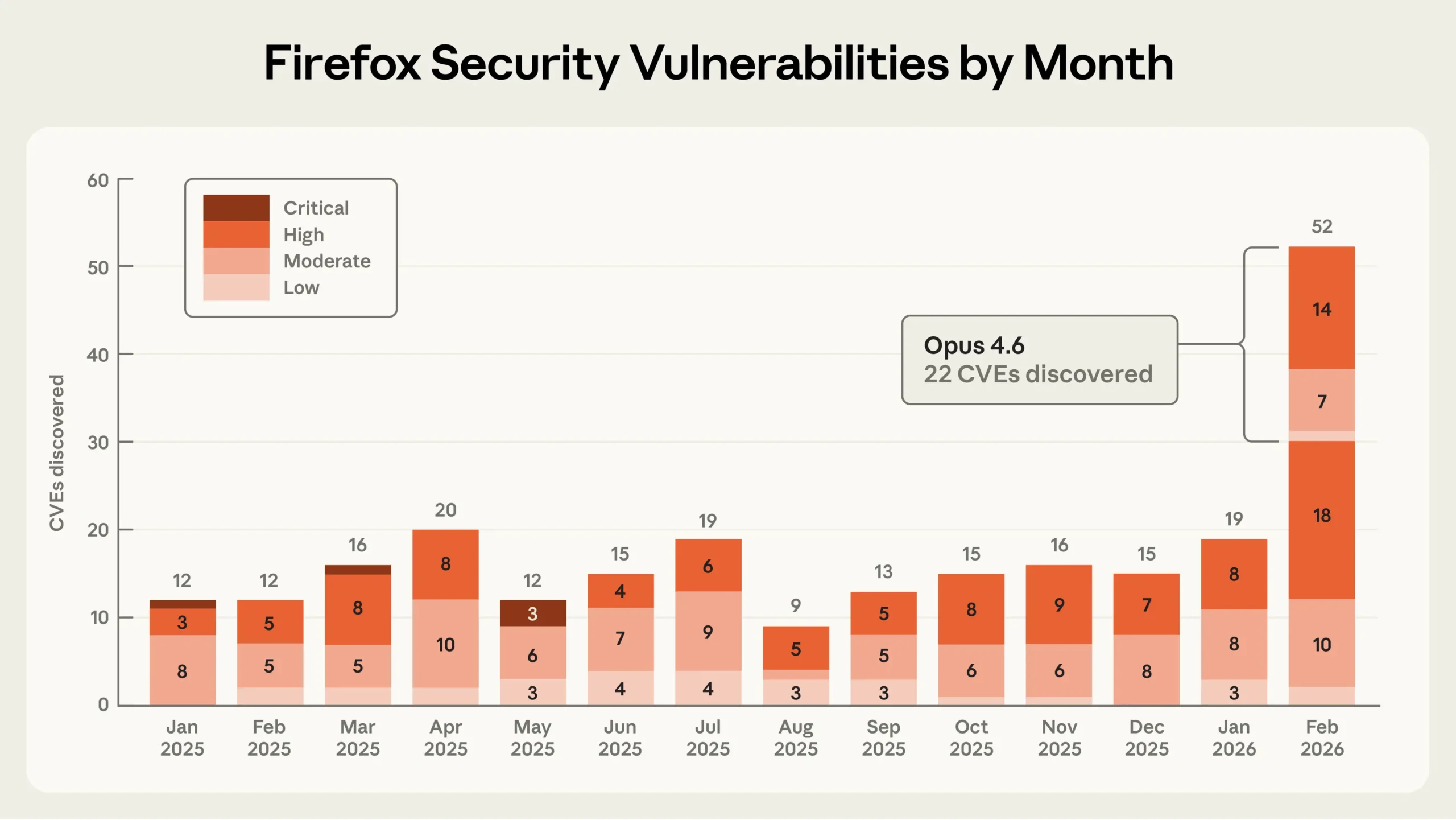

Mozilla und Anthropic haben gemeinsam über 100 Fehler in Firefox gefunden. Anthropic setzte sein KI-Modell Claude ein, um Schwachstellen im Browser-Code zu identifizieren. Das Ergebnis: 14 schwerwiegende Sicherheitslücken, 22 offizielle Sicherheitsmeldungen (CVEs) und 90 weitere Fehler. Alle schweren Lücken sind in Firefox 148 behoben.

Claude fand dabei Fehlerklassen, die klassische automatisierte Testverfahren wie Fuzzing trotz jahrzehntelangem Einsatz übersehen hatten. Laut Mozilla lieferte Anthropic reproduzierbare Testfälle, was die Überprüfung erleichterte. Mozilla will KI-gestützte Codeanalyse künftig in seine internen Sicherheitsprozesse einbauen.

Firefox wurde laut Anthropic als Testfeld gewählt, weil es eines der am intensivsten geprüften Open-Source-Projekte ist. Die Firma hat einen detaillierten technischen Bericht zu den Ergebnissen auf seiner Website veröffentlicht. Für das hauseigene KI-Tool Claude Code erschien kürzlich eine Funktion speziell für Cybersecurity-Prüfungen.