Metas KI-System dekodiert Sprachwahrnehmung im Gehirn

Metas KI-Forschende zeigen ein System, das aus MEG- und EEG-Daten vorhersagen kann, welche Wörter ein Mensch gehört hat.

Über 60 Millionen Menschen erleiden jährlich traumatische Verletzungen des Gehirns. Viele von ihnen können danach nicht mehr mit ihrer Umgebung kommunizieren.

Zahlreiche Projekte suchen nach einer Möglichkeit, den Betroffenen zu helfen. Ein Ansatz ist die Dekodierung von Hirnaktivitäten in Sprache: Statt zu sprechen, zu tippen oder Gesten zu verwenden, liest ein Messgerät Hirnaktivitäten aus und übersetzt sie in Sprache.

Dabei gibt es unterschiedliche invasive oder non-invasive Methoden. Die Stereoelektroenz- oder die Elektroenzephalografie liefern zwar genauere Messwerte, die teilweise eine über 90-prozentige Genauigkeit bei der Zuschreibung einzelner Buchstaben erreichen. Sie erfordern aber neurochirurgische Eingriffe.

Non-invasive Methoden, die auf Elektroenzephalografie (EEG) oder Magnetoenzephalografie (MEG) zurückgreifen, erfordern keine gefährlichen Eingriffe, liefern aber ungenauere Daten.

Meta forscht an Ähnlichkeiten zwischen KI und menschlichem Gehirn

In einer neuen Forschungsarbeit stellt ein Team von Meta nun ein KI-System vor, das mit einer verhältnismäßig hohen Genauigkeit anhand von MEG-Daten erkennen kann, welche Wörter Versuchspersonen gehört haben.

Die Arbeit ist Teil eines größeren Forschungsvorhabens des Unternehmens: Meta will mehr über das menschliche Gehirn lernen, um bessere Künstliche Intelligenz zu entwickeln.

Geführt wird das Projekt von Jean-Remi King, CNRS-Forscher an der Ecole Normale Supérieure und Forscher bei Meta AI. Das Team um King zeigte Ende letzten Jahres, dass es die Reaktionen des menschlichen Gehirns auf Sprache anhand der Aktivierungen eines GPT-2-Sprachmodells als Reaktion auf dieselben Geschichten vorhersagen kann.

Video: Meta

In einer im Juni veröffentlichten Arbeit verglich Kings Team dann ein mit Sprachaufnahmen trainiertes KI-Modell mit fMRT-Aufnahmen von mehr als 400 Personen, die Hörbücher hören. Laut den Forschenden korrelierten die meisten Hirnareale signifikant mit den Aktivierungen des Algorithmus als Reaktion auf denselben Sprachinput. Der KI-Algorithmus habe gehirnähnliche Repräsentationen gelernt, so der Schluss des Teams.

Meta entschlüsselt MEG mit Künstlicher Intelligenz

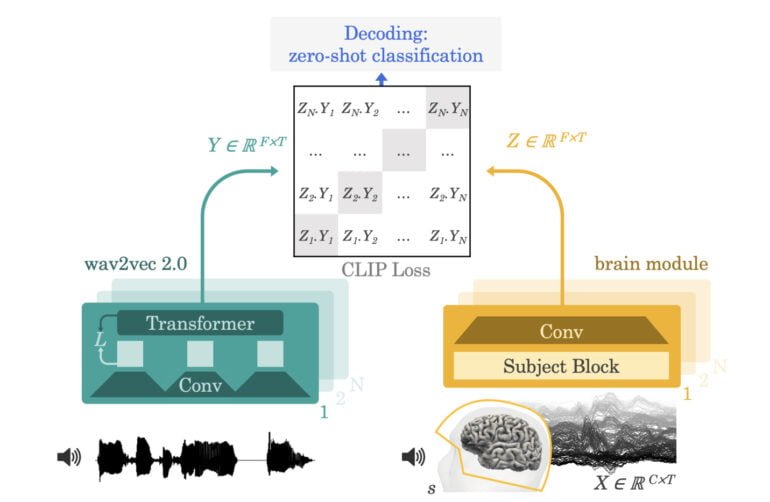

In der nun veröffentlichten Arbeit baut das Team um King auf die Arbeiten vom Juni auf: Das dort mit 600 Stunden Sprachaufnahmen trainierte Wav2Vec-Modell extrahiert eine Repräsentation einer drei Sekunden kurzen Sprachaufnahme und lernt, diese Repräsentationen entsprechenden Repräsentationen von Gehirnaktivitäten aus MEG und EEG zuzuordnen.

Die Repräsentationen der Gehirnaktivitäten liefert ein Gehirnmodul, das mit knapp 150 Stunden MEG- und EEG-Aufnahmen von 169 Personen trainiert wurde.

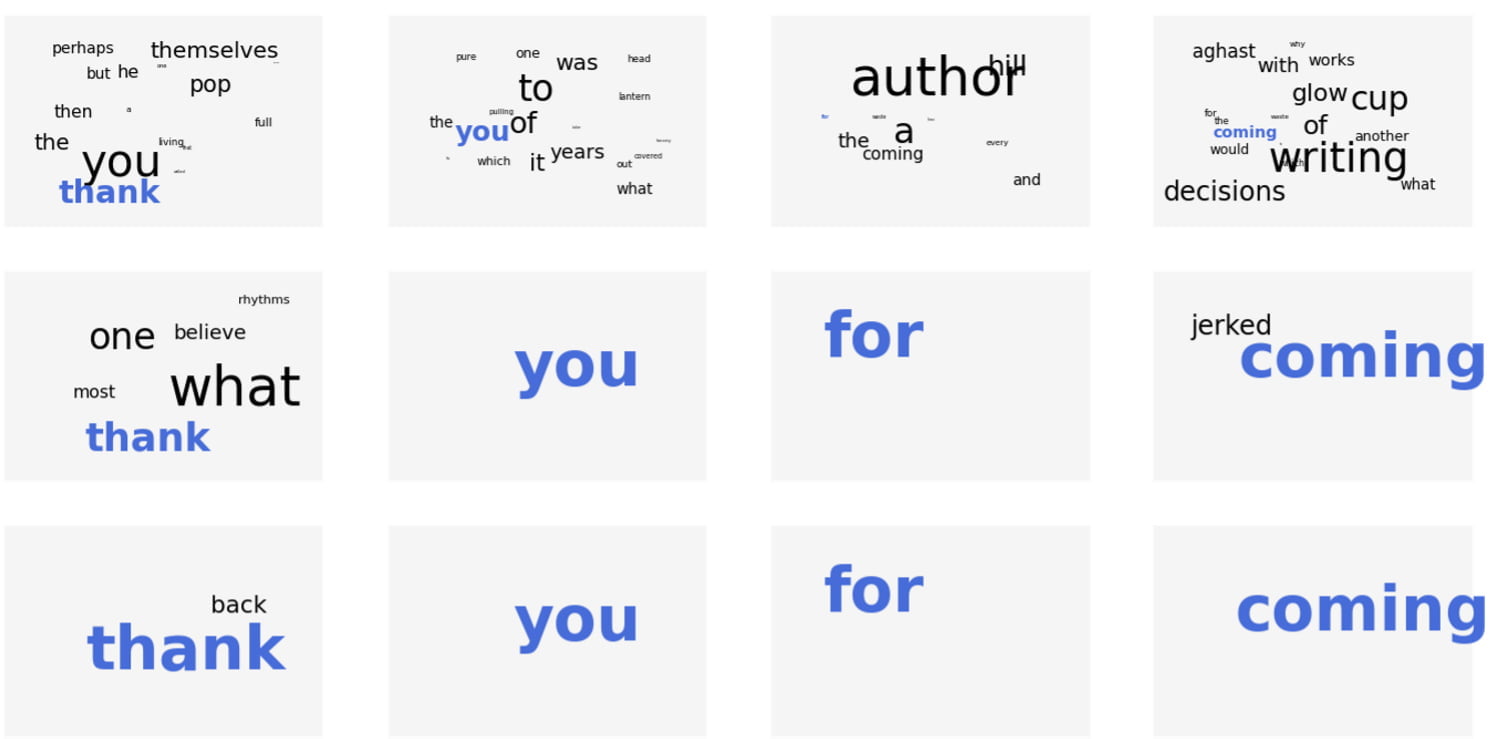

Nach dem Training kann das KI-Modell anhand eines Ausschnitts der Gehirnaktivität identifizieren, welchen Clip aus einem großen Pool Audioclips die Person gehört hat. Dafür leitet der Algorithmus die Worte ab, die die Person am wahrscheinlichsten gehört hat.

Metas KI-System erreicht bei MEG-Aufnahmen eine Top-10-Genauigkeit von bis zu 73 Prozent bei 793 möglichen Wörtern. Unter zehn vorgeschlagenen Wörtern ist also mit 72-prozentiger Wahrscheinlichkeit das richtige Wort dabei. In bis zu 44 Prozent der Fälle war das richtige Wort der erste Vorschlag. In mehr als 50 Prozent der Fälle war es unter den ersten zwei Vorschlägen.

Nächster Schritt: Gehirn zu Sprache - ohne Eingriff

Metas Forschung hat zahlreiche Einschränkungen. So sinkt die Genauigkeit bei den portableren EEGs auf unter 32 oder sogar 20 Prozent. Zudem dekodiert Metas Team keine Gedanken in Sprache, sondern will erkennen, welche Worte ein Mensch gehört hat. Für eine robuste Kommunikation reicht das nicht aus.

Dennoch sei die Forschung ein wichtiger Schritt, da sie zeige, dass KI erfolgreich lernen könne, verrauschte, non-invasive Aufzeichnungen von Gehirnaktivitäten in der Sprachwahrnehmung zu entschlüsseln, so Meta.

Zusätzlich sei das System mit mehr Trainingsdaten besser geworden. Für die erreichte Genauigkeit sei keine zeitaufwendige Personalisierung für einzelne Personen notwendig gewesen. Weitere Daten könnten diesen Effekt noch verstärken.

Auch die Hardwareanforderungen seien auf lange Sicht keine Probleme: Die hier verwendeten MEG-Geräte seien zwar nicht portabel, doch portable MEGs seien in Entwicklung und teilweise bereits im Einsatz.

Der nächste Schritt bestehe nun in der Erweiterung des Ansatzes auf die Dekodierung von Sprache direkt aus der Gehirnaktivität - ohne den Umweg über einen Pool von Audioclips.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.