Microsoft-Forscher beschreibt zwei neue Deepfake-Methoden und ihre Risiken

Eric Joel Horvitz ist Informatiker und Direktor des Microsoft Research Lab in Redmond. In einem neuen Forschungspapier beschreibt er zwei neue Deepfake-Methoden und ihre weitreichenden Risiken.

Im Forschungspapier "On the Horizon: Interactive and Compositional Deepfakes" beschreibt Horvitz zwei neue Deepfake-Methoden, die er in Zukunft technisch für möglich hält und "von denen wir erwarten können, dass sie in der Praxis kostspielige Auswirkungen auf die Gesellschaft haben werden."

Interaktive und kompositorische Deepfakes

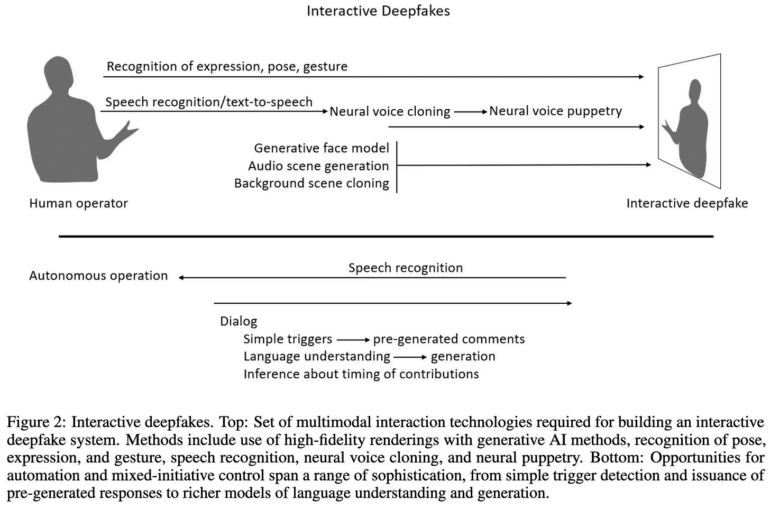

Als "interaktiven Deepfake" klassifiziert Horvitz multimodale Deepfake-Klone realer Personen, die etwa in Video-Calls nicht mehr von der realen Person unterscheidbar sind. Bisherige Deepfake-Systeme beschränken sich meist auf den Austausch des Gesichts - und selbst dieses bietet nur eine begrenzte Interaktion. Die Illusion zerfällt etwa bei stärkeren Kopfdrehungen oder einer ausdrucksstarken Mimik.

Für interaktive Deepfakes sieht Horvitz den Einsatz einer Reihe an KI-Techniken für synthetische Nachbildungen von Posen, Mimik, Gesten, Sprache und der Fernsteuerung durch eine reale Person im Stil eines Puppenspielers ("neural puppetry").

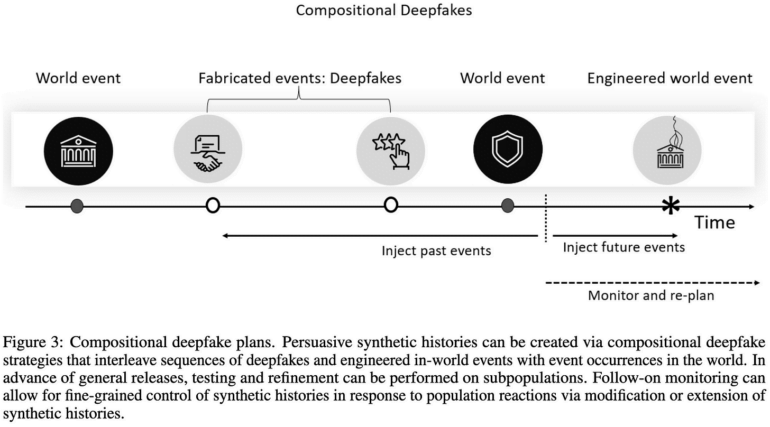

Der "kompositorische Deepfake" ist laut Horvitz die Zusammenstellung einer Reihe von Deepfakes, die im Zusammenspiel eine größere Geschichte erfinden, etwa einen Terroranschlag oder einen Skandal, der nie stattgefunden hat.

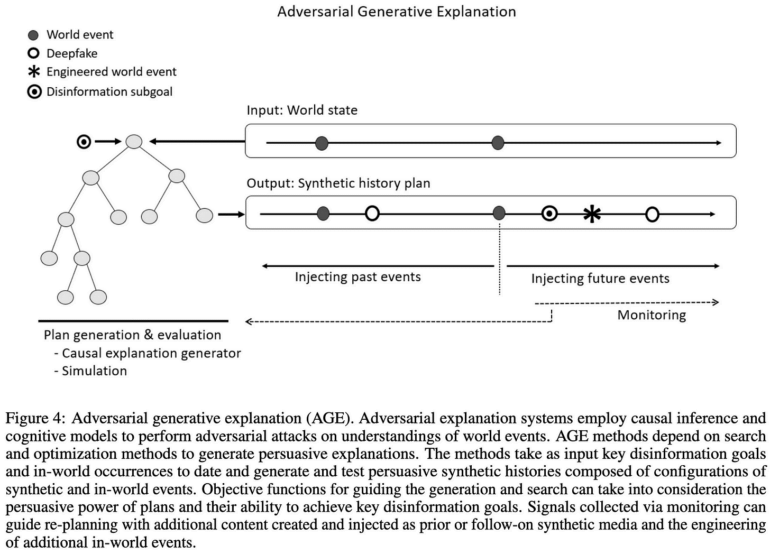

Diese Deepfakes könnten zudem mit realen Geschehnissen verwoben werden, um systematisch "synthetische Historien", also Geschichtsverfälschung, etwa in Untergruppen der Bevölkerung zu etablieren. Horvitz bezeichnet diese Systeme als "kontradiktorische Erklärungssysteme", die rückwirkend und zukunftsgewandt ein gemeinschaftliches Verständnis des Weltgeschehens attackieren.

Interdisziplinär wehren - so gut es geht

"Ohne Gegenmaßnahmen droht durch interaktive und kompositorische Deepfakes eine post-epistemische Welt, in der Fakt nicht mehr von Fiktion unterschieden werden kann", schreibt Horvitz.

Als mögliche Gegenmaßnahmen beschreibt der Forscher gängige Überlegungen und Systeme, etwa die Aufklärung der Öffentlichkeit über Deepfake-Risiken, die Regulierung der Technologie, eine automatisierte Deepfake-Erkennung und kryptografische Nachweise, etwa durch digitale Wasserzeichen.

Horvitz fordert zudem "disziplinübergreifende Überlegungen", wie KI-Fortschritte für das Allgemeinwohl und für böswillige Zwecke genutzt werden könnten, um kommende Entwicklungen möglichst genau zu antizipieren.

"Während wir an der Grenze der technologischen Möglichkeiten voranschreiten, müssen wir uns weiterhin über den möglichen Missbrauch der von uns geschaffenen Technologien Gedanken machen und an der Entwicklung von Gefahrenmodellen, Kontrollen und Sicherheitsvorkehrungen arbeiten - und wir müssen uns in allen Sektoren mit wachsenden Bedenken, akzeptablen Verwendungsmöglichkeiten, bewährten Praktiken, Abhilfemaßnahmen und Vorschriften befassen."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.