Metas "Make-a-Video" macht aus Texten kurze Videos

Update –

- Informationen zu Datensätzen ergänzt.

Update vom 1. Oktober 2022:

Der britische Informatiker Simon Willison, der kürzlich eine Sicherheitslücke bei GPT-3 beschrieb, hat die Videodaten analysiert, mit denen Meta die Text-zu-Video-KI trainierte. Laut Willison verwendete Meta rund zehn Millionen Preview-Clips samt Wasserzeichen der Stock-Plattform Shutterstock. Er macht die Videos in einer Online-Datenbank durchsuchbar.

Weitere rund zehn Millionen Clips stammen aus 3,3 Millionen YouTube-Videos aus einem Datensatz, den Microsoft Research Asia zusammenstellte, schreibt Andy Baio bei Waxy. Die beiden KI-Blogger gehen davon aus, dass Meta nicht die Einwilligung der Videoersteller hatte, die Videos für das KI-Training zu verwenden.

Baio kritisiert explizit eine "akademisch-kommerzielle Pipeline", bei der im Stil einer "Datenwäsche" Datensätze unter akademischem Vorwand erstellt und unter Open-Source-Lizenz freigegeben würden. Diese Datensätze würden dann in der Unternehmensforschung für das Training von KI-Modellen verwendet, die später auch kommerziell zum Einsatz kämen.

Ursprünglicher Artikel vom 29. September 2022:

Mit "Make-a-Video" stellt Meta ein neues KI-System vor, das aus Text, Bildern oder Videos neue Videos generieren kann.

Im Juni stellte Meta "Make-a-Scene" vor, ein multimodales KI-Systeme, das aus sehr groben Skizzen, die das Szenen-Layout beschreiben, in Kombination mit einer Textbeschreibung Bilder generieren kann.

Make-a-Video ist die Weiterentwicklung dieses Systems für Bewegtbild: Neben Text-Bild-Paaren trainierte Meta die KI hierfür mit unbeschrifteten Videodaten.

"Das System lernt anhand von Text-Bild-Paaren, wie die Welt aussieht, und anhand von Videomaterial ohne zugehörigen Text, wie sich die Welt bewegt", schreibt Meta.

Der Verzicht auf beschriftete Videodaten fürs Training reduzierte laut Meta den Trainingsaufwand, durch die Kombination mit Text-Bild-Paaren konnte die visuelle Vielfalt aktueller generativer Bildmodelle erhalten bleiben und verstehen, wie einzelne Objekte aussehen und heißen. Für das Training verwendete Meta laut eigenen Angaben öffentlich verfügbare Datensätze mit Bildern und Videos.

Videogenerierung per Text, Bild oder Video

Wie gängige Bildgeneratoren unterstützt Make-a-Video verschiedene Stile, kann etwa stilisierte oder fotorealistische Videos erzeugen. Das folgende Beispiel zeigt unter anderem ein Video, das anhand der Texteingabe "Ein Teddy malt ein Porträt" erstellt wurde.

Das System kann zudem einzelne Bilder als Eingabe verarbeiten und in Bewegung versetzen oder zwischen zwei ähnlichen Bildern eine Bewegung erzeugen. Aus einem starren Familienfoto wird so etwa ein (sehr) kurzes Familienvideo.

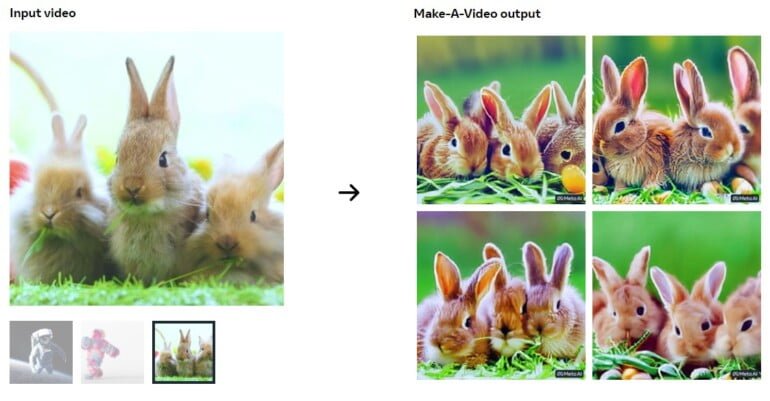

Von vorhandenen Videos kann Make-a-Video Varianten erzeugen, die sich Motiv und der Animation des Originals annähern, sich aber letztlich in Details deutlich unterscheiden.

Qualitativ haben die Videos noch deutlich sichtbare Schwächen wie Unschärfen oder Bildfehler. Allerdings hatten auch die mit den ersten generativen Bild-KIs erzeugten Motive solche Fehler. Die teils qualitativ hochwertigen Ausgaben aktueller Bildsysteme sind bekannt. In ersten Nutzertests wurde Make-a-Video laut Meta sowohl bei der Repräsentation der Texteingabe als auch bei der Bildqualität dreimal besser bewertet als (kaum vorhandene) vergleichbare Systeme. Die Auflösung bei den bewerteten Videos lag bei 256 x 256 Pixel hoch, die maximale von Meta erwähnte Auflösung liegt bei 768 x 768 Pixeln.

Öffentliche Demo ist in Planung

Laut Metas Forschungsteam kann das vorgestellte KI-System noch keine Assoziationen zwischen Text und Phänomen herstellen, die nur anhand von Videos deutlich werden. Als Beispiel nennt Meta die Generierung einer Person, die ihre Hand von links nach rechts oder umgekehrt schwenkt. Zudem kann das System noch keine längeren Szenen generieren, die detaillierte, zusammenhängende Geschichten erzählen.

Wie alle großen generativen KI-System habe Make-a-Video zudem soziale und teilweise schädliche Verzerrungen aus den Trainingsdaten übernommen und würde diese wahrscheinlich verstärken. Meta entfernte laut eigenen Angaben NSFW-Inhalte und toxische Begriffe aus den Daten und setzt Filtersysteme ein. Zudem seien alle Trainingsdaten für eine möglichst hohe Transparenz öffentlich zugänglich. Alle mit Make-a-Video generierten Szenen tragen ein Wasserzeichen, damit stets klar ist, dass es sich um ein KI-generiertes Video handelt.

Meta kündigt eine öffentliche Demo an, nennt allerdings keinen Zeitrahmen. Derzeit würde das Modell intern analysiert und getestet, um sicherzustellen, dass jeder Schritt bei einer möglichen Veröffentlichung "sicher und beabsichtigt" sei.

Interessierte können hier ihr Interesse an weiteren Informationen und einem Zugang zum Modell hinterlegen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.