Adobes generativer KI-Service Firefly soll ein Co-Pilot für die Videoproduktion werden und die so deutlich beschleunigen.

Adobe folgt damit Unternehmen wie RunwayML, die KI-gestütztes Video-Editing ermöglichen und teilweise bereits mit Text-to-Video-Modellen experimentieren. Die auf der diesjährigen NAB-Konferenz (National Association of Broadcasters) vorgestellten Pläne von Adobe sehen zunächst vor, die generativen KI-Modelle der Firefly-Familie in bestehende Workflows zu integrieren.

Auf der NAB zeigte Adobe, wie Firefly beim Videoschnitt helfen kann, aber auch für Audio, Animation oder Motion Graphics eingesetzt werden kann. Firefly soll als kreativer Co-Pilot dienen und die Postproduktion von Tagen auf Minuten verkürzen.

Adobe Firefly als Co-Pilot in der Videoproduktion

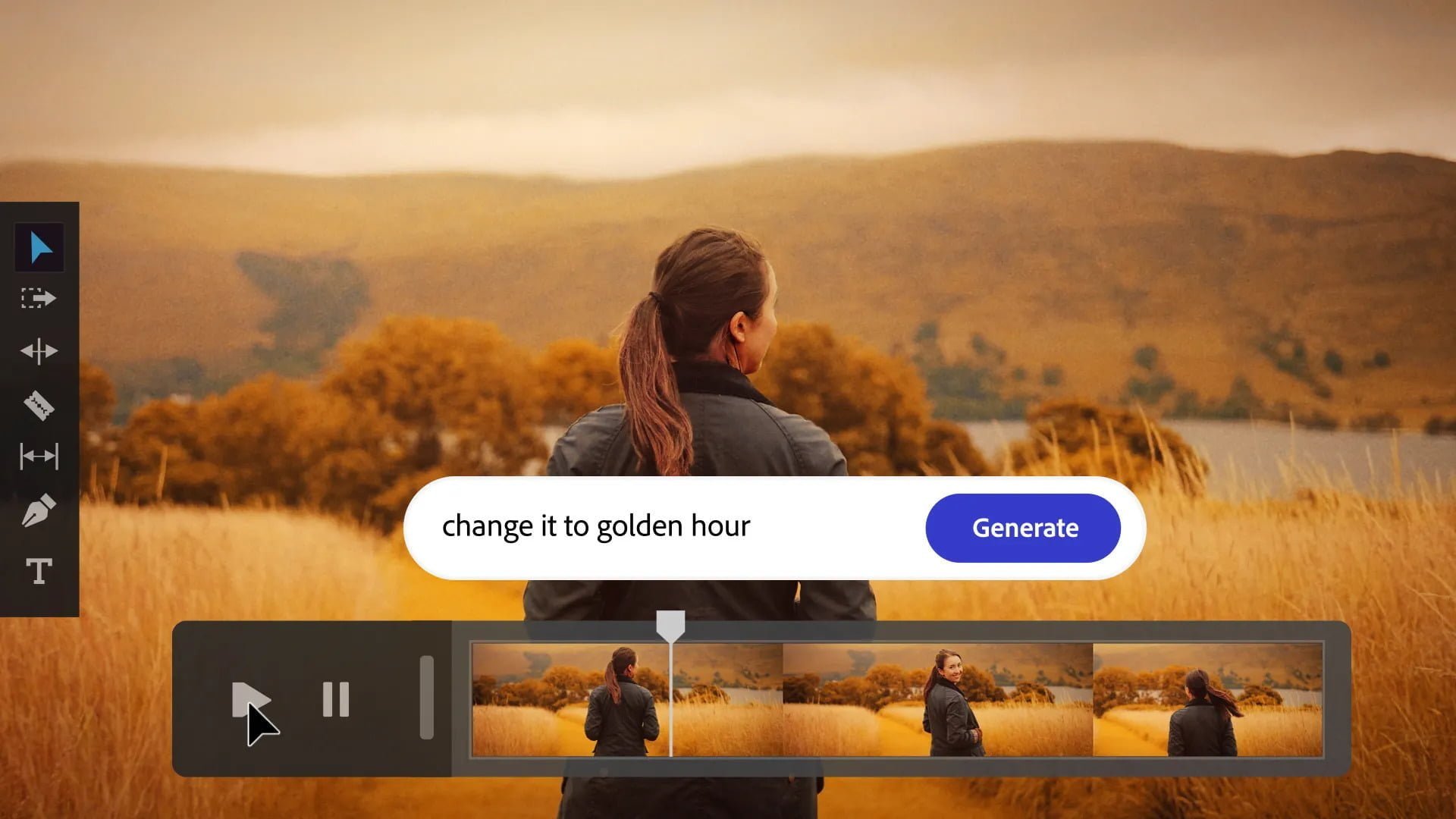

Derzeit experimentiert das Unternehmen mit verschiedenen Anwendungen: Per Text kann man beispielsweise die Tageszeit oder die Farbgebung in einem Video ändern, Sounds oder kurze Musikstücke generieren, Untertitel, Logos oder Animationen erstellen, Skripte direkt in Storyboards mit ersten Visualisierungen umwandeln oder passende B-Roll-Clips aus vorhandenem Videomaterial finden.

Video: Adobe

Im Laufe des Jahres sollen die neuen generative KI-Funktionen für Video-, Audio-, Animations- und Motion-Graphics-Design eingeführt werden. Interessierte können sich für die Firefly-Beta anmelden. Am Donnerstag, den 20. April, findet zudem eine Community-Live-Session auf YouTube statt.

Adobe bringt vorerst kein Text-zu-Video-Modell

Ein Text-zu-Video-Modell wurde von der Firma noch nicht offiziell angekündigt. Da aber in der Firefly-Ankündigung die Synthese von Bild- und Texteffekten nur als erster Schritt bezeichnet wird, ist es sehr wahrscheinlich, dass Adobe auch an einem Text-zu-Video-Modell arbeiten wird. RunwayML testet derzeit mit Gen-2 ein solches generatives Modell für Video.

Neben den neuen Anwendungen für Firefly hat Adobe auf der NAB auch eine Text-Steuerung für Adobe Premiere Pro angekündigt. Das textbasierte Editing basiert auf Adobe Sensei und transkribiert Quellmedien automatisch. . Dadurch kann Filmmaterial per Transkription schneller durchsucht, aber auch per Texteingabe geschnitten werden: Nutzer:innen können Sätze aus dem Transkript in die Timeline einfügen und Premiere Pro schneidet das Video anschließend automatisch entsprechend der jeweiligen Stellen im Transkript.