Agentic Vision: Gemini schreibt sich jetzt eigenen Code, um Bilder besser zu verstehen

Kurz & Knapp

- Google Deepmind erweitert Gemini-3-Flash um "Agentic Vision": Das Modell kann Bilder aktiv zoomen, zuschneiden und manipulieren, indem es Python-Code generiert und ausführt – statt sie nur einmal passiv zu verarbeiten.

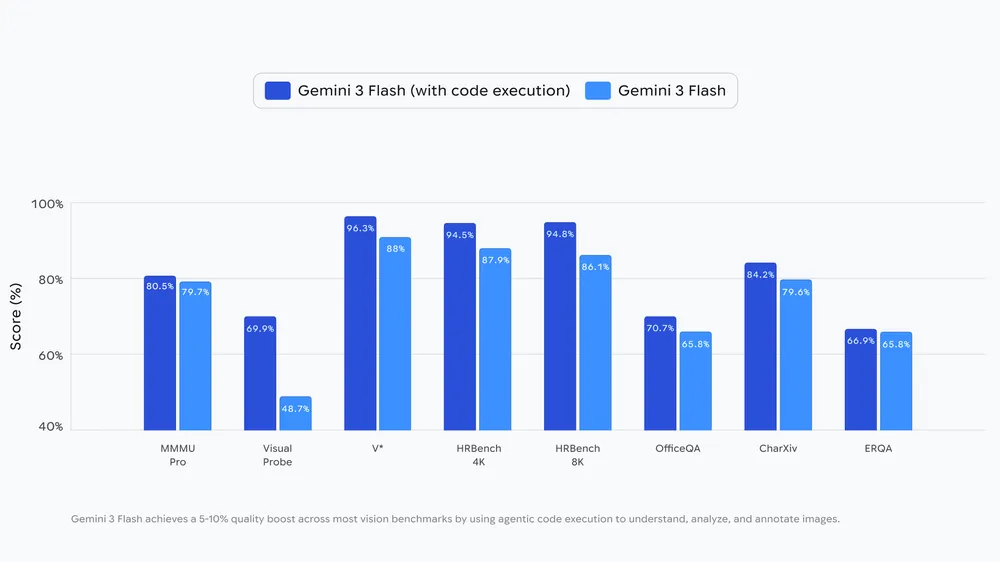

- Google gibt an, dass die Technik die Benchmark-Ergebnisse um 5 bis 10 Prozent verbessert. Ein Bauplan-Startup nutzt die Funktion bereits, um hochauflösende Pläne iterativ auf Vorschrifteneinhaltung zu prüfen.

- Einschränkung: Viele Funktionen wie Bildrotation oder visuelle Mathematik erfordern noch explizite Anweisungen im Prompt. Google plant Updates und eine Erweiterung auf weitere Modelle.

Google Deepmind stattet sein Gemini-3-Flash-Modell mit einer neuen Fähigkeit namens "Agentic Vision" aus. Das Modell soll Bilder nicht mehr nur passiv betrachten, sondern aktiv untersuchen können - allerdings funktioniert das noch nicht in allen Fällen automatisch.

Herkömmliche KI-Modelle verarbeiten Bilder in einem einzigen Durchgang. Übersehen sie dabei ein Detail, bleibt ihnen nur das Raten. Google Deepmind will das mit "Agentic Vision" ändern. Das Modell soll Bilder Schritt für Schritt zoomen, zuschneiden und manipulieren können, indem es Python-Code generiert und ausführt.

Die Funktionsweise folgt einem sogenannten Think-Act-Observe-Loop. Das Modell analysiert zunächst die Anfrage und das Bild, formuliert einen Plan. Dann generiert und führt es Python-Code aus - etwa zum Zuschneiden, Rotieren oder Annotieren von Bildern. Das Ergebnis wird dem Kontextfenster hinzugefügt, sodass das Modell die neuen Daten inspizieren kann, bevor es antwortet. Google gibt an, dass die Code-Ausführung eine Qualitätsverbesserung von 5 bis 10 Prozent über verschiedene Vision-Benchmarks liefert.

Ganz so neu ist diese Idee allerdings nicht: OpenAI führte vergleichbare Fähigkeiten bereits mit dem o3-Modell ein.

Bauplan-Startup meldet Verbesserungen

Als Praxisbeispiel nennt Google die Plattform PlanCheckSolver.com, die Baupläne auf Vorschrifteneinhaltung prüft. Das Startup gibt an, seine Genauigkeit um 5 Prozent verbessert zu haben, indem es Gemini 3 Flash hochauflösende Pläne iterativ inspizieren lässt. Das Modell schneidet dabei Bereiche wie Dachkanten oder Gebäudeabschnitte zu und analysiert sie einzeln.

Bei der Bildannotation kann das Modell zudem Bounding Boxes und Labels auf Bilder zeichnen. Google zeigt als Beispiel das Zählen von Fingern: Das Modell markiert jeden Finger mit einer Box und Nummer, um Zählfehler zu vermeiden.

Für visuelle Mathematik soll das Modell Tabellen parsen und Berechnungen in einer Python-Umgebung ausführen können, statt zu halluzinieren. Das Ergebnis kann es als Diagramm ausgeben.

Viele Funktionen brauchen noch explizite Anweisungen

Google räumt ein, dass die Fähigkeiten noch nicht durchgängig automatisch funktionieren. Während das Modell beim Zoomen auf kleine Details bereits implizit handelt, erfordern andere Funktionen wie das Rotieren von Bildern oder visuelle Mathematik noch explizite Hinweise im Prompt. Das Unternehmen will diese Einschränkungen in zukünftigen Updates beheben.

Zudem ist Agentic Vision bislang nur für das Flash-Modell verfügbar. Eine Erweiterung auf andere Modellgrößen ist laut Google geplant, ebenso wie zusätzliche Tools wie Web- und Reverse-Image-Suche.

Agentic Vision ist über die Gemini API in Google AI Studio und Vertex AI verfügbar. In der Gemini-App beginnt der Rollout - Nutzer können "Thinking" im Model-Dropdown auswählen. Eine Demo-App und Entwickler-Dokumentation stehen bereit.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren