Googles Spotlight-KI soll mobile Interfaces verbessern

Google zeigt Spotlight, ein multimodales KI-Modell, das mobile Interfaces verstehen kann. Damit sollen Barrierefreiheit und Automatisierung verbessert werden.

Das Unternehmen hat bereits in der Vergangenheit spezialisierte Modelle vorgestellt, die beispielsweise Bildschirminhalte zusammenfassen, bedienbare Elemente erkennen oder einfache Befehle ausführen können. Diese Modelle nutzten laut Google neben visuellen Daten vor allem Metadaten mobiler Webseiten, die aber nicht immer verfügbar und oft unvollständig sind.

Mit Spotlight trainiert das Google-Team daher ein multimodales KI-Modell, das ausschließlich mit visuellen Informationen arbeitet.

Googles Spotlight nutzt Vision Transformer und T5-Sprachmodell

Spotlight besteht aus einem vortrainierten Vision Transformer und einem vortrainierten T5-Sprachmodell. Es wird von Google mit zwei Datensätzen trainiert, die insgesamt 2,5 Millionen mobile UI Screens und 80 Millionen Webseiten umfassen. So profitiert das KI-Modell von den allgemeinen Fähigkeiten der großen Modelle.

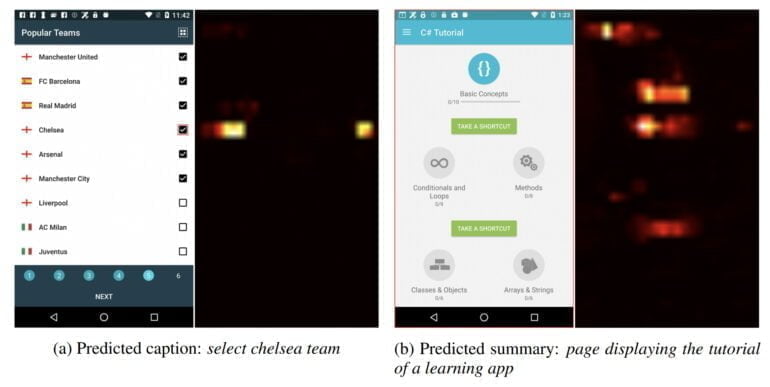

Zusätzlich verwendet Google ein MLP-Netz, um einzelne Regionen auf einem Screenshot zu repräsentieren und für die Verarbeitung zu extrahieren, zum Beispiel um klickbare Buttons zu erkennen.

Video: Google

Das Team trainiert zwei verschiedene Modellgrößen (619 Millionen und 843 Millionen Parameter) für jede getestete Aufgabe einzeln und einmal für alle Aufgaben. Die Aufgaben umfassen die Beschreibung einzelner Elemente, der gesamten sichtbaren Seite oder die Erkennung von Bedienelementen.

Die spezialisierten Spotlight-Modelle sind allen älteren UI-Expertenmodellen von Google deutlich überlegen. Das Modell, das auf allen vier Aufgaben trainiert wurde, verliert zwar an Leistung, ist aber immer noch konkurrenzfähig, so das Team.

Google will Spotlight skalieren

In den Visualisierungen kann Google zeigen, dass Spotlight z.B. bei dem Befehl "Wähle das Chelsea Team" auf dem Screenshot sowohl auf das Bedienelement als auch auf den Text Aufmerksamkeit richtet. Der multimodale Ansatz funktioniert also.

Im Vergleich zu anderen multimodalen Modellen wie Flamingo ist Spotlight relativ klein. Das größere der beiden Spotlight-Modelle zeigt bereits eine bessere Performance als das kleinere. Das Modell könnte also weiter skaliert werden und so noch deutlich besser werden.

"Spotlight lässt sich leicht auf andere UI-Aufgaben anwenden und kann viele Interaktions- und User-Experience-Aufgaben vorantreiben", schreibt das Team.

Googles UI-Modell könnte in Zukunft vielleicht die Grundlage für eine zuverlässige Sprachsteuerung von Apps und mobilen Webseiten auf Android-Smartphones bilden oder andere Automatisierungsaufgaben übernehmen. Wie so etwas im Webbrowser aussehen könnte, hat das Start-up Adept im vergangenen Jahr mit dem Action Transformer gezeigt.

Mehr Informationen gibt es in Googles Blog-Beitrag zu Spotlight.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.