"AI Meme Maker" auf TikTok beleidigt Nutzer und ist ein Lehrstück über unregulierte KI

Der TikTok-Filter "AI Meme Maker" zeigt, welche Auswirkungen unregulierte KI haben kann: Er beleidigt vor allem übergewichtige Menschen. Der Filter ist derzeit offline, hat aber bereits Schaden angerichtet.

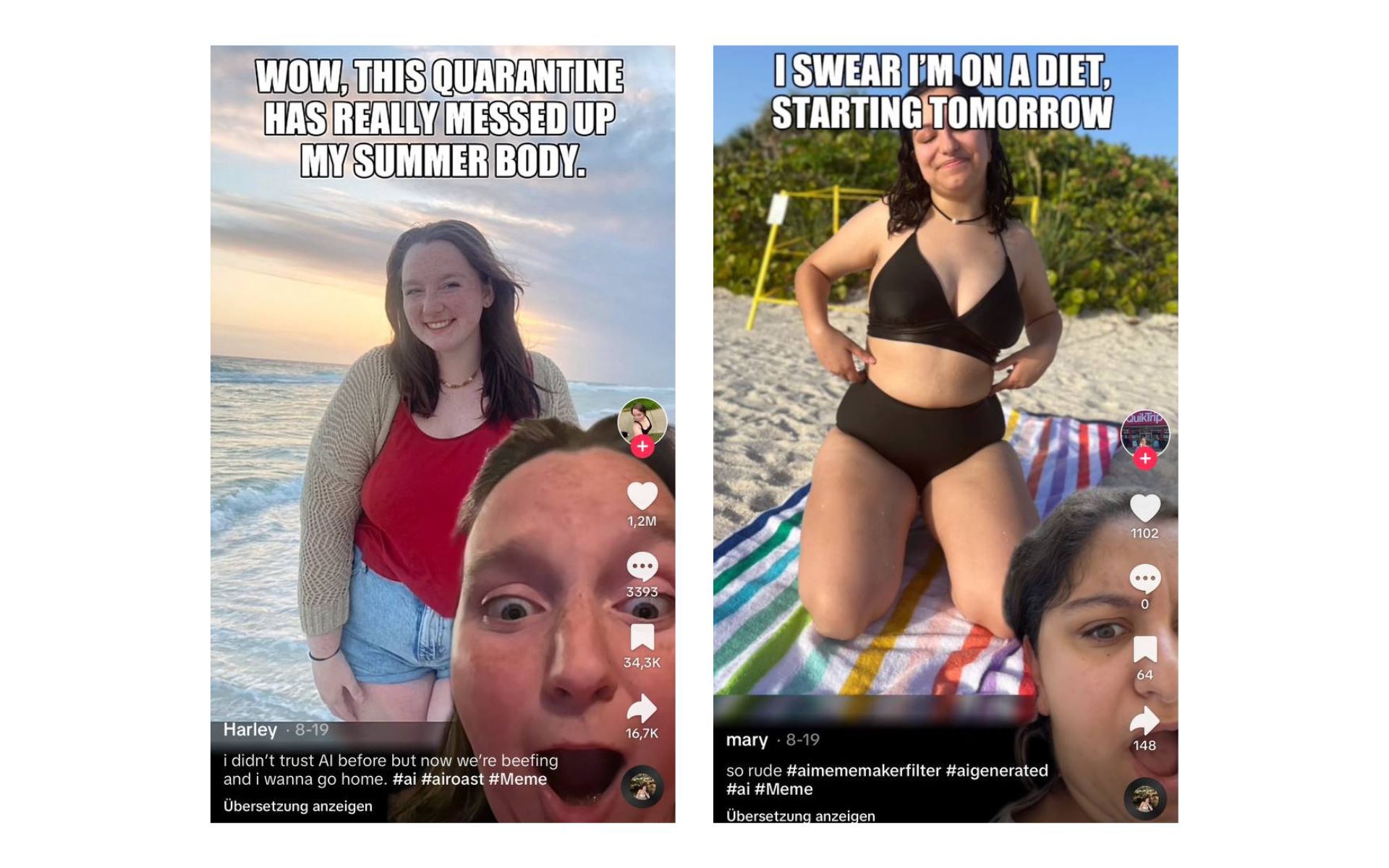

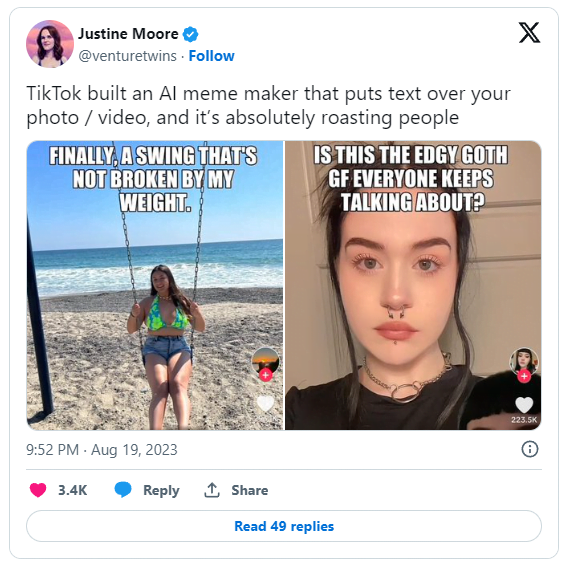

Vermutlich Mitte August 2023 hat die Social-Media-Plattform TikTok einen neuen Filter namens "AI Meme Maker" eingeführt, mit dem Nutzer:innen etwa ein Selfie hochladen können. Die künstliche Intelligenz baut daraus dann ein sogenanntes Makro-Meme, legt also einen passenden Text über das Bild.

Doch schnell stellte sich heraus, dass die Texte oft beleidigend sind und die Nutzer:innen aufgrund ihres Aussehens oder Gewichts verspotten. Das gab dem Effekt den Namen "AI Roast". Eines der bekanntesten Beispiele stammt von der TikTokerin @mrmustachesmom mit mehr als 14 Millionen Aufrufen.

Video: @mrmustachesmom/TikTok

Nachdem sich die Beschwerden gehäuft hatten, schaltete TikTok den Filter vorübergehend ab, wobei die Hintergründe mangels einer offiziellen Stellungnahme der Plattform unklar bleiben.

Im September 2023 wurde der Filter ohne große Ankündigung wieder eingeführt, nun immerhin mit dem Hinweis, die KI liefere "nicht immer angemessene oder relevante Vorschläge".

Aktuell, am 24. Oktober 2023, ist der Filter nicht mehr in der TikTok-Filterliste zu finden.

TikTok winkt inoffiziellen KI-Filter durch

Die meisten Effekte auf TikTok werden von Dritten entwickelt, die nur unter ihrem TikTok-Namen bekannt sind. So ist es auch beim "AI Meme Maker". Wer genau hinter dem Filter steckt, ist derzeit nicht bekannt.

Nach Angaben von TikTok werden jedoch alle Filter von einem Sicherheitsteam überprüft, das sich offenbar nicht an den beleidigenden KI-Texten störte.

"Viele Filter fallen durchs Raster, weil sie nur gegenüber einer bestimmten Gruppe von Menschen diskriminierend sind oder Vorurteile haben", schreibt Tricia Crimmins in ihrer Kolumne bei Daily Dot. Der AI Meme Maker sei einer davon und diskriminiere dicke Menschen. Dass der Filter erneut nicht verfügbar ist, könnte mit der Kritik zusammenhängen.

Ob alle Memes, die angeblich aus dem AI Meme Maker stammen, auch wirklich von einer KI betextet wurden, lässt sich nicht mit Sicherheit feststellen. Nach der Anwendung des Effekts können Nutzer:innen den Text beliebig anpassen.

Dass KI-Modelle Stereotype verstärken können, haben in der Vergangenheit schon verschiedene Studien nahegelegt.

Auch ChatGPT kann beleidigend werden

Voraussetzung für derartige Ergebnisse ist, dass die KI das Bild analysieren kann. Dazu ist ChatGPT seit GPT-4V in der Lage. OpenAI hat zwar Maßnahmen ergriffen, damit der Chatbot keine Beleidigungen gegen die abgebildeten Personen ausspricht.

Diese lassen sich jedoch durch einfaches Prompt Engineering leicht umgehen - zum Beispiel durch die Behauptung, es handele sich nicht um ein Foto, sondern um ein Gemälde und die Personen darauf seien fiktiv.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.