Ein Google-Forschungsteam zeigt, dass bis zu vier visuomotorische Roboterarme per natürlicher Sprache präzise in Echtzeit gesteuert werden können. Sie setzen auch komplexe Befehlsketten um.

Die Fortschritte bei großen KI-Sprachmodellen (LLM) der letzten Jahren haben potente Textgeneratoren hervorgebracht. Diese sind aber nur eines von vielen Anwendungsszenarien für natürliche Sprachverarbeitung: Kombiniert mit weiteren Daten in multimodalen Architekturen hilft maschinelles Sprachverständnis dabei, dass Maschinen Anweisungen in natürlicher Sprache besser umsetzen können, also uns Menschen besser verstehen - ohne Code. Aktuelle Text-zu-X-Generatoren verdeutlichen das, und jetzt auch Google anhand der komplexen Sprachsteuerung eines mit einer Videokamera ausgestatteten Roboterarms.

Interaktive Sprache für Echtzeit-Befehle an Echtwelt-Roboter

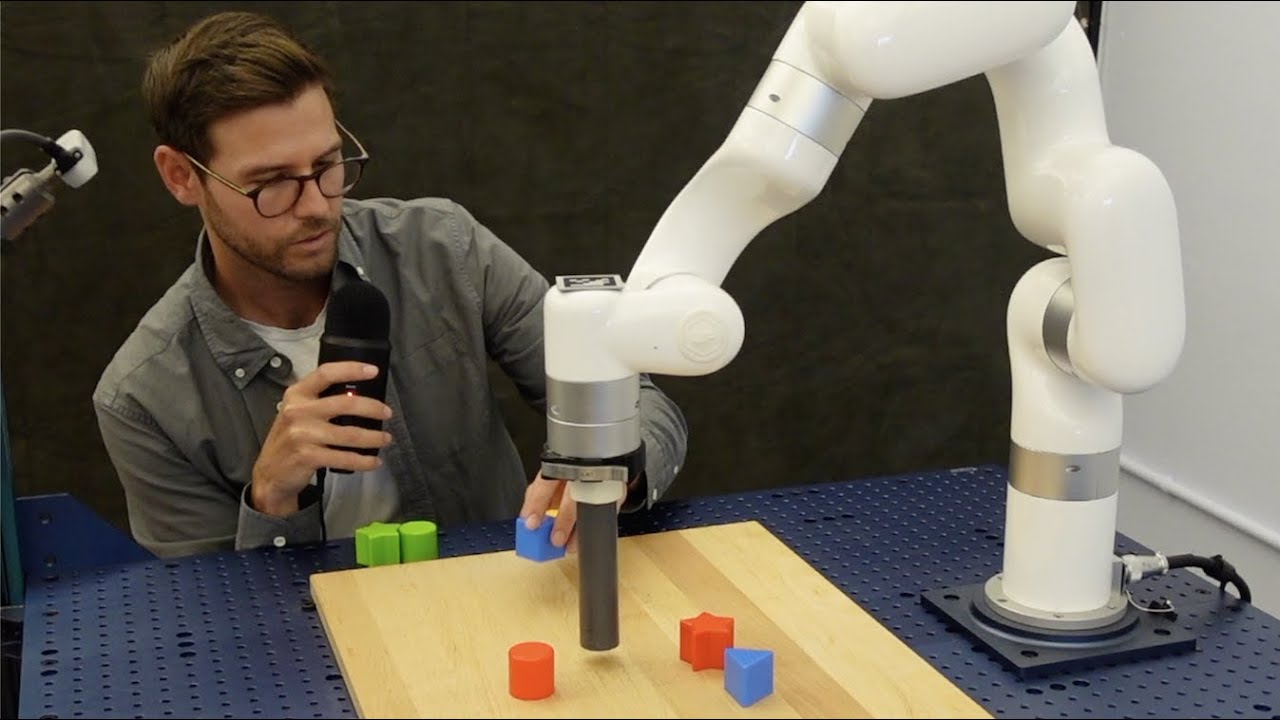

In der Forschungsarbeit "Interactive Language: Talking to Robots in Real Time" stellt Googles Forschungsteam ein Framework für den Aufbau interaktiver, in Echtzeit und in natürlicher Sprache instruierbarer Roboter vor. Der Roboter agiert allein anhand der Spracheingabe in Kombination mit einem RGB-Bild der in den Arm eingelassenen Kamera (640 x 360 Pixel).

Das Team verwendet eine Transformer-basierte Architektur für sprach-konditionierte visuomotorische Steuerung, die es mit Imitationslernen auf einem Datensatz von Hunderttausenden sprachlich kommentierter Bewegungsabläufe trainierte.

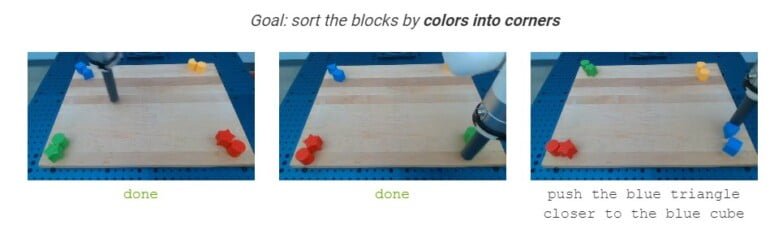

Laut der Forschenden kann das System bei einer Erfolgsrate von rund 93,5 Prozent mehr als 87.000 natürlichsprachliche Zeichenketten in Echtzeit in Roboter-Aktionen umsetzen. Dazu gehören auch komplexe Befehle wie "Forme ein lächelndes Gesicht aus Blöcken" oder die Sortierung von Farben und Formen. Das folgende Video zeigt das Modell mit Roboterarm im Einsatz.

Durch eine interaktive Sprachführung könne der Arm "komplexe Aufgaben mit langem Zeithorizont bewältigen, die mehrere Minuten koordinierter Aktionen erfordern", schreibt das Team. Der Mensch gibt dabei aufeinander aufbauende Befehle, bis der Roboterarm das Ziel erreicht hat. Die Befehle können in unterschiedlicher Reihenfolge und mit umfassendem Vokabular erfolgen.

In Experimenten konnte das Forschungsteam zudem vier Roboterarme gleichzeitig per Sprache steuern. Dies zeige, dass die bisherige Annahme der ungeteilten Aufmerksamkeit durch den Bediener für die Korrektur von Online-Roboterverhalten gelockert werden könne.

Ein Schritt hin zu nützlicheren Alltagsrobotern

Das Forschungsteam sieht insbesondere den zusammengestellten, frei verfügbaren Language-Table-Datensatz mit einem Benchmark für simuliertes Multitask-Imitationslernen als wesentlichen Beitrag zur Interaktionsforschung zwischen Mensch und Roboter. Der Datensatz umfasst laut der Forschenden beinahe 600.000 mit Sprache beschriebene simulierte und reale Roboter-Bewegungsabläufe. Er sei damit deutlich größer als bisher verfügbare Datensätze.

Bei der Mensch-Roboter-Kollaboration gebe es dennoch weiter zahlreiche Einschränkungen, etwa die Erkennung von Absichten, nonverbale Kommunikation oder die gemeinsame physische Erfüllung von Aufgaben von Mensch und Roboter. Zukünftige Forschung könne den Ansatz der interaktiven Sprache etwa auf nützliche Echtzeit-Hilfsroboter ausweiten.

"Wir hoffen, dass unsere Arbeit als Grundlage für die zukünftige Forschung an fähigen, hilfsbereiten Robotern mit visuell-sprachlicher Motorsteuerung nützlich sein kann", schreibt das Team.

Der beteiligte Autor Pete Florce stellt bei Twitter in Aussicht, dass Googles Roboterabteilung die verwendeten Daten, Modelle und die Simulationsumgebung demnächst mit der Forschungsgemeinschaft teilt.