Alibaba packt leistungsstarkes Reasoning in kompaktes KI-Modell QwQ-32B

Alibaba hat ein KI-Modell entwickelt, das die Effizienz von Reinforcement Learning demonstriert. Das Modell könnte den Wettbewerb im Bereich Reasoning-Modelle beeinflussen und die Entwicklung ressourcenschonender KI-Systeme vorantreiben.

Alibabas neues QwQ-32B erreichte trotz seiner vergleichsweise geringen Anzahl von 32 Milliarden Parametern eine bemerkenswerte Leistung. Bereits im November 2024 hatte das Unternehmen mit QwQ-32B-Preview eine Vorabversion präsentiert.

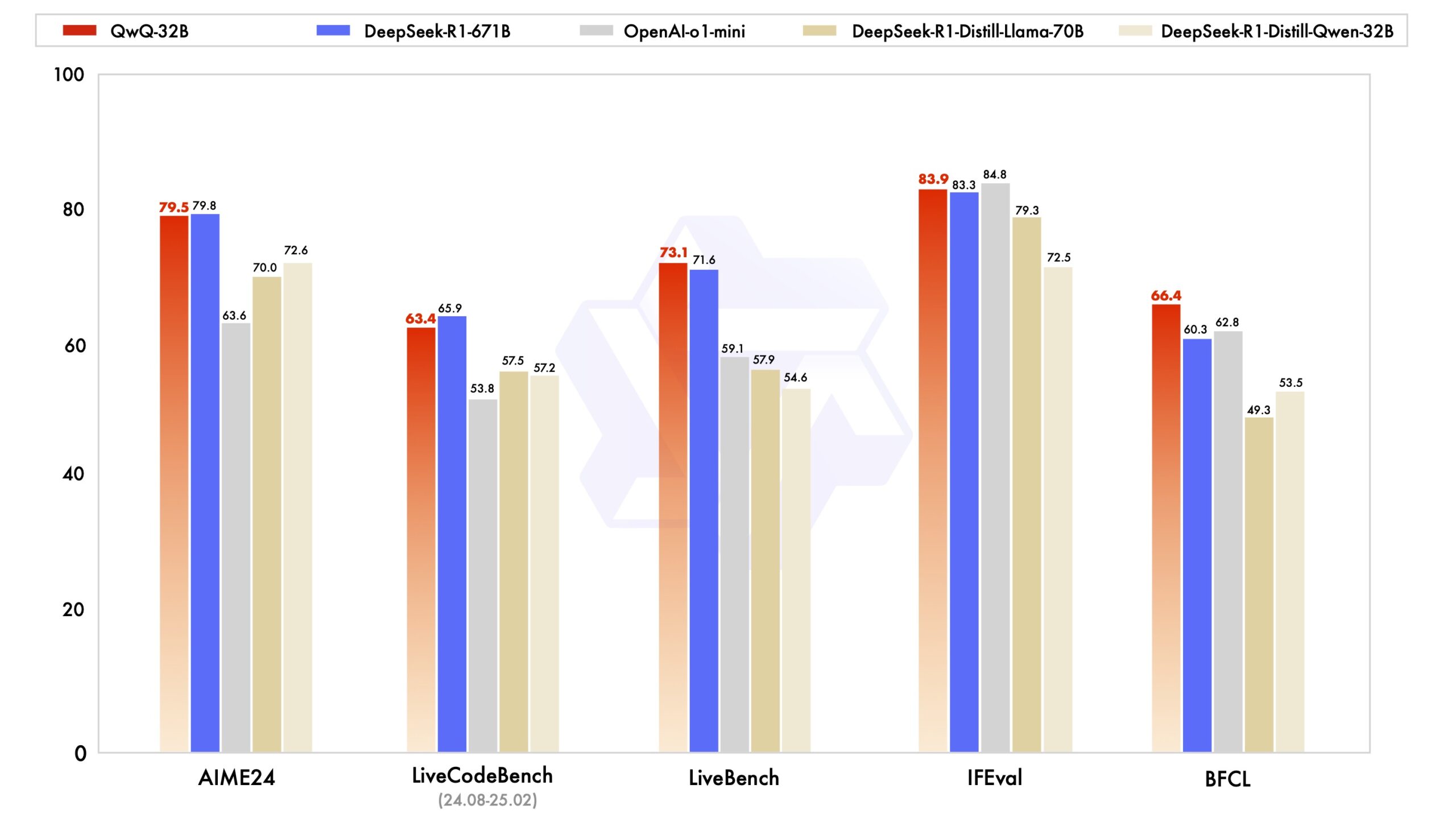

In verschiedenen Benchmarks, die mathematische Fähigkeiten, Programmierkompetenz und allgemeine Problemlösungsfähigkeiten testen, erzielte QwQ-32B ähnliche Ergebnisse wie das viel größere DeepSeek-R1 von DeepSeek mit 671 Milliarden Parametern.

Die größte Version von DeepSeek-R1 verwendet eine sogenannte Mixture-of-Experts-Architektur, das heißt, von den 671 Milliarden Parametern sind bei jedem Durchlauf nur 37 Milliarden Parameter aktiv. Dennoch benötigt es große Mengen an Grafikspeicher, um das Modell auszuführen. QwQ-32B könnte für schwächere Hardware interessant sein, ohne dass große Leistungseinbußen zu befürchten sind.

Zweistufiges Training mit Reinforcement Learning

Die Forscher von Alibaba erklären die Leistungsfähigkeit von QwQ-32B mit der effektiven Anwendung von Reinforcement Learning auf ein Foundation-Model, das auf umfangreichem Weltwissen vortrainiert wurde. Beim Reinforcement Learning lernt das Modell durch die Interaktion mit menschlichen oder maschinellen Beurteilern und verbessert seine Leistung kontinuierlich auf der Grundlage von Belohnungen.

Das Training erfolgte in zwei Stufen: Zunächst wurde RL für Mathematik- und Programmieraufgaben skaliert, wobei ein Genauigkeitsprüfer für mathematische Probleme und ein Code-Ausführungsserver verwendet wurden. In der zweiten Stufe folgte eine zusätzliche RL-Phase für allgemeinere Fähigkeiten wie Instruktionsbefolgung, Ausrichtung an menschliche Präferenzen und Agentenleistung.

Durch die Integration von agentenbezogenen Fähigkeiten kann QwQ-32B kritisch denken, Werkzeuge nutzen und seine Schlussfolgerungen basierend auf Umgebungsfeedback anpassen.

QwQ-32B wurde von Alibaba unter der Apache-2.0-Lizenz als Open-Weight-Modell auf Plattformen wie Hugging Face und ModelScope veröffentlicht. Dadurch können Forscher:innen und Entwickler:innen das Modell untersuchen, weiterentwickeln und neue Anwendungsmöglichkeiten erschließen.

Die Nutzung von QwQ-32B ist zudem über die Hugging Face Transformers und die Alibaba Cloud DashScope API möglich. Interessierte können das Modell auch über die hauseigene ChatGPT-Alternative Qwen Chat testen.

Alibabas Weg zur AGI

Das Reasoningmodell ist Teil von Alibabas großangelegter KI-Strategie, die auch die teilweise multimodale Qwen2.5-Serie mit spezialisierten Modellen für Sprache, Programmierung und Mathematik sowie das auf große Kontextfenster ausgelegte Qwen2.5-Turbo umfasst.

Um diese Ziele zu erreichen, hat Alibaba erst im Februar eine Investition von umgerechnet 50 Milliarden Euro angekündigt, die in KI-Entwicklung und Cloudinfrastruktur fließen sollen. Zuvor wurde bekannt, dass sich chinesische Unternehmen mit der Entwicklung von Prozessoren für das Training von Large Language Models unabhängiger von US-Unternehmen wie Nvidia machen wollen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.