AMDs Instinct MI300X: Starke Konkurrenz für Nvidia, aber zu spät?

Mit dem Instinct MI300X stellt AMD sein Konkurrenzprodukt zu den KI-Chips von Nvidia vor. Laut CEO Lisa Su stößt das Produkt auf großes Interesse. Doch Nvidia ist vorbereitet.

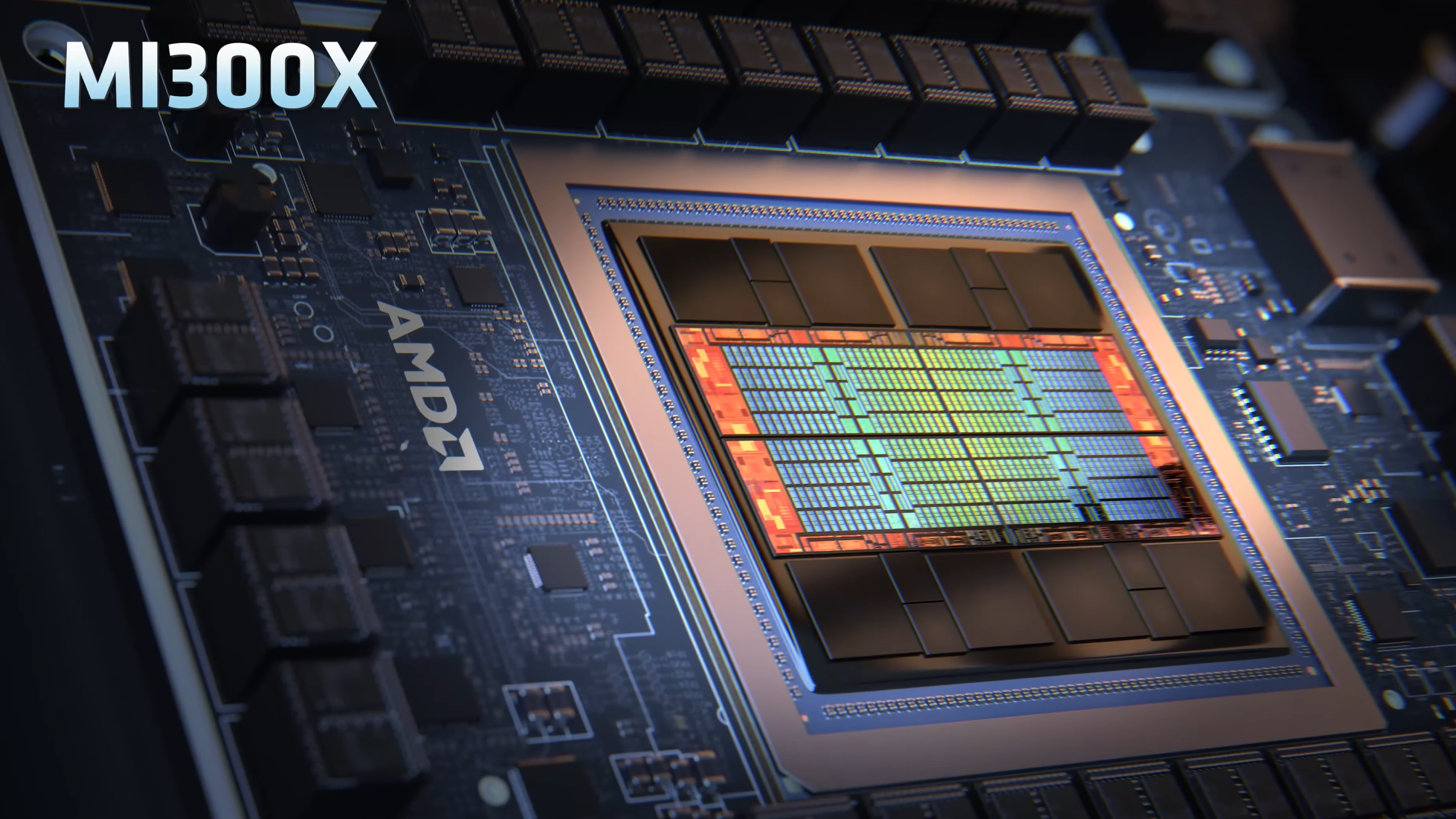

Im Rahmen des Advancing AI Events hat AMD seine neuesten KI-Chips vorgestellt, die Instinct MI300X GPU und die MI300A APU. Laut AMD wurde die MI300-Serie mit fortschrittlichen Produktionstechnologien, einschließlich 3D-Packaging, hergestellt und soll bei verschiedenen KI-Workloads leistungsfähiger als Nvidias GPUs sein. Laut AMD bietet die Instinct MI300X GPU bis zu 1,6 Mal mehr Leistung als Nvidias H100 bei KI-Inferenz-Workloads und eine ähnliche Leistung bei Trainings-Workloads. Darüber hinaus verfügt der Beschleuniger über 192 Gigabyte HBM3-Kapazität mit einer Bandbreite von 5,3 TB/s. Der MI300A mit 128 Gigabyte Speicher ist laut AMD die erste Datacenter-APU der Welt und konkurriert mit Nvidias Superchip Grace Hopper.

Die neuen Prozessoren werden derzeit an OEM-Partner ausgeliefert, und AMD betonte, über die Produktionskapazitäten zu verfügen, um die Nachfrage zu befriedigen, was angesichts der aktuellen GPU-Engpässe ein Wettbewerbsvorteil sein könnte.

H200 GPU: Nvidia ist auf Konkurrenz eingestellt

Neben Intel, die mit ihren neuesten Gaudi-Chips in einigen Benchmarks mit Nvidias H100 mithalten können, hat nun auch AMD einen echten Konkurrenten im Angebot. Ob die in den Benchmarks von AMD gezeigte Leistung auch in der Praxis reproduziert werden kann, wird sich zeigen. Nvidia dürfte hier einen Vorsprung haben, da das Unternehmen seit Jahren zahlreiche Supercomputer mit eigener KI-Hardware ausstattet und bereits mehrfach gezeigt hat, dass mit Software-Optimierungen deutliche Leistungssprünge möglich sind.

Zudem hat Nvidia mit der H200-GPU bereits eine neue GPU und einen neuen Grace-Hopper-Superchip vorgestellt, der dank schnellerem HBM3e-Speicher mit 141 Gigabyte Speicher und einer Bandbreite von 4,8 Terabyte pro Sekunde die Inferenz von KI-Modellen gegenüber der H100 nahezu verdoppeln soll.

Systeme und Cloud-Instanzen mit H200 werden voraussichtlich ab dem zweiten Quartal 2024 verfügbar sein, einschließlich HGX H200-Systemen und in verschiedenen Rechenzentrumsumgebungen. Ab 2024 wird H200 auch im GH200-Supercomputer eingesetzt, unter anderem im JUPITER-Supercomputer des Forschungszentrums Jülich. Der Nachfolger B100 soll ebenfalls 2024 erscheinen.

AMD setzt auf niedrigere Preise und verbesserte Software

Obwohl AMD den Preis für den MI300X nicht bekannt gab, betonte CEO Lisa Su, dass der AMD-Chip weniger kosten müsse als Nvidias Angebot, um Kunden zum Kauf zu bewegen. Abgesehen vom Preis gibt es jedoch noch andere Herausforderungen, um Unternehmen, die auf Nvidia gesetzt haben, davon zu überzeugen, Zeit und Geld in einen anderen GPU-Anbieter zu investieren. Su räumt ein, dass es "Arbeit ist, AMD zu akzeptieren." Um dieses Problem zu lösen, hat AMD seine Software-Suite ROCm verbessert, um mit Nvidias CUDA-Software konkurrieren zu können.

Angesichts der hohen Preise und Engpässe scheint das Interesse groß zu sein: AMD gab bekannt, dass einige der größten GPU-Käufer, darunter Meta und Microsoft, bereits Interesse am MI300X haben. Meta plant, die GPUs für KI-Inferenz-Workloads wie die Verarbeitung von KI-Stickern, Bildbearbeitung und den Betrieb seines Assistenten einzusetzen. Microsofts CTO Kevin Scott erklärte, das Unternehmen werde über seinen Webdienst Azure Zugang zu den MI300X-Chips bieten. Oracles Cloud wird die Chips ebenfalls nutzen, und OpenAI kündigte an, AMD-GPUs in einem seiner Softwareprodukte namens Triton zu unterstützen, das in der KI-Forschung verwendet wird, um auf Chipfunktionen zuzugreifen.

Wird das reichen, um den Branchenführer Nvidia einzuholen? AMD prognostiziert für 2024 einen Gesamtumsatz von rund 2 Milliarden US-Dollar mit GPUs für Rechenzentren. Zum Vergleich: Nvidia meldete allein im letzten Quartal mehr als 14 Milliarden US-Dollar Umsatz im Data-Center-Bereich. Su deutete an, dass AMD nicht unbedingt Nvidia schlagen müsse, um auf dem Markt erfolgreich zu sein: "Wir glauben, dass es bis 2027 400 Milliarden US-Dollar oder mehr sein könnten. Und wir könnten ein gutes Stück davon abbekommen."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.