Apple will noch in diesem Jahr ein eigenes Large Language Model (LLM) für seine Geräte auf den Markt bringen.

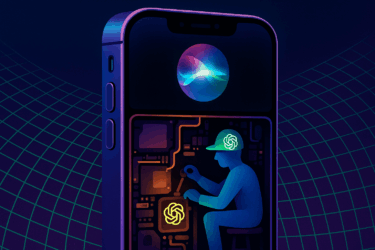

Das Unternehmen entwickelt den Algorithmus, auf dem die generativen KI-Funktionen basieren, vollständig für den lokalen Betrieb auf dem Gerät selbst, berichtet Bloombergs Apple-Reporter Mark Gurman.

Dadurch sollen die Antwortzeiten deutlich schneller und der Datenschutz einfacher zu gewährleisten sein als bei Cloud-basierten Lösungen. Details sollen auf der Worldwide Developers Conference im Juni bekannt gegeben werden.

Die Einführung von generativer KI in iOS 18 könnte Apple helfen, mit anderen KI-Assistenten wie Googles Bard, OpenAIs ChatGPT und Microsofts Copilot Schritt zu halten. Apple wird wahrscheinlich eine Marketingbotschaft vermitteln und zeigen, wie die Technologie den Menschen im Alltag helfen kann.

Apple muss aufholen

Laut Gurman holt Apple im Bereich der fortgeschrittenen KI gegenüber Unternehmen wie OpenAI und Google auf. Die ersten KI-Funktionen von Apple werden wahrscheinlich nicht besser sein als die der Konkurrenz.

Da das LLM direkt auf dem Prozessor des iPhones läuft, könnten die KI-Tools in einigen Fällen etwas weniger leistungsfähig und wissend sein. Dafür soll die Latenz sehr gering sein und Apple hat keine Probleme mit dem Datenschutz.

Zuletzt hatte Apple das kanadische KI-Start-up DarwinAI übernommen, das Technologien zur visuellen Inspektion von Bauteilen während der Produktion entwickelt und darauf spezialisiert ist, KI-Systeme kleiner und schneller zu machen.

Unklar ist, ob und wie sich diese Entscheidung auf Apples Verhandlungen mit Google und OpenAI über die Bereitstellung ihrer Cloud-basierten KI-Dienste auf Apple-Geräten auswirkt. Angeblich sollen die Big-Tech-Unternehmen bereits im Gespräch sein.

Apple könnte mit Gemini oder GPTs KI-Funktionen abbilden, für die die eigene lokale KI nicht gut genug ist. Auf der anderen Seite droht ein Imageschaden, wenn Google und Co. Fehler beim Datenschutz machen.