Apple bietet mit OpenELM eine Reihe von Open-Source-Sprachmodellen an, die auf Effizienz getrimmt sind und mit weniger Trainingsdaten eine bessere Leistung erzielen als vergleichbare Modelle.

Apple-Forscher veröffentlichen OpenELM (Open-source Efficient Language Models), eine Familie von Open-Source-Sprachmodellen mit bis zu drei Milliarden Parametern. S

Die basieren laut der Forscher auf einer schichtweisen Skalierungsstrategie, die die Parameter innerhalb der Transformationsschichten effizienter verteilt. Dadurch erreicht OpenELM eine höhere Genauigkeit als vergleichbare Modelle.

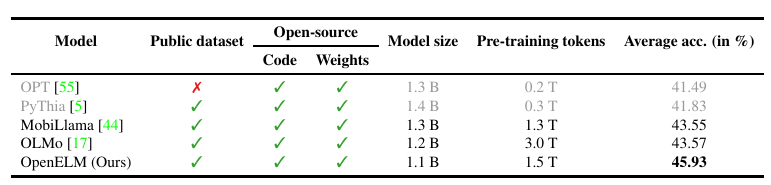

Laut Forschungsbericht übertrifft ein OpenELM-Modell mit 1,1 Milliarden Parametern das OLMo-Modell von AI21 Labs mit 1,2 Milliarden Parametern um 2,36 Prozent, obwohl es mit nur halb so vielen Trainings-Token für das Pretraining auskommt. OpenELM erreicht also mit weniger Rechenleistung und Daten eine höhere Performance.

Die OpenELM-Modelle sind in vier Größen erhältlich: 270 Millionen, 450 Millionen, 1,1 Milliarden und 3 Milliarden Parameter. Alle Modelle gibt es auch in einer Version, die mit Instruktionen verfeinert wurde. Sie sind auf Github und Huggingface verfügbar.

Apple stellt das gesamte Framework für Training und Finetuning als Open Source zur Verfügung. Dazu gehören das Trainingsprotokoll, mehrere Checkpoints und die Konfiguration für das Pretraining.

Darüber hinaus veröffentlicht Apple Code für die Konvertierung der Modelle in die MLX-Bibliothek, um Inferenz und Feinabstimmung auf Apple-Geräten zu ermöglichen.

Für das Training verwendete der Technologiekonzern öffentlich verfügbare Datensätze wie RefinedWeb, deduplizierte Versionen von The PILE, Teile von RedPajama und Dolma 1.6. Insgesamt umfasst der Trainingsdatensatz rund 1,8 Billionen Token.

Sicher, datenschutzfreundlich, auf dem Gerät

OpenELM dürfte ein weiterer Baustein in Apples KI-Strategie sein, die auf Datenschutz, Effizienz und Kontrolle setzt und generative KI wohl vorwiegend auf dem Gerät vorsieht.

Denkbar wären Verbesserungen für den Sprachassistenten Siri oder neue Funktionen in Apps wie Mail oder News. Das Unternehmen will zeigen, dass es führende KI-Systeme bauen kann, ohne Nutzerdaten auszubeuten.

Für anspruchsvolle Cloud-KI-Anwendungen könnte Apple mit Google, OpenAI und anderen Anbietern kooperieren. Details zu Apples generativer KI-Strategie dürften spätestens im Sommer auf der WWDC bekannt werden.