Atlas: KI-basierte 3D-Rekonstruktion mit nur einer Kamera

Forscher von Magic Leap präsentieren eine KI-gestützte Methode, um Szenen in 3D einzufangen - mit nur einer RGB-Kamera.

Die Atlas getaufte Methode besteht aus einem zweistufigen KI-Verfahren, das aus flachen 2D-Aufnahmen eine 3D-Umgebung generiert. Eine vorherige 3D-Analyse der Umgebung beispielsweise über Stereokameras oder ein spezielles Radarsystem ist nicht notwendig.

Die Forscher gehen davon aus, dass die KI-gestützte Rekonstruktion auf Basis von 2D-Bildern effizienter ist als auf 3D-Daten basierte Verfahren. Ihr Forschungsergebnis sehen sie als Beweis für diese Hypothese.

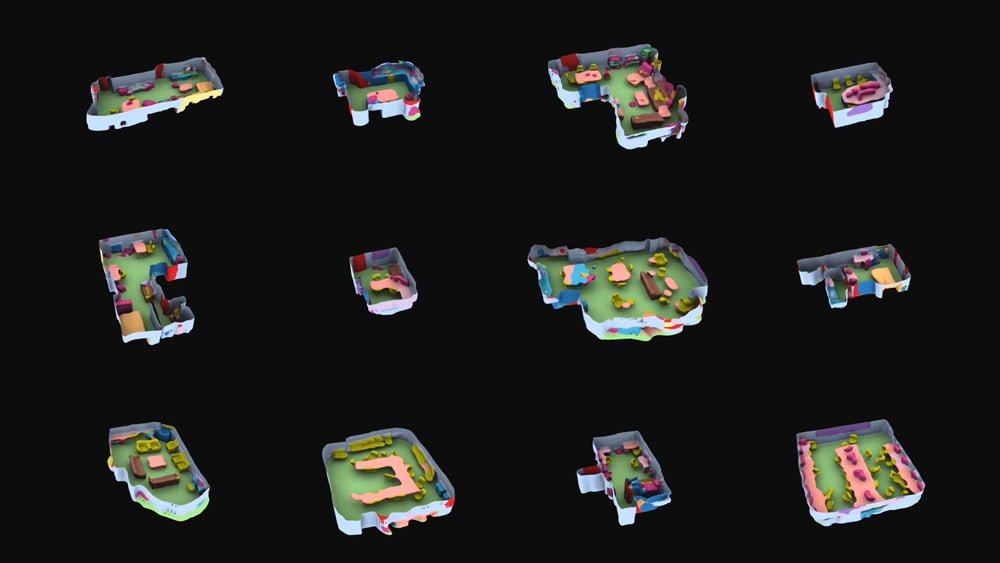

Ein auf Bildanalyse optimiertes neuronales Netz segmentiert die einzelnen 2D-Bilder unabhängig voneinander und erstellt ein einfaches auf den Kameradaten basiertes Voxel-3D-Modell.

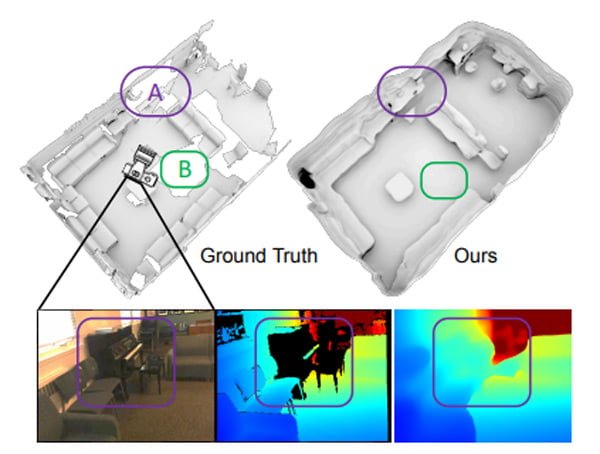

Diese sogenannte Rückprojektionstechnik muss man sich so vorstellen, als würde man einen Gebäudeplan aufzeichnen, indem man um das Gebäude herumgeht und durch jedes Fenster schaut. Man sieht nicht alles, aber aus den vielen unterschiedlichen Perspektiven kann ein stimmiges Gesamtbild der Innenräume aufgezeichnet werden.

KI-Rekonstruktion: Besser als 3D-Scanner?

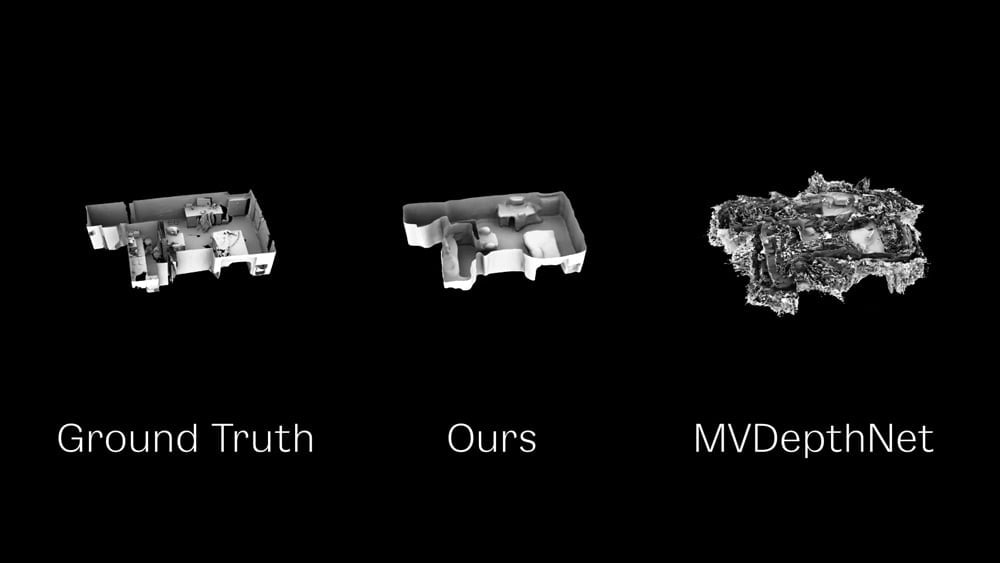

Ein zweites für 3D-Distanzschätzung trainiertes neuronales Netz verfeinert und ergänzt das 3D-Modell. Die Forscher können so ein vollständiges 3D-Modell einer Szene erstellen, sogar von Bereichen, die beim Scanvorgang verdeckt sind.

Die KI füllt diese blinden Flecken mit passender Bildinformation, die sie beim KI-Training mit dem Datensatz ScanNet gelernt hat, der hochwertige und dokumentierte 3D-Scans enthält.

Laut der Forscher schlägt ihr KI-gestütztes 2D-3D-Rekonstruktionsverfahren quantitativ und qualitativ gängige und aufwendigere Verfahren, die auf Hardware-basierte 3D-Analyse der Umgebung setzen.

Schnelle PC-Hardware ist allerdings Voraussetzung: Aktuell läuft die Rekonstruktion mit circa 14 Bildern pro Sekunde auf einer Nvidia Titan RTX. Die Anwendung der 3D-Rekonstruktion beispielsweise für eine schlanke AR-Brille, die den Raum in Echtzeit in 3D vermisst und digitale Objekte exakt darin platziert, liegt daher noch in weiter Ferne.

https://www.youtube.com/watch?v=9NOPcOGV6nU

Die Forscher stellen ihren Quellcode kostenlos bei Github zur Verfügung. Weitere Informationen und die wissenschaftliche Veröffentlichung gibt es auf der offiziellen Projektseite.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.