Social Bots beeinflussen die öffentliche Meinung über die sozialen Medien – Automatisierung und KI-Zauber sei Dank. Oder vielleicht doch nicht?

Soziale Medien haben unsere Realität gehörig aufgewirbelt. Ohne sie wären US-Präsidentschaftswahlen, Arabischer Frühling, Brexit, europäische Migrationspolitik, Hongkong-Proteste, das Corona-Virus oder Black Lives Matter Demonstrationen anders verlaufen oder vielleicht erst gar nicht ins Rollen gekommen.

Das Interesse politischer und gesellschaftlicher Akteure, die öffentliche Meinung und Wahrnehmung bestimmter Themen zu beeinflussen, zielt daher selbstverständlich auch auf die sozialen Medien ab. Egal ob politischer Wahlkampf, lokale Öffentlichkeitsarbeit oder Markenwerbung – ohne Social-Media-Auftritt läuft nicht mehr viel.

Das gilt auch auf internationaler Ebene: Großmächte wie die USA, China oder Russland nutzen die Netzwerke, um die öffentliche Meinung zu ihren Gunsten zu manipulieren. In den USA ist es das Militär und wohl auch die CIA, in China die 50-Cent-Party und in Russland die Internet Research Agency und andere Web-Brigaden. Weitere Fälle gibt es etwa in Saudi-Arabien oder dem Iran.

Eine neue Methode der Manipulation?

Spätestens seit 2016 steht ein neuer Vorwurf im Raum: Staaten und andere Akteure setzen auf automatisierte Meinungsmache durch sogenannte Social Bots. Diese sollen in sozialen Medien wie Twitter Reichweite erhöhen und mit anderen Nutzern glaubhaft interagieren, um nicht aufzufallen.

Anlass für die Vorwürfe war die US-Präsidentschaftswahlkampf 2016 zwischen Hillary Clinton und Donald Trump. Für mindestens 470.000 Retweets sollen russische Bots auf Twitter verantwortlich gewesen sein.

Seitdem schlagen regelmäßig neue Meldungen über Social Bots Wellen: Zehntausende, hunderttausende oder gar Millionen Social Bots sollen im Einsatz sein und etwa die Diskussion des UN-Migrationspakts oder des Corona-Virus beeinflussen. Fast die Hälfte aller Twitter-Accounts, die über „Reopening America“ diskutierten, könnten Bots sein, sagen Wissenschaftler der Carnegie Mellon University.

Die an der Studie beteiligte Informatik-Professorin Dr. Kathleen Carley beschreibt einen rasanten Anstieg der Social Bots: „Wir sehen bis zu doppelt so viele Bot-Aktivitäten, als wir aufgrund früherer Naturkatastrophen, Krisen und Wahlen vorhergesagt hatten.“ Das Team der CMU hatte insgesamt 200 Millionen Tweets analysiert.

Andere Forscher wie Michael Kreil, Daten-Journalist aus Berlin, oder Prof. Dr.-ing. Florian Gallwitz von der TH Nürnberg, stellen solche Behauptungen in Frage. Seit 2016 untersucht Kreil die Social Bots. Sein Fazit zur Causa Trump: „Social Bots haben Wahlen beeinflusst. Klingt das plausibel? Ja. Ist es wissenschaftlich fundiert? Kein bisschen.“

Was ist eigentlich ein Social Bot?

Wer über Bots redet, sollte sie definieren. Das Büro für Technikfolgen-Abschätzung beim Deutschen Bundestag (TAB) definierte Social Bots 2017 wie folgt:

„Social Bots sind Computerprogramme, die eine menschliche Identität vortäuschen und zu manipulativen Zwecken eingesetzt werden, indem sie wie Menschen im Internet kommunizieren (Bilton 2014; Fuchs 2016; Woolley und Howard 2016a, 2016b; Voß 2016). Echte Menschen, die mit dem Social Bot kommunizieren, nehmen diese nicht als durch Algorithmen ausgelöste automatische Kommunikation, sondern als echte Internetteilnehmer wahr und sind sich der Manipulation nicht bewusst.“ [2, S. 4]

Gibt es solche vollautomatischen Meinungsmacher? Kreil und Gallwitz sagen: Fehlalarm. Social Bots seien, wie Kreil es in einem Vortrag formuliert, „die Armee, die niemals existierte.“

Algorithmen suchen nach Algorithmen

Ausgelöst werden diese Falsch-positiven Befunde durch die Werkzeuge, mit denen Bot-Forscher nach Bots forschen, so Kreil und Gallwitz.

Dazu gehören etwa die Anti-Bot-Algorithmen Botometer und Bot Sentinel. Beide nutzen weitläufige Definitionen von Social Bots – der Automatisierungscharakter tritt in den Hintergrund.

Für Botometer ist ein Social Bot „im Großen und Ganzen ein Social-Media-Konto, das zumindest teilweise durch Software kontrolliert wird.“

Bot Sentinel sucht nach „nicht authentischen Accounts“, die von Menschen oder automatisiert – also als Bot – betrieben werden. Nicht authentische Accounts definiert Bot Sentinel als „Personen, die vorgeben, etwas zu sein, das sie nicht sind, um ihre Anhänger und ihr Publikum zu täuschen, oder automatisierte Konten (Bots), die entwickelt wurden, um sich so menschlich wie möglich zu verhalten, mit der Absicht, zu täuschen. Diese benutzen nicht authentische Konten, um Zwietracht zu säen und Chaos auf sozialen Medienplattformen zu verursachen, und sie werden oft dazu benutzt, sich an gezielter Belästigung und toxischem Trolling zu beteiligen.“

Alles eine Frage der Parameter

Botometer und Bot Sentinel analysieren Twitter-Accounts und legen nach gewissen Regeln fest, ob ein Account unter die jeweilige Social-Bot-Definition fällt. Nach Kreil und Gallwitz sind diese Regeln wenig aussagekräftig und produzieren fast ausschließlich Fehlalarme.

Botometer klassifizierte etwa anfangs jeden Twitter-Nutzer als Bot, der 50 Tweets pro Tag produziert. Mittlerweile setzt Botometer auf maschinelles Lernen: Ein Algorithmus soll anhand von Bot-Beispielen lernen, Bots zu erkennen.

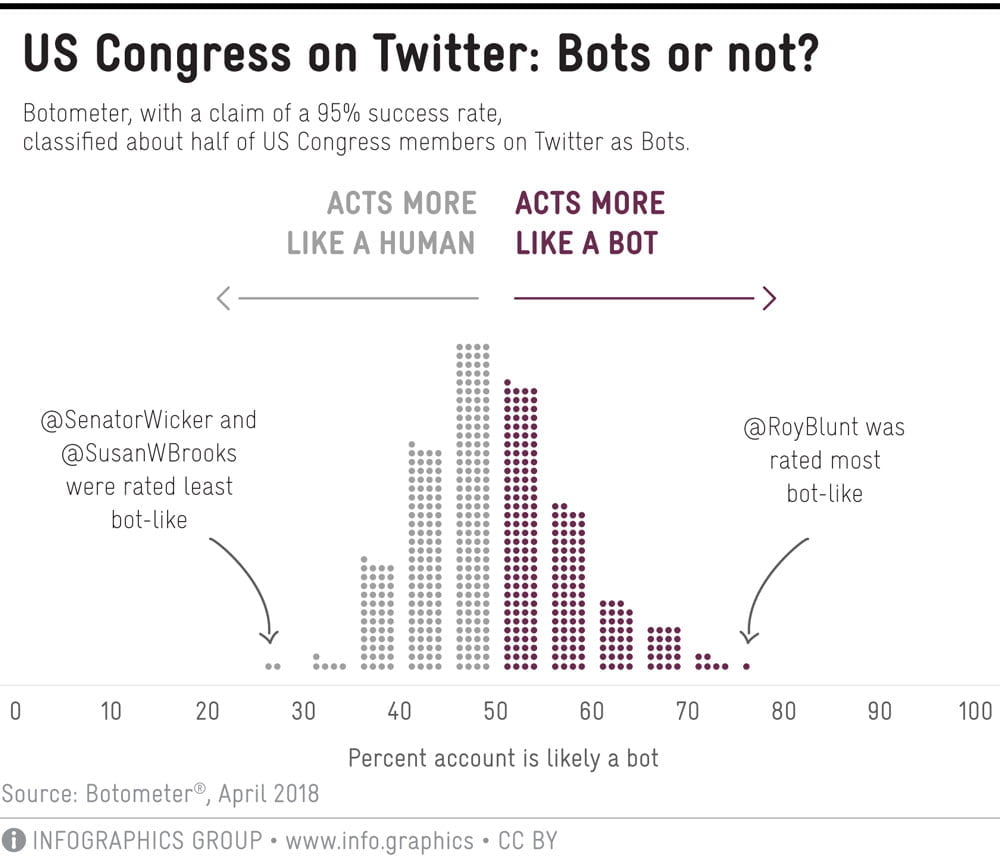

Besonders gut scheint das nicht zu funktionieren: Kreil zeigte 2018, dass Botometer etwa die Hälfte aller Abgeordneten des US-Kongresses als Bots klassifizierte.

2019 waren es nur noch 0,4 Prozent. Dafür hielt Botometer etwa 17 Prozent aller Reuter-Journalisten und 12 Prozent aller Nobelpreisträger für Bots.

Und knapp 60 Prozent klassischer Twitter-Bots, die etwa automatisiert News ihrer Träger posten, hielt der Algorithmus für Menschen.

Someone pointed me to @botwikidotorg (https://t.co/K36MyRT3oX).

I scraped and analyzed these 937 bots. @botometer claims that 569 of them (60.7%) are real people!

So both the false positive and false negative rate seems the be a disaster! pic.twitter.com/LRFLCVe4QY— Michael Kreil (@MichaelKreil) May 9, 2019

Auch Bot Sentinel setzt auf maschinelles Lernen und analysiert nach eigenen Angaben hunderte Tweets pro Account. Je häufiger die Accounts ein gewisses Verhalten aufweisen, desto höher ist ihr Bot-Sentinel-Rating.

Dieses Verhalten bezeichnet Bot Sentinel als „gefährliche Tweet-Aktivitäten“, die für andere schädlich seien. Als Beispiel führt das Unternehmen Belästigungen anderer Nutzer, das Verbreiten von Fehlinformationen oder den direkten Bruch mit Twitter-Regeln auf.

Kurz: Bot Sentinel trägt den Bot zwar im Namen, ist aber eher ein Troll-Jäger.

Bots, staatliche Propaganda, Trolle - oder einfach andere Meinungen?

Durch die unterschiedlichen Definitionen der Entität Social Bot unterscheiden sich Ergebnisse und Implikationen von Bot-Studien stark, wie das Science Media Center in einem Leitfaden zur kritischen Betrachtung von Studien über Social Bots festhält.

Doch die unklaren Definitionen werfen grundsätzlichere Fragen auf: Wenn es heißt, mehr als die Hälfte aller Tweets zu „Reopening America“ seien von Social Bots verfasst worden – sind das dann Chatbot-ähnliche Programme, staatlich finanzierte Trolle oder normale Nutzer, die ins Raster eines Boterkennungs-Algorithmus fallen?

Und was, wenn es überhaupt keine vollautomatisierten Social Bots gibt? Dann kann auch ein Erkennungsalgorithmus nicht trainiert werden. Die schwammigen Definitionen von Botometer und Bot Sentinel sind kontraproduktiv, da so kaum mehr zwischen einem echten Social Bot und einem menschlichen Akteur unterschieden wird.

Klar ist: Politische Akteure versuchen Einfluss auf die öffentliche Meinung durch gezielte Manipulation sozialer Netzwerke zu nehmen. Immer wieder sperrt Twitter entsprechende Konten.

Out of the 170k CCP accounts Twitter deleted, they published the data for 23.8k accounts. which I analyzed.

My take: they are not bots, but actual human beings reluctantly taking part in a troll factory.

In this thread, I'll cover the specifics that really stand out.

THREAD:

— Amal Sinha (@amaleshwar) June 15, 2020

Vollautomatisierte Social Bots waren bislang wohl nicht darunter, wie die Stellungnahme des KI-Forscher Gallwitz an die Enquete-Kommission KI des deutschen Bundestages nahelegt: „Im Ergebnis habe ich bis heute weltweit nicht ein einziges Beispiel für einen Twitter-Account gefunden, der auch nur im Ansatz den gängigen Vorstellungen und Definitionen eines ‘Social Bots‘ entspricht. Jeder einzelne Fund eines angeblichen ‘Social Bots‘ stellte sich spätestens bei genauerem Hinsehen als ein von einem Menschen geführter Account heraus.“

Ungenaue Definitionen, schlampige Wissenschaft, eine falsche Vorstellung von KI-Fähigkeiten und schnelle Schlagzeilen haben das Bild des vollautomatisierten, meinungssteuernden Social Bot gezeichnet.

Übrig bleibt die Gefahr, dass der bloße Glaube an Bots dazu führt, dass wir bestimmte Meinungsäußerungen als Maschinen-Propaganda abtun. Das ist Gift für den demokratischen Diskurs.