Das kriminelle Gesicht: Die gefährliche Illusion

Drei KI-Forscher zeigen, dass die Vorstellung einer KI, die kriminelle Neigung am Gesicht erkennen kann, eine Illusion ist.

Kann man im Gesicht einer Person erkennen, ob sie kriminell ist oder sein wird? Diese Debatte wird in der KI-Community nicht erst seit der Ankündigung der privaten Harrisburg-Universität intensiv geführt. Dort tätige Forscher behaupteten, sie hätten eine KI entwickelt, die Kriminelle anhand ihrer Gesichtszüge erkennen kann, bevor sie ein Verbrechen begangen haben.

Der Sofware liegt folgende Annahme zugrunde: Ob jemand kriminell ist, lässt sich an feinen Details im und am Gesicht erkennen – wenn nicht von Menschen, dann durch die oft bewiesene Fähigkeit KI-gestützter Bildanalyse.

Drei Forscher argumentieren jetzt dagegen: „Die Vorstellung, dass es einen solchen Algorithmus geben kann, ist eine Illusion. Und der Glaube an diese Illusion ist gefährlich.“

Grundsätzlich ist die Grundlage solcher illusorischen Projekte die Physiognomik, wie sie der italienische Kriminologe Cesare Lombroso beschrieb. Wer das weiß, weiß eigentlich schon genug. Denn: Physiognomik ist so sicher Bullshit, wie etwas in der Wissenschaft sicher sein kann. Da hilft auch keine Künstliche Intelligenz.

Doch woher kommen dann die positiven Ergebnisse? Warum gibt es KIs, die in Tests Kriminelle mit einer Genauigkeit von bis zu 97 Prozent erkennen?

Vielleicht ist ja doch etwas dran an der KI- Physiognomik. Die Maschine könnte womöglich Details erfassen, die der Mensch nicht wahrnimmt. Oder?

Jeder Unterschied zählt für die KI

Die Autoren Kevin Bowyer und Walter Scheirer von der Universität Notre Dame sowie Michael King vom Florida Institute of Technology argumentieren, dass diese Ergebnisse falsch sind. Ihre Begründung ist das mangelhafte Versuchsdesign.

Als Beispiel greifen die Autoren die Arbeit der amerikanischen KI-Forscher Mahdi Hashemi und Margeret Hall auf. Dort berichten die beiden Forscher von ihren Erfolgen mit einer KI, die Kriminelle mit 97 prozentiger Genauigkeit an ihrem Gesicht erkennt.

Hashemi und Hall sind sich der Problematik ungenauer Datensätze bewusst: Wer etwa 100 Fotos von Kriminellen mit weißen Hüten und 100 Fotos von Nicht-Kriminellen mit schwarzen Hüten zum Training der KI nimmt, wird zwangsläufig eine KI bekommen, die alle Menschen mit weißen Hüten für kriminell hält.

Die Forscher schufen daher für ihr Training scheinbar optimale Voraussetzungen: Alle Fotos sind 128 mal 128 Bildpunkte groß, in Graustufen und zeigen die Personen von vorne mit einem neutralen Gesichtsausdruck.

Bowyer, Scheirer und King weisen jedoch darauf hin, dass die Fotos von Kriminellen und Nicht-Kriminellen aus unterschiedlichen Quellen stammen und daher Unterschiede aufweisen, die für das menschliche Auge nicht erkennbar, aber für eine KI entscheidend sein können:

- Alle Bilder der Kriminellen sind digitale Fotografien ausgedruckter Bilder, die mit dem gleichen Kameramodell aufgenommen wurden. Alle Bilder von Nicht-Kriminellen sind direkte digitale Fotografien von Menschen und wurden mit unterschiedlichen Kameras aufgenommen.

- Alle Bilder der Kriminellen lagen im (lossless) PNG-Format vor, alle Bilder der Nicht-Kriminellen im (lossy) JPG-Format.

- Alle Bilder der Kriminellen waren Schwarz-Weiß-Fotografien, die Bilder der Nicht-Kriminellen wurden konvertiert.

Jede dieser drei Unterschiede könnte die direkte Ursache der hohen Genauigkeit der Gesichtsanalyse-KI und damit des illusorischen Ergebnisses sein, das zu falschen Schlussfolgerungen verleitet. Hashemi und Halls Versuchsdesign ist daher mangelhaft. Ähnliche Probleme plagen auch die Arbeit der chinesischen KI-Forscher Xiaolin Wu und Xi Zhang.

Ein Gedankenexperiment deckt die Illusion auf

Sind bessere Datensätze die Lösung? Nein, sagen die drei Wissenschaftler: Allein die Annahme, eine KI könne anhand des Gesichts zukünftige Verhaltensweisen erkennen, könne durch einfache Gedankenexperimente widerlegt werden.

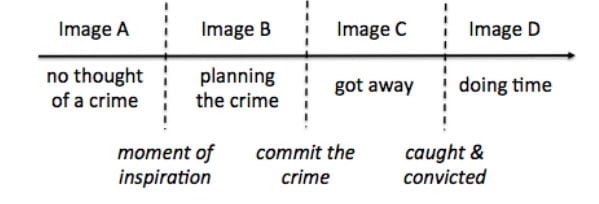

Nehmen wir eine Person an, die sich eines Tages das perfekte Verbrechen ausdenkt. Bild A ist vor dem Gedanken, Bild B nach dem Plan. Sie führt ihn durch, kommt eine Weile davon, wird dann aber verhaftet. Bild C ist nach dem Verbrechen, Bild D ist nach der Verhaftung.

Wie soll die KI mit diesen Bildern trainiert werden? Es gibt vier mögliche Varianten, die Bilder zu markieren:

Variante 1:

Bild A Nicht-Kriminell | Bild B,C,D Kriminell

Das würde bedeuten, dass in dem Moment, in dem eine Person ein Verbrechen plant, sich etwas in ihrem Gesicht verändert.

Variante 2:

Bild A, B Nicht-Kriminell | Bild C,D Kriminell

Das Gesicht der Person müsste sich durch das Verbrechen verändern.

Variante 3:

Bild A,B,C Nicht-Kriminell | Bild D Kriminell

Die Planung und das Verbrechen haben keine Auswirkung auf das Gesicht. Erst nach der Verhaftung müsste sich das Gesicht verändern.

Alle drei Varianten erscheinen unwahrscheinlich und es gibt keinerlei wissenschaftliche Begründung für diese Annahmen. Übrig bleibt nur, alle vier Bilder als kriminell zu markieren.

Variante 4:

Bild A,B,C,D Kriminell

Diese Variante geht von einem geborenen Kriminellen aus – also der Annahme, dass jeder Mensch, der ein Verbrechen begeht, kriminell geboren wurde. Zusätzlich müsste diese angeborene Kriminalität in seinem Gesicht erkennbar sein.

Diese Überzeugung entspricht der Pseudo-Wissenschaft Physiognomie. Doch es gebe keinerlei Hinweise auf eine direkte genetische Verbindung zu kriminellem Verhalten, schreiben die Autoren. Wer so etwas postuliere, ignoriere völlig die essenzielle Rolle des Lernens für die menschliche Entwicklung und das Zusammenspiel zwischen Umwelt und der Entwicklung des Nervensystems.

Ist Kriminalität ein soziales Konstrukt?

Es existiert ein weiteres Problem: Kriminalität ist ein Produkt unserer Kultur.

Ein Autofahrer fährt durch die drei Bundesstaaten Illinois, Indiana und Michigan. In jedem Bundesstaat wird ein Foto seines Gesichts geschossen. In Illinois konsumiert der Fahrer medizinisch verordnetes THC und bleibt unter dem gesetzlich festgelegten Grenzwert.

Er geht weiter fälschlicherweise davon aus, dass die gleichen Regeln für Indiana gelten und fährt über die Grenze. In Michigan ist sein Konsum wieder legal, da es sich in seinem Fall um medizinischen Gebrauch handelt.

Der Fahrer hat also in Indiana ein Verbrechen begangen, ohne es zu wissen. In den anderen Bundesstaaten war sein Konsum legal. Welches Foto verwenden wir für das KI-Training?

Ähnliche Beispiele könnten für schwerere Verbrechen wie das Töten einer Person oder Vergewaltigung in der Ehe konstruiert werden. Das zeige, dass eine Verurteilung als Verbrecher „von der Zeit und dem Ort abhängen, an dem die Handlung begangen wird“, so die Forscher.

Die Forscher warnen abschließend, dass solche KI-Experimente schlimmere Folgen haben könnten als unsaubere Wissenschaft: Es lauere die Gefahr, dass Staaten und Industrien einer Kontrollillusion erliegen und Ressourcen in die Forschung und Entwicklung entsprechender Anwendungen stecken.

Allein die Überzeugung, dass die Technik funktioniert, könne Produkte hervorbringen, die Menschen willkürlich in Kriminelle und Nicht-Kriminelle sortiert, schreiben die Forscher.

Quelle: Arxiv

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.