Chatbot Arena: OpenAI o1-preview und o1-mini ziehen an Konkurrenz vorbei

OpenAIs neue KI-Modelle o1-preview und o1-mini erzielen in der Chatbot-Arena Bestwerte, doch die geringe Anzahl der Bewertungen könnte das Ergebnis verzerren.

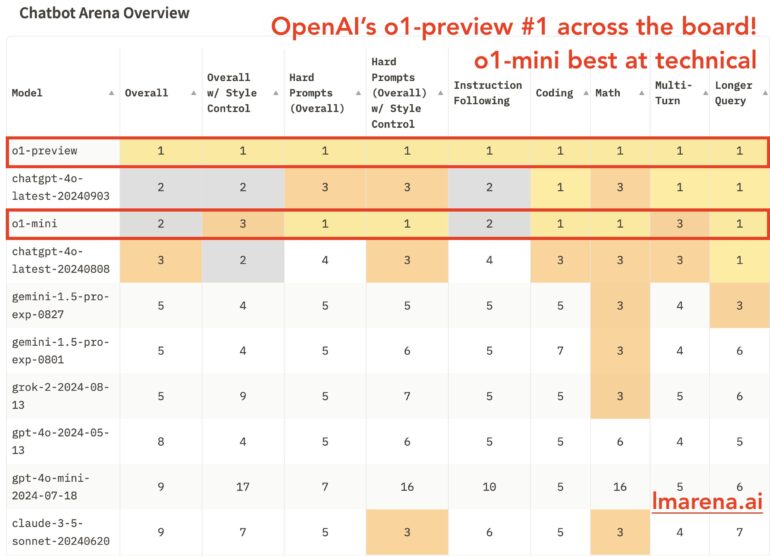

OpenAIs neue KI-Modelle o1-preview und o1-mini haben in der Chatbot-Arena beeindruckende Ergebnisse erzielt. Laut einer veröffentlichten Übersicht belegt o1-preview den ersten Platz in allen bewerteten Kategorien, darunter Gesamtleistung, Sicherheit und technische Fähigkeiten. Das auf MINT-Aufgaben spezialisierte o1-mini teilte sich kurzfristig den zweiten Gesamtrang mit einer Anfang September online gegangenen Version von GPT-4o und führt in den technischen Bereichen.

Die Chatbot-Arena, eine Plattform zum Vergleich verschiedener KI-Modelle, hat die Leistung der neuen OpenAI-Systeme mit über 6.000 Community-Bewertungen evaluiert. Dabei zeigte sich die Überlegenheit von o1-preview und o1-mini, insbesondere bei mathematischen Aufgaben, harten Prompts und Programmierung.

Allerdings ist zu beachten, dass o1-preview und o1-mini mit jeweils knapp 3.000 Bewertungen bisher deutlich weniger Votes erhalten haben als etablierte Modelle wie GPT-4o oder Claude 3.5 von Anthropic. Diese geringe Stichprobengröße könnte zu Verzerrungen in der Bewertung führen und die Aussagekraft der Ergebnisse einschränken.

OpenAIs o1 zeigt starke Leistung in Mathematik und Coding

o1 soll durch längeres "Nachdenken" vor der Antwort einen neuen Standard für KI-Logik setzen. Noam Brown, Mitentwickler des Modells, erklärt: "Wir sind nicht mehr durch das Pre-Training eingeschränkt. Wir können jetzt auch die Rechenleistung für Inferenzen skalieren."

Die o1-Modelle sind jedoch nicht in allen Bereichen besser als der Vorgänger GPT-4o. Viele Aufgaben erfordern kein komplexes logisches Denken, und in manchen Fällen ist eine schnelle Antwort von GPT-4o ausreichend.

Ein Diagramm von Lmsys zur Modellstärke im Bereich Mathematik zeigt wie erwartet deutlich, dass o1-preview und o1-mini mit einem Wert von über 1360 deutlich über den Leistungen anderer Modelle liegen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.