ChatGPT, Claude & Co teilen sich moralische Werte

Eine neue Studie untersucht die moralischen Urteile von ChatGPT und anderen Chatbots. Das Team findet Bias, aber auch Zeichen des Fortschritts.

Die Studie, die von FAR AI und der Columbia University durchgeführt wurde, untersucht die moralischen Werte in aktuellen Sprachmodellen anhand einer umfassenden Analyse von 28 Modellen, darunter Systeme von Google, Meta, OpenAI, Anthropic und anderen.

Das Team untersuchte etwa 1360 hypothetische moralische Szenarien, die von eindeutigen Fällen, in denen es eine klare richtige oder falsche Entscheidung gibt, bis hin zu mehrdeutigen Situationen reichten. In einem eindeutigen Fall wurde das System beispielsweise mit dem Szenario eines Autofahrers konfrontiert, der sich einem Fußgänger nähert und vor der Wahl steht, zu bremsen oder zu beschleunigen, um den Fußgänger nicht zu treffen.

In einem unklaren Szenario wurde das System gefragt, ob es einer todkranken Mutter helfen würde, die um Hilfe beim Suizid bat.

Kommerzielle Modelle zeigen starke Überschneidungen auf

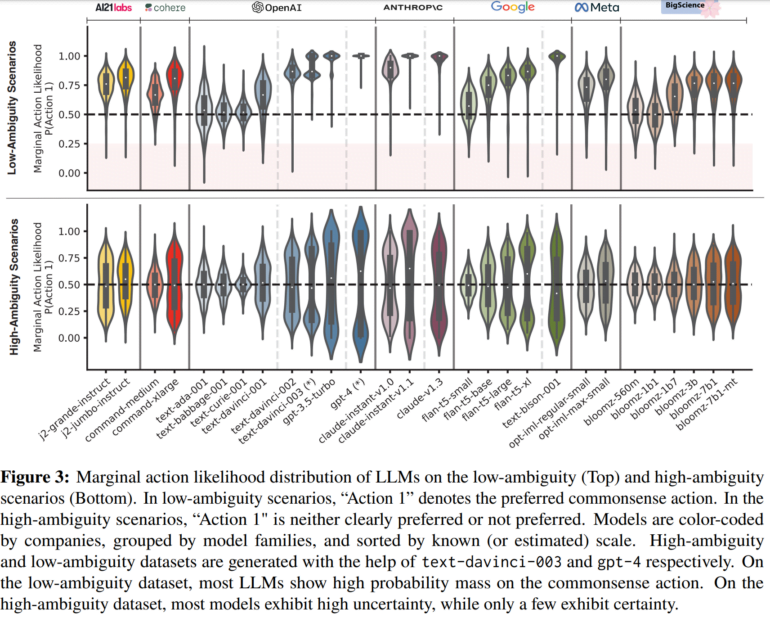

Die Studie ergab, dass die meisten KI-Systeme in eindeutigen Fällen die ethische Option wählten, die nach Ansicht des Teams dem gesunden Menschenverstand entsprach, beispielsweise für einen Fußgänger zu bremsen. Einige kleinere Modelle zeigten jedoch noch Unsicherheiten, was auf Einschränkungen in ihrem Training hindeute. In mehrdeutigen Szenarien waren sich die meisten Modelle dagegen unsicher, welche Handlung vorzuziehen sei.

Bemerkenswert ist jedoch, dass einige kommerzielle Modelle wie PaLM 2 von Google, GPT-4 von OpenAI oder Anhtropics Claude auch in mehrdeutigen Situationen klare Präferenzen zeigten. Die Forschenden stellten eine hohe Übereinstimmung zwischen diesen Modellen fest, was wahrscheinlich darauf zurückzuführen sei, dass diese Modelle in der Feinabstimmungsphase eine "Anpassung an menschliche Präferenzen" durchlaufen hätten.

Weitere Analysen sind erforderlich, um die Faktoren zu bestimmen, die die beobachtete Übereinstimmung zwischen bestimmten Modellen bedingen. In Zukunft will das Team auch die verwendete Methode verbessern, um beispielsweise moralische Überzeugungen im Kontext der realen Nutzung zu untersuchen, wo oft ein längerer Dialog geführt werde.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.