Laut einer aktuellen Studie übertrifft ChatGPT die Qualität und das Einfühlungsvermögen von Ärzten bei der Beantwortung von Online-Anfragen. Allerdings gibt es auch Bedenken.

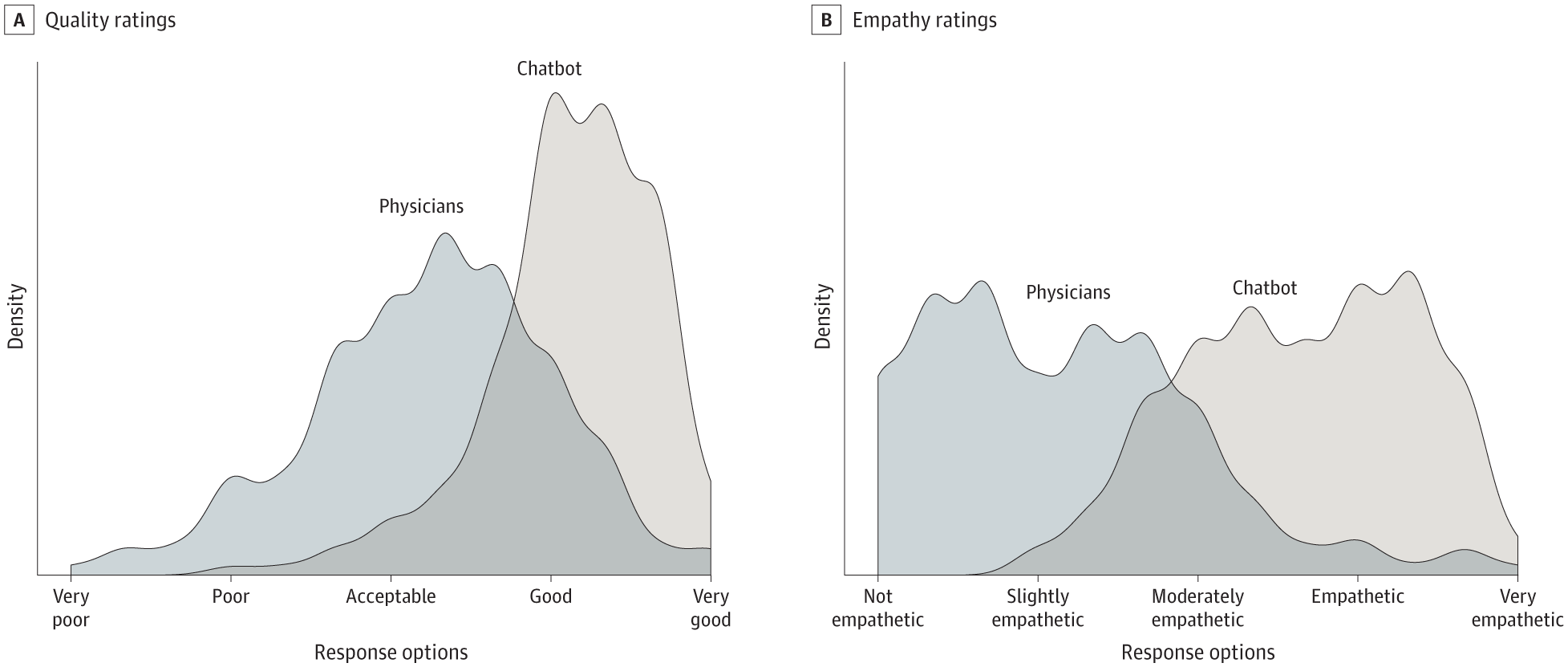

Eine kürzlich in JAMA Internal Medicine veröffentlichte Studie zeigt, dass ChatGPT Ärzte in Bezug auf Qualität und Einfühlungsvermögen bei der Beantwortung von Online-Anfragen übertrifft. In der Studie wurde die Leistung von ChatGPT im Vergleich zu Ärzten bei der Beantwortung von Patientenfragen aus dem Reddit-Forum r/AskDocs bewertet.

Die Querschnittsstudie umfasste 195 zufällig ausgewählte Fragen und ergab, dass Chatbot-Antworten gegenüber Antworten von Ärzten bevorzugt wurden. ChatGPT erhielt signifikant höhere Bewertungen für Qualität und Einfühlungsvermögen.

Zu beachten ist, dass die Studie mit der älteren Version GPT-3.5 durchgeführt wurde. Die neueste Version GPT-4 könnte noch bessere Ergebnisse liefern.

Ärztinnen und Ärzte mit Chatbot-Unterstützung

KI-Assistenten könnten bei der Formulierung von Antworten auf Patientenfragen helfen, schreiben die Forscher. Dies könnte sowohl für Ärztinnen und Ärzte als auch für Patientinnen und Patienten von Vorteil sein.

Weitere Forschung zu dieser Technologie im klinischen Umfeld sei notwendig. Dazu gehöre auch der Einsatz von Chatbots, um Antworten zu generieren, die dann von Ärztinnen und Ärzten bearbeitet werden können.

Dies könne die Antworten verbessern, das Burnout-Risiko von Ärztinnen verringern und die Ergebnisse für Patientinnen und Patienten verbessern. Das Potenzial von KI-Assistenten müsse in randomisierten Studien weiter untersucht werden.

Schnelle und einfühlsame Antworten auf Patientenanfragen könnten unnötige Klinikbesuche reduzieren und Ressourcen freisetzen. Messaging sei eine wichtige Ressource zur Förderung der Patientengerechtigkeit, von der Menschen mit eingeschränkter Mobilität, unregelmäßigen Arbeitszeiten oder Sorge vor Arztrechnungen profitierten.

Keine Prüfung auf medizinische Fehler

Trotz der vielversprechenden Ergebnisse weist die Studie einige Einschränkungen auf. Die Verwendung von Fragen aus Online-Foren spiegelt möglicherweise nicht die typischen Interaktionen zwischen Patient und Arzt wider, und die Fähigkeit des Chatbots, personalisierte Details aus elektronischen Gesundheitsakten bereitzustellen, wurde nicht bewertet.

Überdies wurden die Antworten des Chatbots in der Studie nicht auf Genauigkeit oder falsche Informationen überprüft, was ein großes Problem bei KI-generierter medizinischer Beratung darstellt. Es kann schwieriger sein, einen Fehler zu entdecken, als ihn zu vermeiden. Der Mensch in der Endkontrolle ist also nicht automatisch die Lösung. Und auch Menschen machen Fehler.

Die Autoren kommen zu dem Schluss, dass weitere Forschung erforderlich ist, um die potenziellen Auswirkungen von KI-Assistenten im klinischen Bereich zu ermitteln. Sie betonen, dass ethische Bedenken berücksichtigt werden müssen, einschließlich der Notwendigkeit einer menschlichen Überprüfung von KI-generierten Inhalten auf Genauigkeit und mögliche Falsch- oder Fehlinformationen.

Interessant im Kontext der Studie ist, dass ChatGPT nicht speziell für medizinische Aufgaben optimiert ist. Google entwickelt Med-PaLM 2, ein großes Sprachmodell, das für medizinische Zwecke optimiert ist und laut Google medizinische Prüfungen bestehen kann. Der Tech-Konzern plant derzeit eine erste Testphase mit ausgewählten Fachleuten, um Anwendungsszenarien zu finden und zu evaluieren.