ChatGPTs Advanced Voice Mode unterstützt jetzt Live Video und Screensharing

OpenAI erweitert die Fähigkeiten seines Advanced Voice Mode um Live-Video und Screensharing. Die neuen Funktionen werden ab sofort schrittweise ausgerollt.

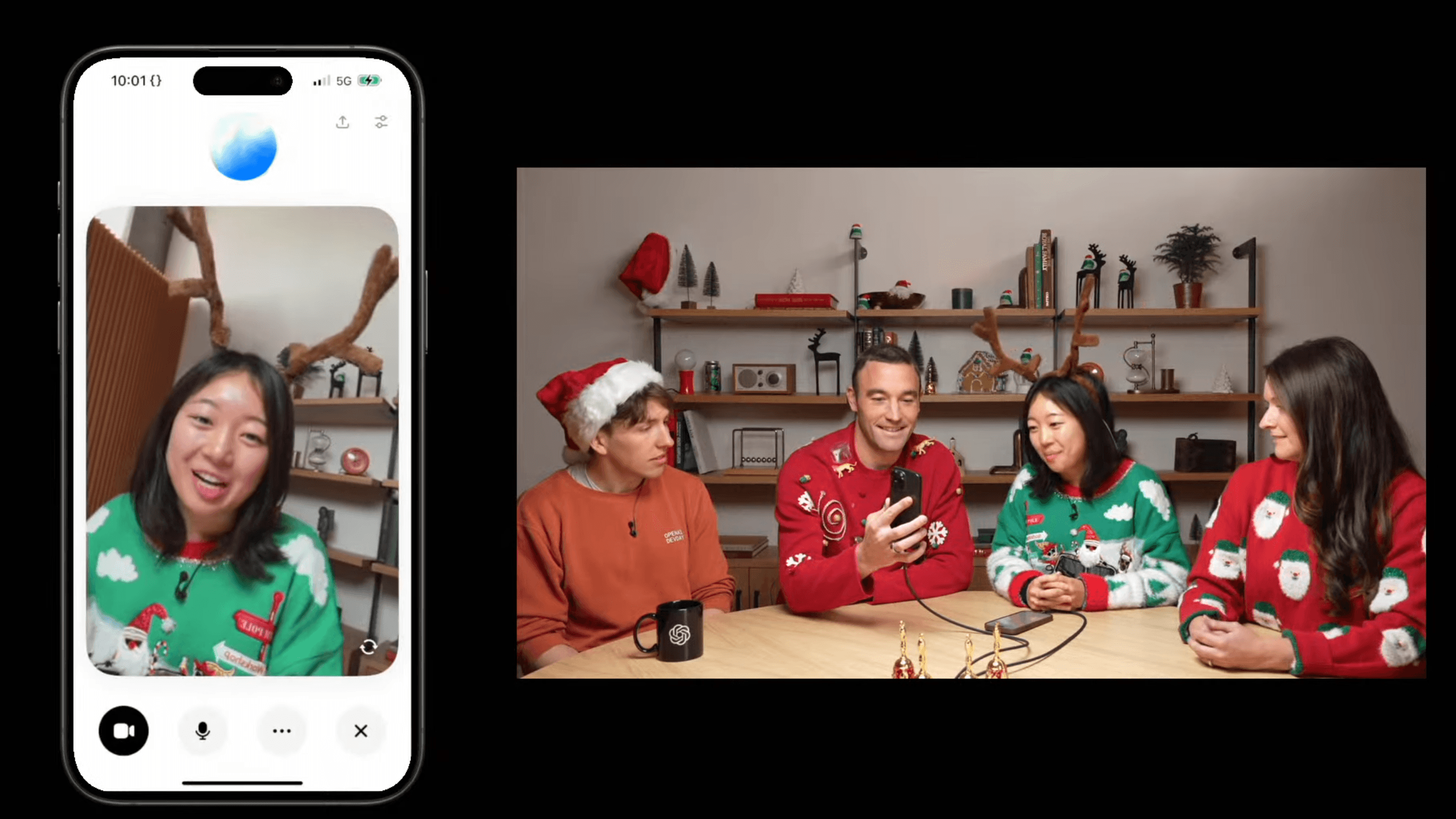

OpenAI hat angekündigt, dass ChatGPT im Advanced Voice Mode nun auch Live-Video und Screensharing unterstützt. Laut Ankündigung des Unternehmens können Nutzer damit visuelle Kontexte in Echtzeit mit ChatGPT teilen, um Gespräche noch natürlicher und nützlicher zu gestalten. Das Feature wurde ursprünglich bei der Vorstellung von GPT-4o gezeigt. Der Modus soll mehr als 50 Sprachen unterstützen.

Der Rollout der neuen Funktionen erfolgt laut OpenAI schrittweise: Ab sofort erhalten Teams-Nutzer sowie die meisten Plus- und Pro-Abonnenten Zugang. Wie bereits beim Advanced Voice Mode selbst und beim kürzlich vorgestellten Videomodell Sora, wird die Funktion für Plus- und Pro-Abonnenten in Europa zu einem späteren Zeitpunkt verfügbar sein. Enterprise- und Bildungseinrichtungen sollen Anfang nächsten Jahres folgen.

Santa-Chat und Google-Konkurrenz

Als saisonales Feature führt OpenAI außerdem einen Santa-Chat ein, der für den Rest des Dezembers verfügbar ist. Nutzer können über ein Schneeflocken-Symbol auf dem Startbildschirm oder in den ChatGPT-Einstellungen direkt mit dem KI-Weihnachtsmann sprechen. OpenAI setzt dabei die gleiche Sprachtechnologie ein und hebt für das erste Gespräch mit Santa die üblichen Nutzungslimits des Advanced Voice Mode einmalig auf.

Die Ankündigung folgt einen Tag nach der Vorstellung von Google Gemini 2.0. Das neue Gemini 2.0 Flash ist ebenfalls multimodal und kann neben Text auch Audio und Bilder erzeugen. Letztere Funktion unterstützt eigentlich auch GPT-4o - aber dieses Feature scheint OpenAI noch zurückzuhalten. Gemini 2.0 Flash kann auch Videos in Echtzeit analysieren - ein Feature, das Google derzeit mit dem Project Astra auf Smartphones und den kürzlich angekündigten Android-XR-Brillen mit ausgewählten Personen testet.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.