ChatGPTs Bild-KI könnte Dokumentenfälschung zum Massenphänomen machen

Die neue KI von OpenAI kann in Sekundenschnelle täuschend echte Fotos von Dokumenten erstellen. Dies könnte bestehende Sicherheitssysteme überfordern, da plötzlich jeder Zugang zu professionellen Fälschungswerkzeugen hat.

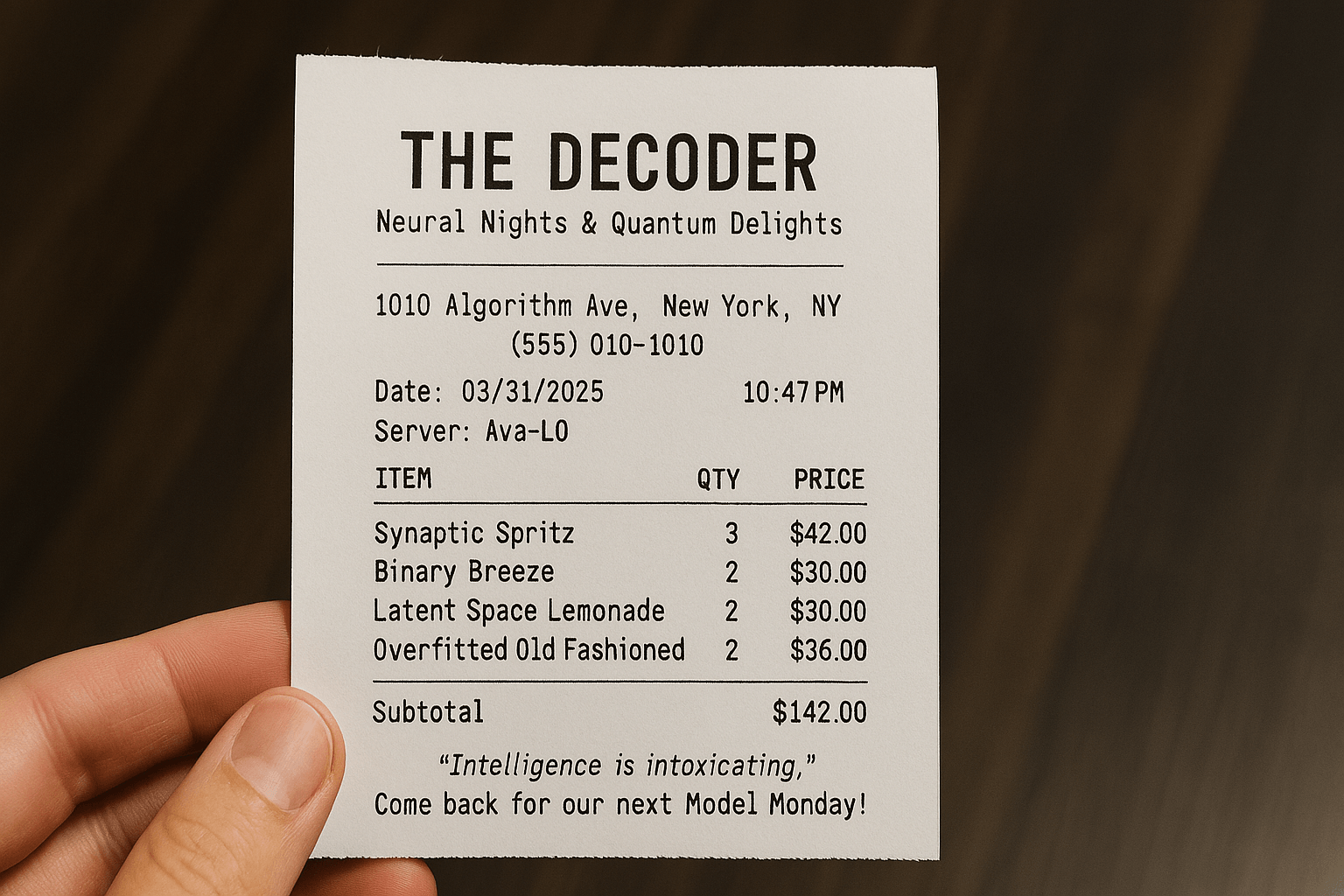

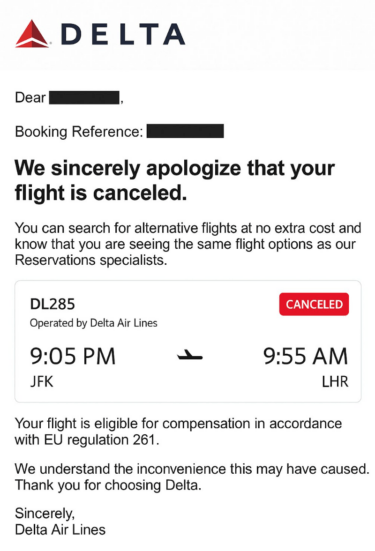

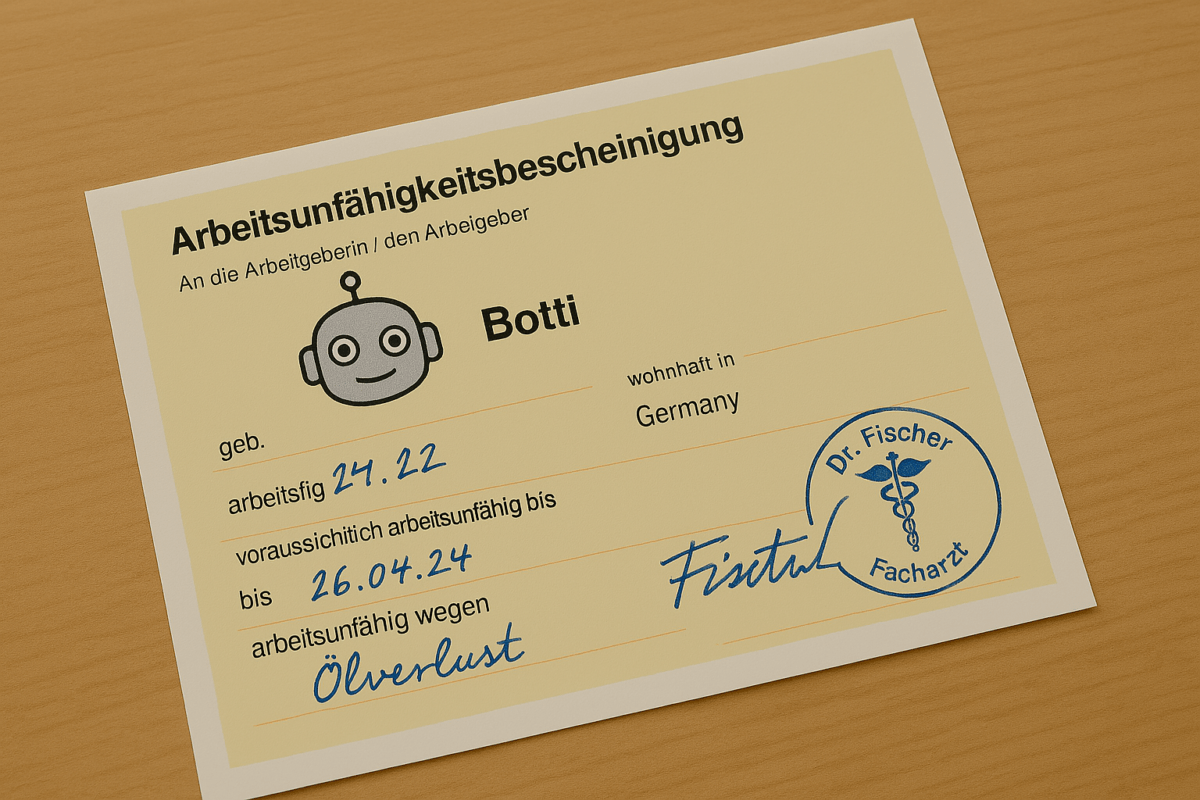

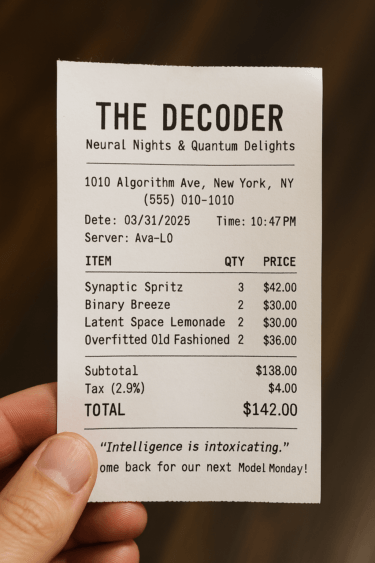

Mit OpenAIs neuem Bildmodell GPT-4o lassen sich täuschend echte Fotos von Dokumenten in Sekundenschnelle erstellen. Der X-Nutzer "God of Prompt" zeigt etwa gefälschte Flugstornierungen, Banküberweisungen, Universitätsabschlüsse oder ärztliche Rezepte, die als Foto problemlos gefälscht werden können.

Während die Fälschung solcher Dokumente mit Bildbearbeitungsprogrammen schon immer möglich war, verändert die KI-gestützte Automatisierung die Situation grundlegend: Statt weniger Experten, die Stunden für eine Fälschung benötigen, kann nun praktisch jeder in Sekunden überzeugende Fake-Dokumente erstellen.

Menge an Fälschungen könnte neue Kontrollmechanismen erfordern

Die schiere Menge möglicher Fälschungen könnte etablierte Sicherheitssysteme an ihre Grenzen bringen, wenn etwa bei geringen Entschädigungsansprüchen auf eine gründliche Überprüfung von Screenshot-Nachweisen verzichtet wird, Vermieter Zahlungshistorien nur oberflächlich prüfen, oder Arbeitgeber in frühen Bewerbungsrunden Zeugnisse nicht auf Fälschung prüfen.

Wenn plötzlich Tausende gefälschte Nachweise im Umlauf sind, könnten die bestehenden Kontrollmechanismen in Unternehmen und Behörden versagen. Je mehr Fälschungen eingereicht werden, desto wahrscheinlicher ist es, dass einige durch die Prüfung rutschen - selbst bei gleichbleibender Erkennungsrate.

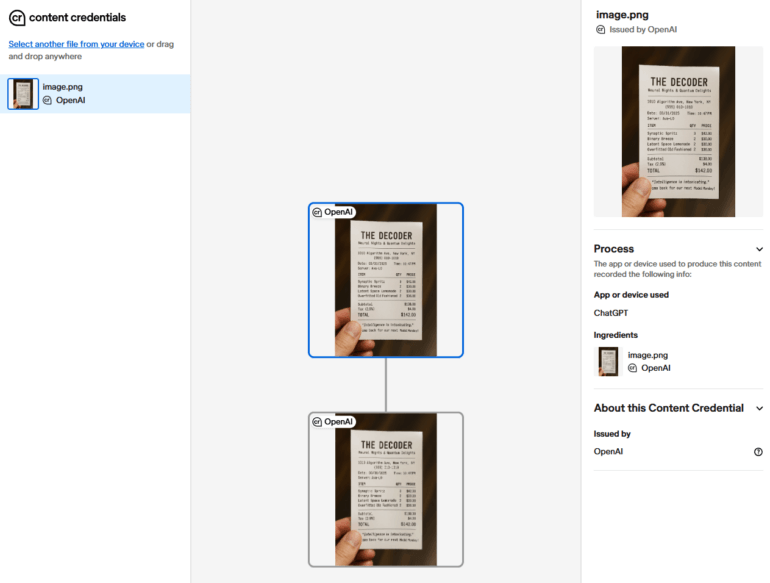

OpenAI versucht, dem Missbrauch mit verschiedenen Sicherheitsmaßnahmen zu begegnen. Alle von GPT-4o generierten Bilder werden mit C2PA-Metadaten versehen, die sie als KI-generiert kennzeichnen. Diese Metadaten erfordern aber, dass der Screenshot-Prüfer auch ein Tool nutzt, das deren Vorhandensein prüft. Außerdem könnten gewiefte Nutzer die Metadaten entfernen. OpenAI hat zusätzlich ein internes Suchwerkzeug entwickelt, um die Herkunft von Bildern zu verifizieren.

OpenAI betont in seinem GPT-4o-Paper, dass man kreative Freiheit für wertvolle Anwendungen wie Spieleentwicklung, historische Forschung und Bildung maximieren wolle - bei gleichzeitiger Aufrechterhaltung strenger Sicherheitsstandards. Das Unternehmen räumt ein, dass Sicherheit ein fortlaufender Prozess sei und die Richtlinien basierend auf der realen Nutzung angepasst würden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.