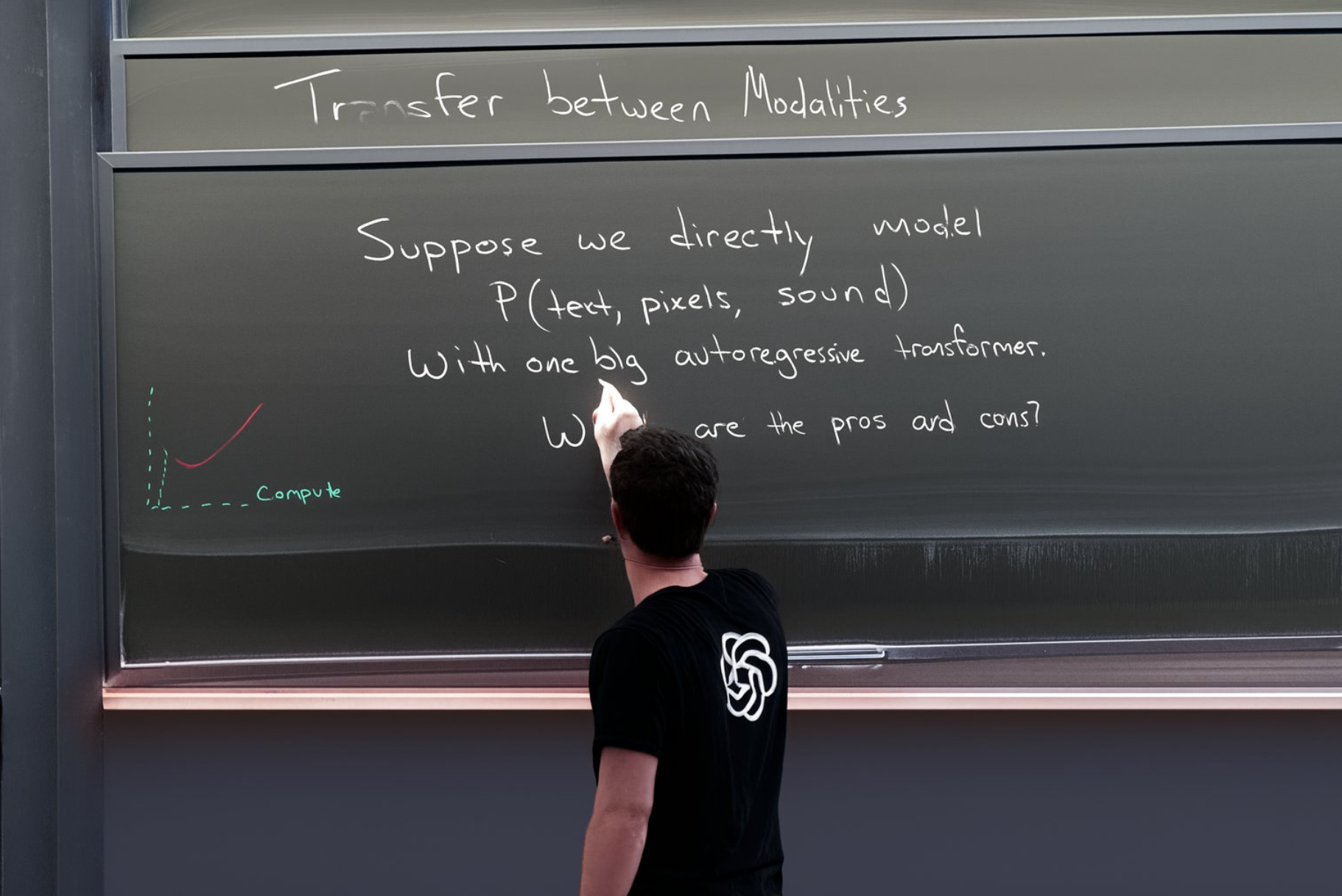

Greg Brockman, Mitbegründer von OpenAI, teilte auf X ein von GPT-4o erzeugtes Bild, das das Potenzial der Bildgenerierungsfunktionen des Modells veranschaulicht.

Das Bild sieht fotorealistisch aus, und die handschriftliche Beschriftung der Tafel ist grammatikalisch korrekt und sinnvoll. Brockman zeigt den Prompt nicht, aber die Tafelbeschriftung dürfte im Prompt gestanden haben.

Insbesondere Ideogram zeigt, dass eine korrekte Textdarstellung mit Bildmodellen möglich ist, wenn auch bisher nicht in der Komplexität, wie sie Brockman im Bild zeigt. DALL-E 3 oder Midjourney beherrschen die Textdarstellung mehr schlecht als recht.

Dass GPT-4o diese Bild-Fähigkeit auf hohem Niveau beherrscht, liegt daran, dass es von Grund auf multimodal trainiert wurde - im Gegensatz zu GPT-4 mit DALL-E 3, das ein mit einem Bildmodell vernetztes Sprachmodell ist.

GPT-4o bietet noch eine Reihe weiterer multimodaler Fähigkeiten. Das Modell kann Text, Audio, Bild und Video als Eingabe akzeptieren und Text, Audio und Bild als Ausgabe erzeugen, und zwar in jeder beliebigen Kombination. Auf diese Weise können visuelle Geschichten, detaillierte und konsistente Charakterdesigns, kreative Typografie und sogar 3D-Renderings erzeugt werden.

GPT-4o ist derzeit kostenlos in ChatGPT als Text- und Codemodell verfügbar. Die multimodalen Fähigkeiten wie Audio und Bild werden in den kommenden Monaten schrittweise eingeführt. Die einzelnen Funktionen durchlaufen noch Red-Teaming und weitere Sicherheitstests. Ob OpenAI die Zusatzfunktionen wie bei DALL-E unter eigener Marke oder einfach als Funktion von GPT-4o veröffentlichen wird, ist bisher nicht bekannt.

Influencer-Verwirrung um die Sprachausgabe von GPT-4o

Eine kleine Anekdote: OpenAI kommunizierte GPT-4o bei der Vorstellung so ungeschickt, dass viele glaubten, die neue Audiofunktionalität sei in ChatGPT bereits verfügbar und nicht nur das Textmodell. OpenAI CEO Sam Altman musste diesen weit verbreiteten Irrtum nachträglich bei X aufklären.

Gut für OpenAI: Zahlreiche Nutzer entdeckten erstmals die seit Monaten verfügbare ChatGPT-Audiofunktion und veröffentlichten begeisterte Demonstrationen des "nächsten großen KI-Dings" in sozialen Medien. Hier überholte der KI-Fortschritt seine Influencer.