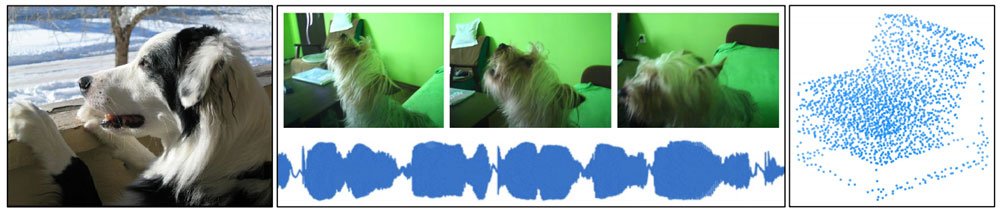

Deepmind stellt Perceiver vor: Ein Transformer-Modell, das Bilder, Audio, Video und Cloud-Point-Daten verarbeiten kann.

Künstliche Intelligenz verarbeitet Daten aus verschiedenen Modalitäten, darunter Bilder, Audio, Text oder Video. Aktuelle KI-Systeme sind auf bestimmte Daten spezialisiert: Häufig werden etwa CNNs für Bilddaten genutzt und aufmerksamkeitsbasierte Systeme mit der Transformer-Architektur verarbeiten Textdaten, etwa Googles BERT, Microsofts RoBERTa oder OpenAIs GPT-3.

Im Laufe des letzten Jahres zeichnete sich eine erste Änderung ab: Die in der Textverarbeitung erfolgreichen Transformer-Modelle fanden ihren Weg in die Bildverarbeitung.

Zu den bedeutenden Modellen gehörten Facebooks Detection Transformers (DETR) und Googles Vision Transformer (ViT). Anfang 2021 veröffentlichte OpenAI DALL-E und CLIP, zwei Transformer-basierte KI-Modelle, die mit Text- und Bilddaten gleichzeitig trainiert wurden.

Jetzt stellen Forscher von Deepmind die generalisierte Transformer-Architektur „Perceiver“ vor, die neben Bildern auch Audio, Video und Point-Cloud-Daten, etwa von LIDAR-Sensoren, verarbeiten kann. Laut Deepmind soll Perceiver der Funktion biologischer neuronaler Netze näherkommen als andere Architekturen.

Perceiver ist genereller, aber erreicht dennoch Leistung der Spezialisten

Deepminds Wahrnehmungsgeneralist Perceiver erreicht im ImageNet-Test das Niveau der weitverbreiteten ResNet-50-Architektur, schlägt im AudioSet-Test alle vergleichbaren Modelle und ist mit einer Genauigkeit von 85,7 der Cloud-Point-KI PointNet++ (91,9) auf der Spur.

Doch abseits der ordentlichen Testergebnisse ist Deepminds wichtigster Beitrag die Multimodalität von Perceiver. RestNet-50, PointNet++ oder Googles ViT sind für bestimmte Aufgaben entworfen und tragen in ihrer Architektur bestimmte Grundannahmen über die Art der Daten, die verarbeitet werden sollen. Das macht sie effektiv, aber auch zu einseitigen Spezialisten.

Grundlage für die Vielfältigkeit von Perceiver ist eine Änderung an der Transformer-Architektur. In den meisten Transformer-Architekturen, die etwa in OpenAIs GPT-3 verwendet werden, wird während des Trainings jedes Token innerhalb der Daten (etwa ein Wort in einem Paragrafen) mit jedem anderen Token durch sogenannte Anfragen verrechnet.

Dadurch entsteht ein quadratischer Prozess: Bei einem 500 Wörter langen Paragrafen werden 250.000 Rechenoperationen durchgeführt.

Bildverarbeitung mit Transformern

Dieser aufwendige Rechenprozess schränkt die Größe der gleichzeitig zu verarbeitenden Daten stark ein. Besonders deutlich wird das in der Bildanalyse: Ein niedrig aufgelöstes Bild mit 250 x 250 Pixeln führt zu 62.500² (3.906.250.000) Rechenoperationen. Das sprengt aktuelle Speichergrenzen und wohl auch den Geldbeutel selbst großer KI-Unternehmen.

Googles ViT umgeht dieses Problem, indem jedes zu verarbeitende Bild in einige wenige Bildabschnitte geteilt wird. Statt tausender Pixel muss der Transformer so lediglich neun oder nur wenige mehr Abschnitte verarbeiten. Das macht ViT jedoch zum Spezialisten: Die für Bilder angewandte Aufteilungslogik kann nicht auf Audio- oder Cloud-Point-Daten übertragen werden.

Perceiver setzt auf Cross-Attention

Perceiver verarbeitet dagegen 224 x 224 Pixel große Bilder – also knapp 50.000 Pixel – direkt. Möglich wird das durch die sogenannte „Cross-Attention“. Dabei werden die Bildinformationen nicht direkt in den Transformer übergeben, sondern gelangen über die Cross-Attention in das Netz.

Dieser Mechanismus dient als Flaschenhals: Perceiver stellt eine fixe Anzahl Anfragen an eine Matrix, die alle Informationen der Eingangsdaten enthält. Diese Informationen werden anschließend verarbeitet und informieren erneute Anfragen an die Matrix.

Dieser Prozess wiederholt sich mit jeder Schicht von Perceiver. Mit jeder Anfrage bekommt Perceiver so mehr Einblicke in die Struktur der Eingangsdaten. Die Cross-Attention ist ein Flaschenhals, da die Anzahl der Anfragen auf knapp 1.000 begrenzt ist.

In der Praxis muss Perceiver daher für 50.000 Pixel 50.000 x 1.000 Rechenoperationen durchführen. Ohne die Cross-Attention wären es 50.000². Statt Pixel können in der Matrix auch andere Daten repräsentiert werden, etwa Audio- oder Point-Cloud-Daten.

Deepmind will mit mehr Daten trainieren

In ihren Tests haben die Deepmind-Forscher die Architektur mit etwas über 100.000 Tokens getestet. Perceiver eröffne neue Wege für „generalisierende Wahrnehmungs-KIs, die nur wenige Annahmen über ihre Inputs machen und so mit beliebigen Sensorkonfigurationen umgehen können“, so Deepmind.

Als Nächstes möchten die Forscher ihre Architektur mit sehr großen Datensätzen trainieren. Erste Tests deuteten bereits darauf hin, dass mehr Daten und ein größeres Netzwerk bessere Ergebnisse erlauben. Ihr erstes Projekt: eine Bildanalyse-KI.

Via: Arxiv