Ungewissheit ist bei Mensch und Tier ein ständiger Begleiter. Wer besser mit ihr umgehen kann, ist im Vorteil. Das gilt auch für Künstliche Intelligenz, wie Deepmind zeigt.

Biologische Lebewesen sind in ihrer Umwelt ständig Ungewissheit ausgesetzt. Ihr Wissen über ihre direkte Umgebung, zukünftige Ereignisse oder die Auswirkung eigener Handlungen ist beschränkt. Der mehr oder weniger kompetente Umgang menschlicher Intelligenz mit Ungewissheit ist eine ihrer großen Stärken.

Auch im Feld der Künstlichen Intelligenz ist der Umgang mit Ungewissheit ein wichtiges Thema: KI-Systeme sollten gerade in Hoch-Risiko-Anwendungsbereichen wie kritischer Infrastruktur, dem Gesundheitswesen oder im Militär wissen, wann sie etwas nicht wissen, wann sie vorsichtig sein sollten und wann sie Risiken eingehen müssen.

Ungewissheit in der Entscheidungsfindung kommt in zwei Formen

Der Ökonom Frank H. Knight schlug 1921 eine Unterscheidung von zwei grundsätzlich unterschiedlichen Formen der Ungewissheit in Entscheidungsfindungen vor: Risiko und Unsicherheit.

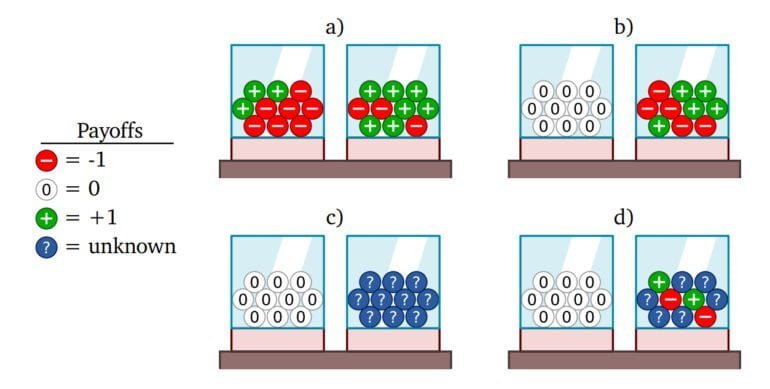

Ein Risiko liegt immer dann vor, wenn in einer bekannten Situation der Ausgang eines Ereignisses ungewiss ist, aber Wahrscheinlichkeiten berechnet werden können. Ein Beispiel ist etwa das Würfeln. Unsicherheit bezieht sich dagegen auf unbekannte Situationen, in denen die Wahrscheinlichkeiten nicht bekannt sind oder nicht bestimmt werden können.

Knapp 40 Jahre nach Knights Veröffentlichung argumentierte Daniel Ellsberg, ebenfalls ein Ökonom, für die evolutionären Vorteile verschiedener Entscheidungsmechanismen für bekannte, aber ungewisse Situationen (Risiko) gegenüber völlig neuen Situationen (Unsicherheit).

Seitdem fanden Forschende Korrelationen zwischen den Entscheidungsmechanismen und unterschiedlichen Mustern neuronaler Aktivität im menschlichen Gehirn.

Deepmind zeigt, wie KI mit Risiko und Unsicherheit umgehen kann

In der neuen Arbeit zeigt ein Team von Deepmind nun, wie KI-Agenten per Meta-Learning lernen können, mit beiden Formen von Ungewissheit umzugehen. Dafür modifiziert das Team für KI-Agenten genutzte Meta-Learning-Algorithmen, um diese sensitiv für Risiko und Unsicherheit zu machen.

Bisher habe das Meta-Learning-Training primär KI-Agenten hervorgebracht, die risiko- und unsicherheitsneutral sind, da sie sich ausschließlich am erwarteten Gewinn orientieren und in neuen Situationen so handeln, als ob die Unsicherheit bekannt wäre.

Deepmind möchte mit der neuen Forschung zeigen, dass dies nicht zwangsläufig das einzige Ergebnis des Meta-Learnings - und damit eine implizite Lösung für Optimierungsprobleme - sei.

Dafür verändert das Team den Prozess der Erfahrungsgenerierung des KI-Agenten, etwa indem während des Trainings ein zweiter Agent in der Umgebung die Pläne des ersten KI-Agenten vorhersieht und deren Erfolgswahrscheinlichkeit erhöht. Daraus entstehe dann ein Risiko-suchender KI-Agent, so die Autor:innen.

Eine Sensitivität für Unsicherheit entstehe dagegen, wenn ein KI-Agent etwa Ratschläge von mehreren Agenten erhält, die in völlig neuen Situationen sich naturgemäß unterscheiden. So lerne der KI-Agent, wie er am besten mit widersprüchlichen Ratschlägen umgehe.

Deepminds KI-Agenten lernen Sensitivität für Risiko und Unsicherheit

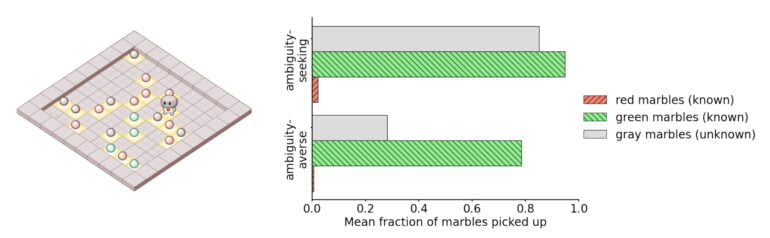

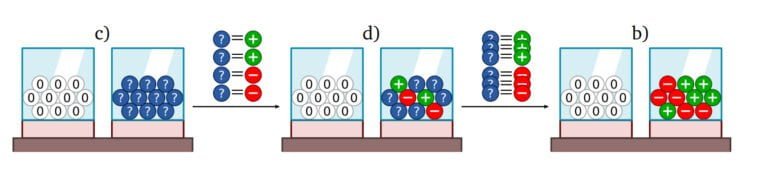

In ihrer Arbeit trainieren die Forschenden von Deepmind KI-Agenten mit den vorgeschlagenen Meta-Learning-Algorithmen und zeigen in verschiedenen Entscheidungsfindungsexperimenten, dass ihre Agenten eine Sensitivität für Risiko und Unsicherheit entwickeln und dadurch in bestimmten Fällen besser abschneiden als Agenten ohne diese.

Sie zeigen zudem, wie Agenten etwa in den Urnen-Experimenten aus ihren Ziehungen fehlende Informationen lernen und so Unsicherheit zu Risiko reduzieren können.

Die meisten KI-Modelle heute könnten nicht unterscheiden, was sie wissen und was sie nicht wissen, schließt Deepmind. Diese Fähigkeit sei jedoch entscheidend für robuste KI-Systeme, die mit unserer hochgradig unsicheren und dynamischen Welt verlässlich umgehen sollen. Häufig werde diese Robustheit mit einer Risikosensitivität verbunden, sie sei jedoch auch tief verknüpft mit Knights Unsicherheit.

"Wir haben gezeigt, wie man mit unseren Meta-Trainingsmechanismen datenabhängig mit Risiko und Unsicherheit umgehen kann", schreibt das Team.

Man hoffe, dass die dargestellten Mechanismen der Ausgangspunkt für eine Fülle von datenabhängigen Methoden zur Untersuchung und Anwendung von Sensitivität für Ungewissheit bei Menschen und Maschinen seien.

Alle Details und weitere interessante Überlegungen, etwa zum Verhältnis von Unsicherheit zu geschlossenen und offenen Welten, stehen im Paper "Beyond Bayes-Optimality: Meta-Learning What You Know You Don’t Know".