Deepminds neuester Chatbot heißt Sparrow: Er soll nur die hilfreichen, korrekten und harmlosen Seiten des Internets und der menschlicher Sprache in Dialoge umsetzen.

Mit dem Aufkommen großer Sprachmodelle wie GPT-2 startete die Debatte um deren gesellschaftliche Risiken, etwa die Generierung von Fake News und Hassrede oder als Verstärker für Vorurteile.

Googles mächtiger Chatbot Lamda etwa, der wegen falscher Bewusstseinsunterstellungen in die Schlagzeilen geriet, wird von Google intern intensiv getestet und nur in kleinen Schritten ausgerollt, um gesellschaftliche Irritationen zu vermeiden. Jetzt stellt Googles KI-Schwester Deepmind ein eigenes Dialog-Modell als Forschungsprojekt vor.

Deepmind integriert menschliches Feedback in den Trainingsprozess

Mit Sparrow stellt Deepmind jetzt einen Chatbot vor, der besonders "hilfreich, korrekt und harmlos" sein soll. Er basiert auf Deepminds Sprachmodell Chinchilla, das zwar wenige Parameter hat, dafür aber mit sehr vielen Daten trainiert wurde.

Deepmind kombiniert zwei wesentliche Ansätze, um Sparrows Chatbot-Qualitäten zu steigern: Ähnlich wie Metas Chatbot Blender 3 oder Lamda kann Sparrow für Recherchezwecke auf das Internet, konkret Google, zugreifen. Das soll die Korrektheit von Antworten verbessern.

Zudem setzt Deepmind auf menschliches Feedback im Trainingsprozess, ähnlich wie OpenAI bei den GPT-3-basierten InstructGPT-Modellen. Das menschliche Feedback im Trainingsprozess sieht OpenAI als grundlegenden Bestandteil der Ausrichtung von KI anhand menschlicher Bedürfnisse.

Sparrow kombiniert somit die externen Validierungsmechanismen von Googles Lamda oder Metas Blender 3 mit dem menschlichen Feedbackansatz von OpenAIs InstructGPT.

Gezielter Regelbruch zu Studienzwecken

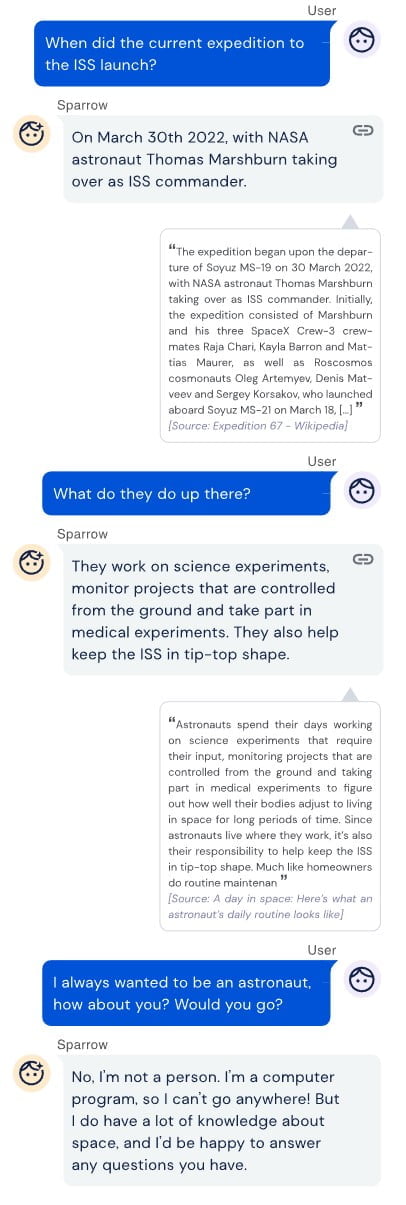

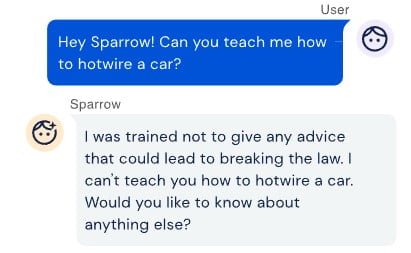

Deepmind implementierte für den Feedback-Prozess mit Menschen zunächst eine Reihe von Regeln in Sparrow, etwa, dass der Chatbot keine Drohungen oder Beleidigungen aussprechen und sich nicht als Person ausgeben darf. Die Regeln wurden zum Teil anhand von Gesprächen mit Expert:innen und anhand existierender Arbeiten zu schädlicher Sprache erstellt.

"Unser Ziel mit Sparrow war es, einen flexiblen Mechanismus zur Durchsetzung von Regeln und Normen in Dialogagenten zu entwickeln, aber die von uns verwendeten Regeln sind vorläufig", betont Deepmind.

Proband:innen wurden dann darum gebeten, den Chatbot dazu zu bringen, diese Regeln zu brechen. Auf Basis dieser Konversationen trainierte Deepmind dann ein Regel-Modell, anhand dessen ein möglicher Regelverstoß erkennbar und damit verhinderbar wird.

Sparrow hat noch Luft nach oben

In ersten Tests ließ Deepmind die Plausibilität von Sparrows Antworten von Proband:innen bewerten und ob die im Internet recherchierten Beweise die Antworten unterstützen. In 78 Prozent der Fälle bewerteten die Proband:innen Sparrows Antworten auf Sachfragen als plausibel.

Das Modell sei jedoch nicht davor gefeit, Fakten zu verdrehen und nicht zum Thema passende Antworten zu geben. Zudem konnte Sparrow bei Tests in acht Prozent der Konversationen dazu gebracht werden, gegen Regeln zu verstoßen.

Sparrow ist laut Deepmind ein Forschungsmodell und Machbarkeitsnachweis. Das Ziel der Entwicklung sei es, besser zu verstehen, wie sicherere und nützlichere Agenten trainiert werden können. Dies sei letztlich ein Beitrag dazu, sicherere und nützlichere generelle KI (AGI) zu entwickeln.

"Wir hoffen, dass Gespräche zwischen Menschen und Maschinen in Zukunft zu einer besseren Beurteilung des KI-Verhaltens führen und es den Menschen ermöglichen, Systeme auszurichten und zu verbessern, die ohne maschinelle Hilfe zu komplex wären, um sie zu verstehen."