DeepSeek-Coder-V2: Open-Source-Modell schlägt GPT-4 und Claude Opus

DeepSeek-AI hat das Open-Source-Sprachmodell DeepSeek-Coder-V2 veröffentlicht. Es soll in Sachen Programmcode-Generierung mit führenden kommerziellen Modellen wie GPT-4, Claude oder Gemini mithalten können.

DeepSeek-Coder-V2 baut auf dem Vorgängermodell DeepSeek-V2 auf und wurde zusätzlich mit 6 Billionen Token aus einem hochwertigen Multi-Source-Korpus trainiert. Das Modell unterstützt jetzt 338 statt bisher 86 Programmiersprachen und kann Kontexte von bis zu 128.000 statt 16.000 Token verarbeiten.

Der Trainingsdatensatz besteht zu 60 Prozent aus Quellcode, zu 10 Prozent aus mathematischen Daten und zu 30 Prozent aus natürlicher Sprache. Der Code-Anteil enthält 1,17 Billionen Token aus GitHub und CommonCrawl, der mathematische Teil 221 Milliarden Token aus CommonCrawl.

DeepSeek-Coder-V2 nutzt Mixture-of-Experts-Architektur und wird in zwei Varianten angeboten: Das 16-Milliarden-Parameter-Modell hat lediglich 2,4 Milliarden aktive Parameter, das 236-Milliarden-Modell nur 21 Milliarden. Beide Varianten wurden insgesamt mit 10,2 Billionen Token trainiert.

DeepSeek-Coder-V2 bricht die Dominanz geschlossener Modelle

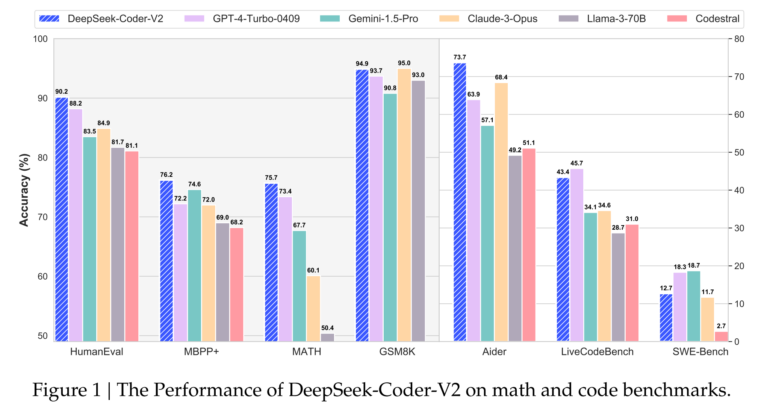

In Benchmarks wie HumanEval oder MBPP kann DeepSeek-Coder-V2 laut DeepSeek-AI mit den besten kommerziellen Modellen mithalten. Die 236-Milliarden-Version erreichte im Durchschnitt 75,3 Prozent. Das ist zwar etwas schlechter als GPT-4o mit 76,4 Prozent, aber besser als GPT-4 oder Claude 3 Opus.

In mathematischen Benchmarks wie GSM8K, MATH oder AIME 2024 ist DeepSeek-Coder-V2 mit den führenden kommerziellen Modellen auf Augenhöhe. In sprachlichen Aufgaben schneidet es ähnlich gut ab wie der Vorgänger DeepSeek-V2.

Das DeepSeek-Coder-V2-Modell steht auf Hugging Face unter einer Open-Source-Lizenz zum Download bereit. Es kann sowohl für Forschungszwecke als auch kommerziell ohne Einschränkungen genutzt werden. Es ist außerdem über eine API verfügbar.

Trotz der beeindruckenden Ergebnisse sehen die Entwickler noch Verbesserungsbedarf bei der Fähigkeit, Instruktionen zu befolgen. Das sei wichtig, um in der realen Welt mit komplexen Programmierszenarien umgehen zu können. Daran will DeepSeek-AI in Zukunft arbeiten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.