Deepseek präsentiert mit Janus Pro nächste Generation seines multimodalen KI-Modells

Deepseek hat sein multimodales KI-System Janus grundlegend überarbeitet. Janus Pro übertrifft seinen Vorgänger laut den Forschern durch eine optimierte Trainingsstrategie, mehr Trainingsdaten und die Skalierung auf größere Modelle.

Neben einigen Änderungen bei der Trainingsstrategie, die eine effizientere Nutzung der Daten ermöglichen soll, hat das Team auch bei den Trainingsdaten massiv aufgestockt: Für das multimodale Verstehen kamen etwa 90 Millionen neue Trainingsbeispiele hinzu. Diese stammen unter anderem aus Bildunterschriften-Datensätzen wie YFCC sowie aus Spezialdatensätzen für das Verstehen von Tabellen, Diagrammen, Memes und Dokumenten.

Für die Bildgenerierung wurden etwa 72 Millionen synthetische Trainingsbeispiele integriert, deren Prompts teilweise von Midjourney stammen. Damit wurde das Verhältnis von realen zu synthetischen Daten laut dem Paper auf 1:1 ausgeglichen.

Die größte Neuerung gegenüber Janus ist die Skalierung des Modells: Neben der 1B-Version gibt es nun auch eine 7B-Version. Diese größere Variante zeigt deutlich bessere Leistungen beim Verstehen und Generieren von Bildern.

In Benchmark-Tests erreicht diese größere Version (Janus Pro-7B) beim multimodalen Verstehen einen MMBench-Score von 79,2 und damit deutlich mehr als der Vorgänger mit 69,4. Das ist ein guter Wert - dennoch wird es hier von ähnlich großen Modellen geschlagen.

Höhere Qualität bei der Bildgenerierung

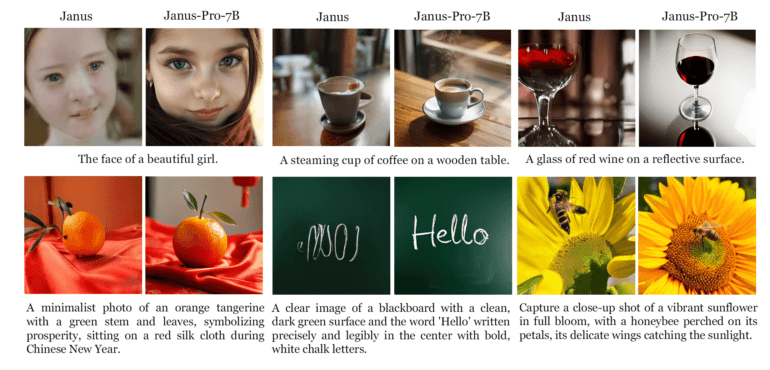

Die größten Verbesserungen zeigt das Modell in der Befolgung von Prompts: Während der Vorgänger noch Probleme mit kurzen Prompts und instabiler Bildqualität hatte, erzeugt Janus Pro laut dem Team auch bei knappen Anweisungen detailreiche und stabile Bilder. Es soll außerdem deutlich besser komplizierten Prompts folgen können.

Das spiegelt sich auch in Benchmarks wie GenEval wider, hier übertrifft es mit 80 Prozent Genauigkeit den Vorgänger (61 Prozent) deutlich. In diesem Benchmark schlägt es auch DALL-E 3 (67 Prozent) und Stable Diffusion 3 Medium (74 Prozent) - das sagt aber nicht viel über die tatsächliche Bildqualität aus. Hier liegen beide Modelle in der Praxis in den meisten Fällen weiter deutlich über Janus Pro.

Das liegt auch an einer wichtigen Einschränkung: Die Bildauflösung für In- und Output ist auf 384 x 384 Pixel begrenzt. Das führt besonders bei feinen Details wie Gesichtern zu Qualitätseinbußen und erschwert das multimodale Verstehen bei Aufgaben wie der Erkennung von Text. Eine höhere Auflösung soll laut dem Team diese Einschränkungen in Zukunft beheben können.

Das Team verrät nicht, ob diese Verbesserungen in einer zukünftigen Version von Janus enthalten sein werden, aber es ist wahrscheinlich. Deepseek hat kürzlich mit seinem R1-Modell weltweit für Aufsehen gesorgt und zahlreiche neue Kunden gewonnen. Mit einem leistungsfähigen multimodalen Modell könnte das Unternehmen ein stärkeres Konkurrenzprodukt zu OpenAIs ChatGPT anbieten - sofern es über die notwendige KI-Infrastruktur verfügt.

Mehr Informationen, der Code und das Modell sind auf GitHub und HuggingFace verfügbar. Dort gibt es auch eine Demo.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.