Die wichtigsten KI-News von Googles "Cloud Next"-Konferenz

Google stellt auf seiner Cloud-Konferenz unter anderem neue KI-Infrastruktur, leistungsfähige Modelle und ein Protokoll für die Zusammenarbeit autonomer Agenten vor und die siebte TPU-Generation vor.

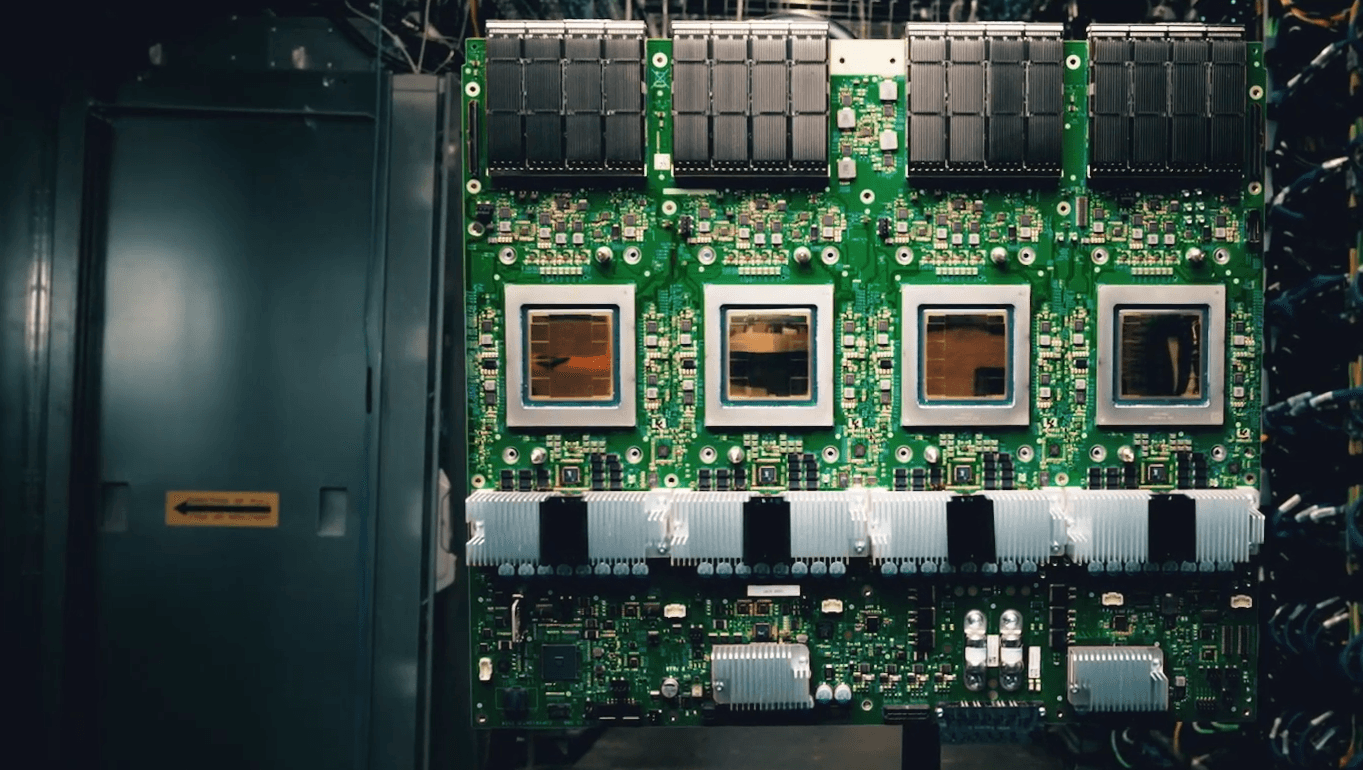

Mit Ironwood bringt Google seine siebte Generation von Tensor Processing Units auf den Markt. Die TPU wurde erstmals speziell für Inferenz – also das Schlussfolgern und Generieren von Antworten durch KI – entwickelt. Laut Google erreicht Ironwood eine bis zu 3.600-fache Leistungssteigerung gegenüber der ersten TPU und ist damit das bislang leistungsstärkste und energieeffizienteste Modell des Unternehmens.

Ironwood basiert auf flüssigkeitsgekühlten Chips und lässt sich in zwei Größen skalieren: von 256 bis zu 9.216 Chips pro Pod. Die größte Konfiguration erreicht 42,5 Exaflops Rechenleistung – 24-mal mehr als der derzeit schnellste Supercomputer El Capitan. Technisch bietet Ironwood 192 GB High-Bandwidth-Memory pro Chip, eine Bandbreite von 7,2 Terabit pro Sekunde sowie ein Interconnect von 1,2 Terabit pro Sekunde.

Gemini 2.5 Flash: Googles bestes Reasoning-Modell in der Schnelldenker-Variante

Mit Gemini 2.5 stellt Google kürzlich sein bislang leistungsfähigstes KI-Modell vor, das in Benchmarks hervorragend abschneidet und in der KI-Community viel positives Feedback erhält. Das 2.5er-Modell treibt jetzt auch Googles Deep-Research-Funktion an.

Neu angekündigt hat Google Gemini 2.5 Flash, eine Version mit niedriger Latenz und geringeren Kosten. Unternehmen können außerdem das Maß an "Reasoning" individuell steuern und so Leistung und Budget flexibel abwägen. Das Modell soll "bald" in Googles Vertex-KI-Cloud verfügbar sein.

Agent2Agent-Protokoll: KI-Agenten sollen plattformübergreifend zusammenarbeiten

Mit dem neuen offenen Protokoll "Agent2Agent" (A2A) will Google die Zusammenarbeit autonomer KI-Agenten vereinheitlichen. Über A2A können Agenten unterschiedlicher Anbieter miteinander kommunizieren, Aufgaben austauschen und Ergebnisse koordinieren – auch wenn sie in unterschiedlichen Frameworks entwickelt wurden.

Das Protokoll basiert auf verbreiteten Standards wie HTTP und JSON-RPC, ist sicherheitskonform zu OpenAPI und unterstützt Text, Audio- und Videoformate. Agenten geben ihre Fähigkeiten über sogenannte "Agent Cards" bekannt und verhandeln im Austausch Aufgabenformate oder Nutzeroberflächen.

Ein Beispiel zeigt die automatisierte Bewerbersuche: Ein Agent kann andere Agenten beauftragen, passende Kandidaten zu finden, Interviews zu koordinieren und Hintergrundprüfungen durchzuführen. A2A soll später im Jahr in einer produktionsreifen Version erscheinen. Die Demo läuft in Googles Agenten-Interface "Agentspace".

Video: Google AI

Updates für Googles Medien-Modelle

Google hat mehrere KI-Modelle für generative Medien erweitert. Veo 2 kann jetzt nicht nur Videos aus Texteingaben generieren, sondern auch bearbeiten. Neu sind Funktionen wie Inpainting zur Entfernung von Bildelementen, Outpainting zur Erweiterung des Bildausschnitts, Kamerasteuerung, Bildkomposition sowie Interpolation zur Erzeugung flüssiger Übergänge zwischen Szenen und Videos. Die Funktionen sind für ausgewählte Tester als Preview verfügbar.

Googles Videmodell Veo 2 kann jetzt auch Outpainting. | Video: Google AI

Auch das Text-zu-Musik-Modell Lyria ist neu verfügbar. Es erzeugt Musikstücke auf Basis kurzer Texteingaben, etwa für Marketing, Podcasts oder Videos. Die generierten Tracks lassen sich an Genre, Stimmung und Tempo anpassen.

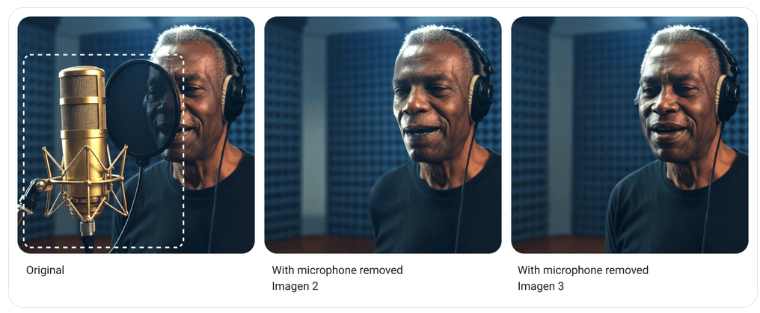

Das Bildmodell Imagen 3 wurde um eine verbesserte Inpainting-Funktionen erweitert. Es kann unerwünschte Objekte entfernen oder beschädigte Bildbereiche rekonstruieren – mit laut Google "signifikant" verbessertem Übergang und Detailwiedergabe.

Das Stimm- und Geräuschmodell Chirp 3 wurde um zwei Funktionen ergänzt: "Instant Custom Voice" erstellt synthetische Stimmen aus nur zehn Sekunden Audiomaterial. Zudem trennt eine neue Transkriptionsfunktion einzelne Sprecher in Mehrpersonenaufnahmen automatisch.

Alle Modelle enthalten laut Google präventive Schutzmechanismen wie digitale Wasserzeichen über SynthID, Inhaltsfilter sowie Datenschutzkontrollen. Google bietet außerdem eine Haftungszusage bei urheberrechtlichen Streitfällen im Rahmen der Nutzung dieser Modelle.

KI-Workflows und mehr im Google Workspace

Google erweitert zudem die Nutzung von KI im Unternehmensbereich durch neue Funktionen in Workspace. Mit Workspace Flows führt Google eine neue Automatisierungsplattform ein, die KI-gestützte Workflows über Apps wie Docs, Sheets, Meet und Chat hinweg ermöglicht. Flows kann mithilfe sogenannter "Gems" – also benutzerdefinierter Gemini-Chatbots – Aufgaben wie die Bearbeitung von Kundenanfragen, das Prüfen von Richtliniendokumenten oder das Sortieren von Support-Tickets automatisiert übernehmen.

Auch die einzelnen Workspace-Apps erhalten neue KI-Funktionen. In Google Docs können Nutzer künftig vollständige Audiodateien ihrer Texte erzeugen oder sich eine Zusammenfassung im Podcast-Stil ausgeben lassen. Die Funktion "Help me refine" bietet dabei Textvorschläge zur Verbesserung von Argumentation, Struktur und Stil.

In Google Sheets analysiert die Funktion „Help me analyze“ Datensätze automatisch und schlägt interaktive Visualisierungen sowie nächste Schritte vor. Die neue App Google Vids erlaubt die Erzeugung realistischer Videoclips mit Hilfe des Veo-2-Modells – ohne externes Schnittprogramm.

In Google Meet kann Gemini Besprechungen zusammenfassen oder gezielt Fragen beantworten. Und in Google Chat lässt sich Gemini per @-Befehl in Gespräche einbinden, um Entscheidungen, offene Fragen und nächste Schritte automatisch zu extrahieren.

Mehr KI für die Wissenschaft

Auch im wissenschaftlichen Bereich baut Google Cloud seine KI-Infrastruktur deutlich aus. Mit den neuen H4D-VMs stellt Google besonders leistungsstarke CPU-basierte Recheneinheiten bereit, die sich für hochparallele Berechnungen in Bereichen wie Moleküldynamik, Klimamodellierung oder Materialforschung eignen.

Die VMs setzen auf AMD-Prozessoren und Googles Titanium-Netzwerk zur Beschleunigung der Datenkommunikation. Wissenschaftliche Nutzer können damit Supercomputing-Cluster in der Cloud aufbauen und ihre Anwendungen auf Tausende Prozessoren skalieren. Unterstützt wird dies durch Werkzeuge wie das Cluster Toolkit und die Verwaltungsplattform Cluster Director.

Parallel dazu bringt Google erste KI-gestützte Anwendungen für die Forschung auf seine Plattform. Dazu gehört unter anderem AlphaFold 3, das die Struktur und Wechselwirkungen biologischer Moleküle vorhersagen kann. In der neuen High-Throughput-Version kann AlphaFold auf Google Cloud große Mengen an Sequenzdaten verarbeiten und so etwa die Analyse potenzieller Krankheitstreiber beschleunigen.

Mit WeatherNext bietet Google außerdem ein KI-Modell für präzise Wettervorhersagen an, das über Vertex AI angepasst und eingesetzt werden kann. Beide Anwendungen basieren auf Modellen von Google DeepMind und Google Research.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.