Künstliche Intelligenz bedeutet nicht zwangsläufig Perfektion: Ein Entwickler programmiert eine KI, die Mario Kart ebenso schlecht spielen lernt wie sein Vater.

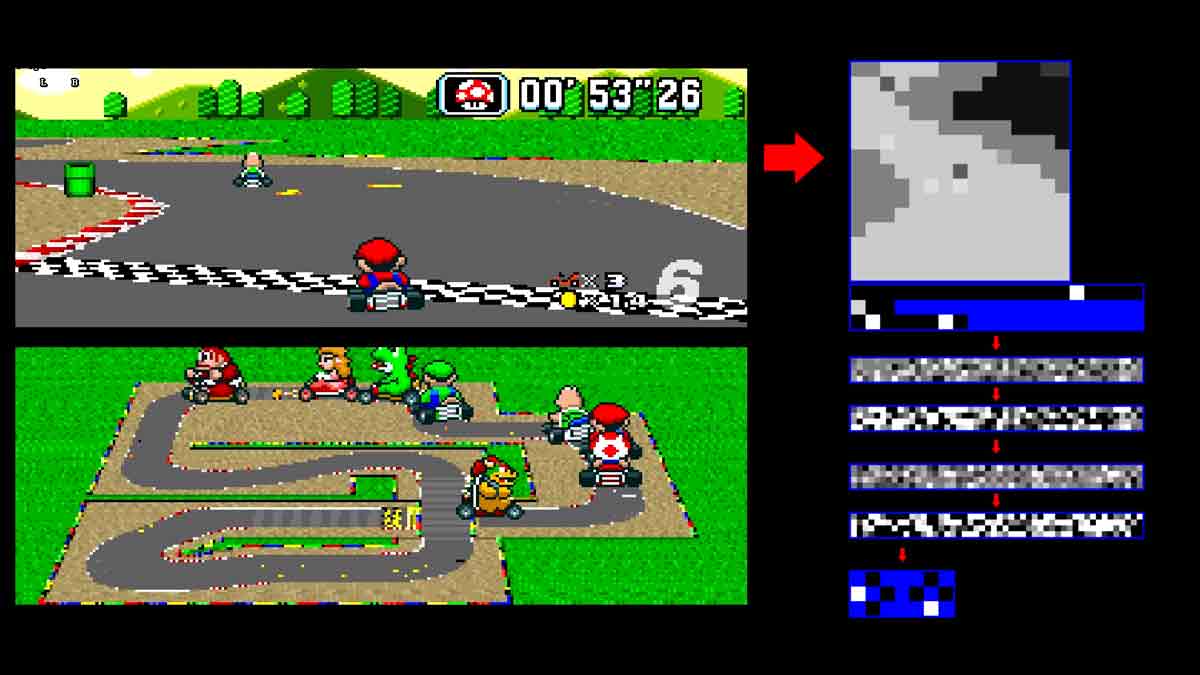

Das KI-System besteht aus einem Netz künstlicher Neuronen, die durch Beobachtung lernen. Rund 15 Stunden Videomaterial fütterte der YouTuber "Sethbling" dem neuronalen Netz, das anhand der Bilder lernte, die Controller-Eingaben des menschlichen Spielers vorherzusagen.

Da das System ausschließlich durch Beobachtung und nicht aus sich selbst heraus lernt, kann es nur so gut werden wie die Fahrer in den Videos, also Sethbling oder sein Vater. Das Ziel war es, dass der Computerfahrer nicht mehr von einem menschlichen Spieler zu unterscheiden ist - was man vom typischen CPU-gesteuerten Fahrer nicht unbedingt behaupten kann.

Manuelles Training in Sackgassen

Da die KI nur durch Beobachtung lernte, kam sie immer dann in Schwierigkeiten, wenn sie in Situationen geriet, die sie zuvor noch nicht beobachtet hatte. Um dieses Problem zu lösen, half der Programmierer manuell nach: In einem speziellen Modus wechselten sich die KI und der menschliche Fahrer am Steuer ab und meisterten gemeinsam die schwierigsten Fahrmanöver.

Das aus diesen interaktiven Sessions entstandene Trainingsmaterial half dann dabei, die KI so zu optimieren, dass sie eigenständig Rennen gewinnen kann - auch wenn sie absolut keine Vorstellung davon hat, was ein Rennen ist. Oder Mario Kart.

Anders als Sethblings vergleichsweise einfaches neuronales Netz ist Googles neueste KI-Errungenschaft nicht mehr auf menschliche Unterstützung angewiesen. Es lernte das komplexe Brettspiel Go aus sich selbst heraus nur anhand der Regeln und war innerhalb kürzester Zeit in der Lage, sowohl menschliche Spieler als auch andere künstliche Intelligenzen zu besiegen.

Sethbling hat seinen Entwicklungsaufwand dokumentiert: Wer gerne selbst mit dem Verfahren experimentieren möchte, findet hier eine Anleitung.