Human Brain Project: Neuroroboter zeigt den Vorteil biologischer Gehirne

Ein Ratten-Roboter nutzt KI-Algorithmen, die von echten Ratten inspiriert wurden. Er entstand im Rahmen des europäischen Human Brain Project.

Während autonome Fahrzeuge, Staubsaugerroboter und Paketdrohnen schnell an Hindernissen scheitern, orientieren sich biologische Lebewesen vergleichsweise mühelos in sich ständig ändernden Umgebungen. Dafür setzen sie auf mehrere Sinne, die vom Gehirn kombiniert und zur Orientierung eingesetzt werden.

Eine prominente Theorie der Kognitionswissenschaft geht davon aus, dass Gehirne diese Informationen nicht einfach passiv erwarten, sondern aktiv ununterbrochen ein mentales Modell der Umwelt erstellen und aktualisieren.

Laut der sogenannten prädiktiven Kodierung erstellt das Modell konstant Vorhersagen über die sensorischen Informationen, die mit den tatsächlich eintreffenden Informationen verglichen werden. Fehler in der Vorhersage führen dann zur Aktualisierung des Modells.

EBRAINS: Interdisziplinäre Forschung für bessere KI-Gehirne

Das europäische Human Brain Project startete im Oktober 2013 mit dem Ziel, diese Wahrnehmungs- und Modellierungsmechanismen besser zu verstehen. Dafür wurde unter anderem die digitale Forschungsinfrastruktur EBRAINS entwickelt, die kognitive Neuro- und Robotikforschende sowie Computermodellierer:innen zusammenbringt, um die neuronalen Mechanismen etwa mit Neurorobotern zu untersuchen. Solche Roboter setzen auf KI-Netze, die der Funktionsweise von biologischen Gehirnen nachempfunden sind.

Laut des Human Brain Project bietet EBRAINS zahlreiche Gehirn-Datensätze, einen mehrstufigen Gehirnatlas, Modellierungs- und Simulationswerkzeuge, einen einfachen Zugang zu Hochleistungscomputern sowie zu Robotik und neuromorphen Plattformen.

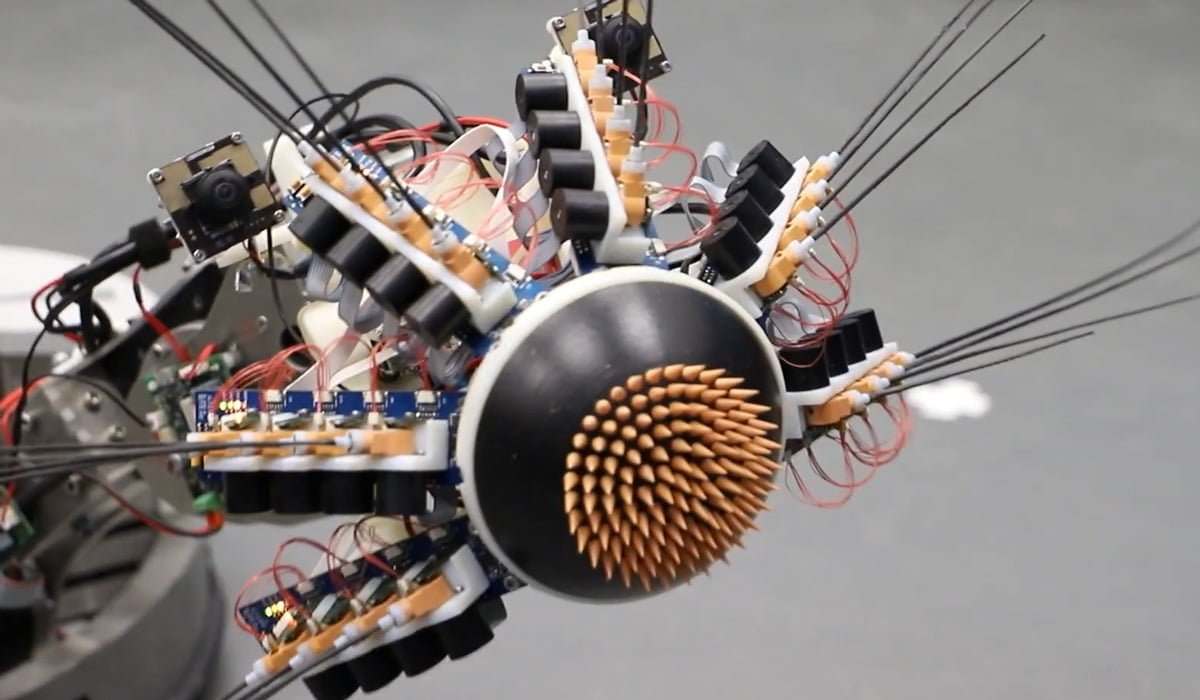

WhiskEye: Ratten-Roboter setzt auf Augen und Schnurrhaare

Forschende haben nun den Ratten-Roboter WhiskEye mit einem Gehirn-inspirierten Algorithmus ausgestattet. WhiskEye nutzt eine RGB-Kamera und künstliche Schnurrhaare, um sich in seiner Umgebung zu orientieren. Das eingesetzte künstliche neuronale Netzwerk verknüpft die zwei Sinneseindrücke und setzt auf prädiktive Kodierung.

Die verwendete Netzwerkarchitektur für die Wahrnehmung wurde auf der Grundlage von realen Daten von Ratten entwickelt: „MultiPrednet“ besteht aus Modulen für visuelle und taktile Eingaben und einem dritten Modul, das diese zusammenführt.

Das neuronale Netz versucht konstant, die eingehenden sensorischen Informationen vorherzusagen, indem es Vorhersagen an nachgelagerte Schichten weitergibt. Der aus diesen Vorhersagen resultierende Fehler wird zur Anpassung der Gewichtungen im neuronalen Netz verwendet.

So ausgestattet, erkundet WhiskEye eine simple Umgebung mit einfachen 3D-Formen wie farbigen Zylindern und Würfeln. Durch stoßweise Bewegungen der Schnurrhaare sammelt der Roboter taktile Eindrücke.

Die Kameras von WhiskEye nehmen im Moment der maximalen Schnurrhaarprotraktion ein Foto auf und synchronisieren die taktilen und visuellen Eingaben. Dadurch werde sichergestellt, dass die visuellen und taktilen Eingaben aus demselben Zeitabschnitt stammen, was das Lernen multisensorischer Repräsentationen fördere, schreiben die Forschenden.

Das künstliche Gehirn bringt Vorteile

Laut der Forschenden gibt es erste Hinweise, dass das hirnbasierte Modell Vorteile gegenüber herkömmlichen Deep Learning-Systemen habe. Insbesondere bei der Navigation und der Erkennung von bekannten Szenen schneide MultiPredNet besser ab.

Das sei bemerkenswert, da das KI-Netz nichts über den WhiskEye-Roboter, die Methoden der Datenerfassung, die in der Arena platzierten Objekte oder die Position des Roboters zu einem bestimmten Zeitpunkt wisse. Alles, was MultiPredNet an Daten verarbeite, seien Schnappschüsse visueller und taktiler Informationen, aus denen es eine Repräsentation seiner Umgebung aufbaue.

Um ihre Forschung zu beschleunigen, bauten die Forschenden ihren Roboter außerdem als Simulation auf der Neurorobotik-Plattform der EBRAINS-Forschungsinfrastruktur nach. Detailliertere Modelle der Steuerung und Wahrnehmung sollen in Zukunft auf High-Performance- und Neuromorphic-Computing-Plattformen laufen. Auch das sei dank EBRAINS unkompliziert, so Cyriel Pennartz, Professor für Kognitions- und Systemneurowissenschaften an der Universität von Amsterdam.

MultiPredNet ist Open Source und über EBRAINS verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.