Facebooks neue Spracherkennung lernt ohne menschliche Hilfe - und soll dennoch in zahlreichen Sprachen funktionieren.

Spracherkennungssysteme bilden den Kern heutiger KI-Assistenten von Amazon, Google oder Apple. Sie beantworten Fragen, helfen bei der Navigation oder schreiben Nachrichten.

Doch die Technologie ist heute nur für einen Bruchteil der gesprochenen Sprachen verfügbar. Das große Hindernis steckt im Datenaufwand: Alle aktuellen Systeme müssen mit von Menschen transkribierten Audioaufnahmen trainiert werden.

Qualitativ hochwertige KI-Transkriptionen gibt es daher nur für einige Sprachen wie Englisch, Chinesisch oder Deutsch. Doch selbst bei Sprachen, für die brauchbare Datensätze existieren, gibt es Lücken im System wie Dialekte und Aussprachen.

Facebooks Lösung: eine Spracherkennung, die beim KI-Training nicht mehr auf transkribierte Audioaufnahmen angewiesen ist.

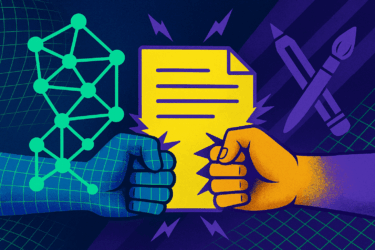

Für das Training setzt Facebook stattdessen auf eine Mischung aus Audioaufnahmen und Text. Ein Netzwerk lernt, die Audioaufnahmen in einzelne Laute zu teilen und in Phoneme zu verwandeln, die an ein Generative Adversarial Network (GAN) weitergegeben werden.

Das Generator-Netz des GANs generiert aus den Phonemen Text, ein weiteres muss einschätzen, ob die generierten Texte einen Sinn ergeben. Dieses sogenannte Diskriminator-Netz bekommt dafür zusätzlich Texte mit zugehörigen Phonemen zu sehen. Es gibt nach der Einschätzung Feedback an das Generator-Netz, das versucht anschließend, einen besseren Text zu generieren. Mit der Zeit lernt das Generator-Netz so, die Phoneme korrekt in Texte zu übertragen.

Facebooks Lösung macht 63 Prozent weniger Fehler

Wav2vec Unsupervised (wav2vec-U) erreicht laut Facebook beispielsweise bei der englischen Spracherkennung die Leistung von älteren KI-Übersetzern der letzten beiden Jahre, die mit über 900 Stunden transkribierter Aufnahmen trainiert sind. An die Leistung aktueller überwacht trainierter KI-Systeme (Erklärung) von 2021 kommt wav2vec-U allerdings noch nicht heran.

Facebook sieht den Einsatz der Spracherkennung daher vor allem in Sprachen, in denen keine transkribierten Daten existieren, etwa Swahili, Tatarisch oder Kirgisisch. Im Vergleich zu anderen unüberwacht trainierten KI-Systemen (Erklärung) macht wav2vec-U laut Facebook 63 Prozent weniger Erkennungsfehler.

Laut Facebook reduziert wav2vec-U den KI-Trainingsaufwand drastisch und könnte daher in Zukunft Spracherkennung für zahlreiche Sprachen ermöglichen. Den Open-Source-Code für wav2vec-U gibt es auf Github.

Titelbild: Facebook | Via: Facebook