Facebooks weltbester Chatbot jetzt kostenlos verfügbar

Facebooks neuer Chatbot Blender soll sogar Googles Meena hinter sich lassen.

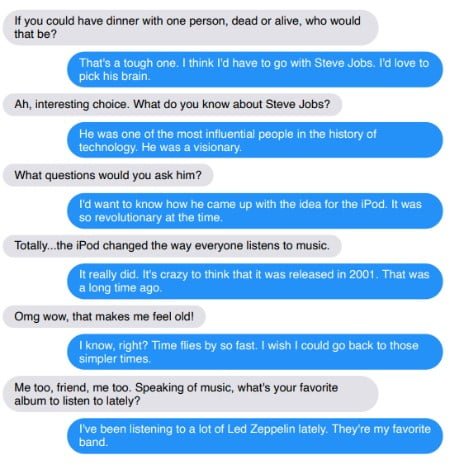

Wenn man in Deutschland einen Chatbot "Blender" nennen würde, so wäre das nicht unbedingt ein Kompliment, aber durchaus korrekt. Immerhin versucht der Bot, mit aller Macht vorzutäuschen, ein Mensch zu sein. Facebooks neuem Chatbot soll dieses Unterfangen besonders gut gelingen.

Der englische Ausdruck Blender steht allerdings nicht für den Vortäuscher, sondern Mixer. Die Bezeichnung passt: Facebooks KI-Abteilung FAIR verwendete für das KI-Training des Bots 1,5 Milliarden öffentlich verfügbare Reddit-Kommentare. Auf dieser Datenbasis lernte der Bot die Grundlagen der Gesprächsführung.

Anschließend wurde das KI-Modell feinjustiert: Die Forscher trainierten die KI mit weiteren Datensätzen für emotionale Reaktionen, informationsbasierte Dialoge mit Wiki-Wissen und Dialoge zwischen zwei Personen für mehr Charakter. In Tests experimentierten sie mit verschiedenen Modellen und Ausrichtungen.

https://www.facebook.com/FacebookAI/posts/1511884102321871

Facebook Blender vs. Google Meena

Die Forscher verglichen Blenders Leistung mit Meena, einem Chatbot, den Google Ende Januar vorstellte und der laut Google seinerzeit einen neuen Standard setzte in maschineller Dialogkultur.

Im direkten Vergleich hat Facebook laut eigenen Angaben die Nase vorne: Das generierte Sprachmodell mit 9,4 Millionen Parametern ist mehr als dreimal so groß als Meenas mit 2,6 Millionen Parametern.

Dialoge über Themen wie Kochen, Musik, Filme, Haustiere oder Yoga kamen bei ersten Testern eher gut an: Bis zu 75 Prozent von ihnen bewerteten die Gespräche mit Blender als interessanter und realistischer im Vergleich zu Googles Chatbot Meena, der laut Google bei Tests nur knapp hinter den Qualitäten eines menschlichen Gesprächspartners rangiert und frühere Chatbos deutlich übertrifft.

Besonders interessant ist daher der A/B-Test, bei dem die Facebook-Forscher ein Chatbot-Gespräch gegen einen menschlichen Gesprächspartner antreten ließen: Bis zu 49 Prozent der Tester bewerteten den vorgelegten Computer-Dialog als menschlicher.

Facebooks Bot halluziniert Fakten

Trotz der Fortschritte sehen die Facebook-Forscher noch eine Menge Arbeit hin zu "tatsächlich intelligenten Dialog-Agenten". In der Tat hat Blenders Gesprächskultur grundlegende Probleme, die unmittelbar mit den Trainingsdaten zusammenhängen.

Der Bot neigt zur Phrasenhaftigkeit, wiederholt Aussagen des Gesprächspartners und eigene Fragen, widerspricht sich selbst und vergisst Aussagen. Steigt man mit Tiefgang in ein Thema ein, generiert der Bot Falschaussagen.

Blender kann sich außerdem nicht an frühere Konversationen erinnern - würde man sich also laufend mit dem Bot unterhalten, würden Gespräche schnell langweilig und belanglos. Außerdem könne der Bot durch Konversationen keine Konzepte lernen und die Realität nicht als Fundament für Gespräche verwenden.

KI-Modelle, Beschreibungen und die wissenschaftliche Veröffentlichung zu Blender sind hier als Open Source verfügbar.

Quelle: Facebook

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.