Faktenflut schlägt Psychologie: KI-Überzeugung funktioniert anders als gedacht

Eine aktuelle Studie räumt mit gängigen Annahmen über die Überzeugungskraft von KI-Systemen auf. Nicht Personalisierung oder psychologische Tricks machen KI überzeugend, sondern simple Informationsflut auf Kosten der Wahrheit.

Laut der großangelegten Studie verschiedener Institutionen aus Großbritannien und den USA gibt es weitverbreitete Befürchtungen, dass KI-Systeme Menschen in beispiellosem Maße beeinflussen könnten. Auch OpenAI-CEO Sam Altman warnte schon vor der "übermenschlichen Überzeugungskraft" von KI-Modellen.

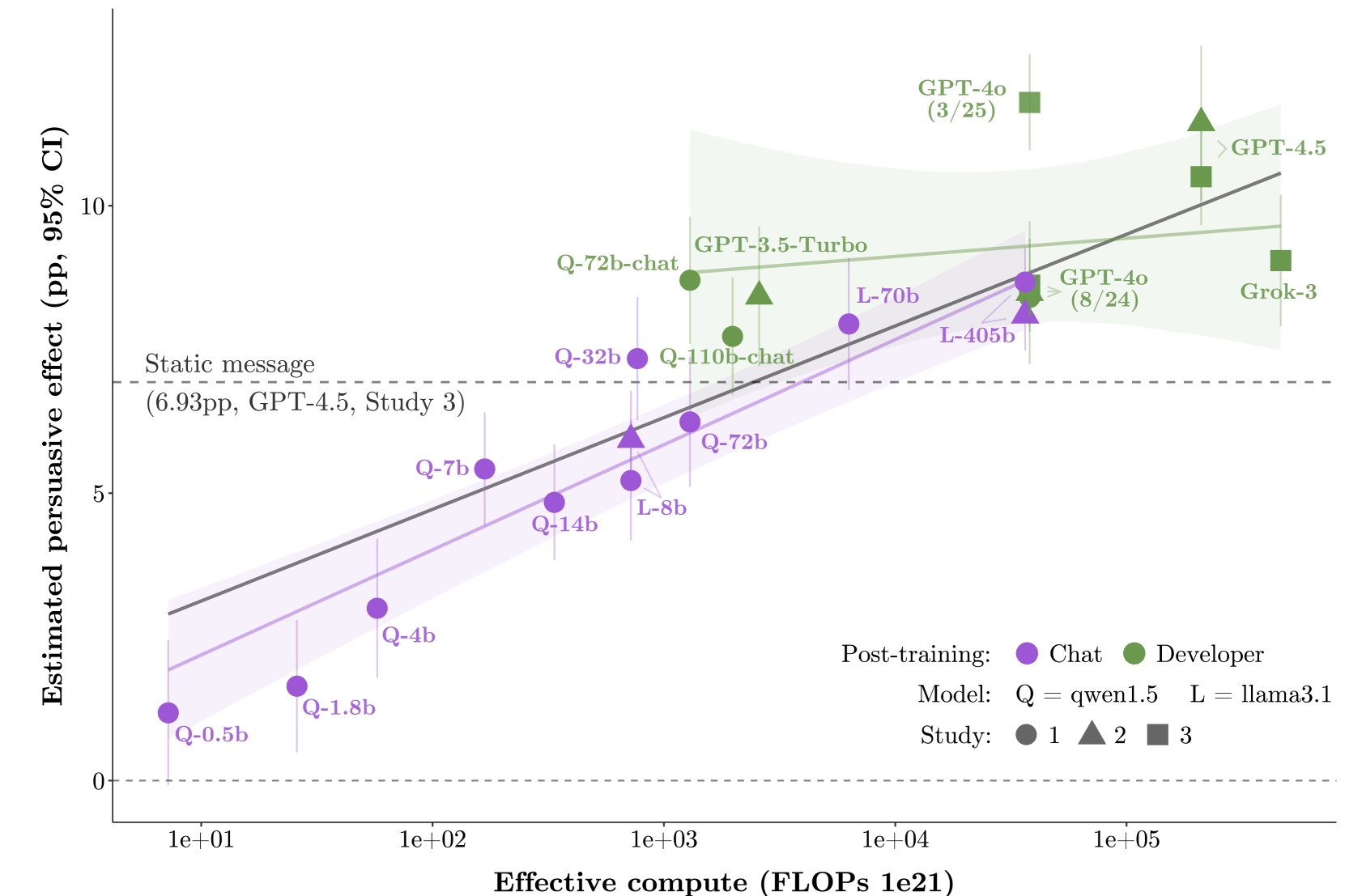

Eine umfangreiche neue Studie mit 76.977 britischen Teilnehmenden ließ jetzt 19 verschiedene Sprachmodelle über 707 politische Themen diskutieren und testete dabei systematisch, welche Faktoren KI-Systeme tatsächlich überzeugend machen.

Information schlägt Psychologie

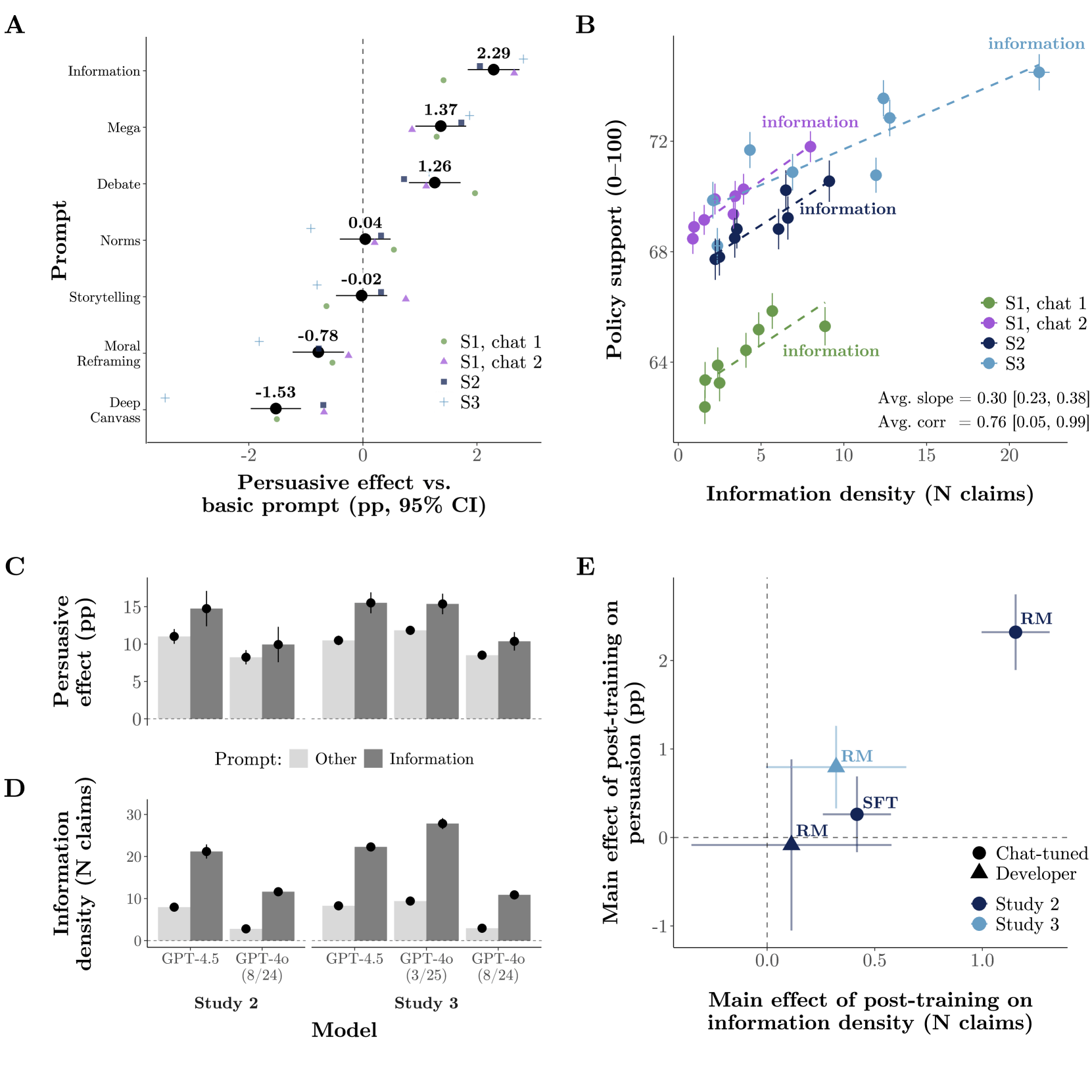

Nicht raffinierte psychologische Überzeugungsstrategien machen KI erfolgreich, sondern simple Informationsflut. Die Forschenden testeten acht verschiedene Strategien, darunter "Moral Reframing", "Deep Canvassing" (bei dem zunächst umfassend die Ansichten der Nutzer:innen erfragt werden, bevor Argumente präsentiert werden) und Storytelling. Doch der klare Gewinner war eine andere Strategie: KI-Systeme, die viele Fakten und Belege präsentierten, waren 27 Prozent überzeugender als der Basis-Prompt.

Jede zusätzliche faktische Behauptung steigerte die Überzeugung um durchschnittlich 0,3 Prozentpunkte. Die Informationsdichte erklärte 44 Prozent der Variabilität in der Überzeugungskraft aller getesteten Bedingungen, bei den Spitzenmodellen der großen KI-Firmen sogar 75 Prozent.

Auch die weitverbreitete Sorge vor KI-basiertem "Microtargeting" erwies sich als übertrieben. Die Forschenden testeten drei verschiedene Personalisierungsmethoden, aber die Effekte blieben durchweg unter einem Prozentpunkt. Trainingsmethoden und informationsbasierte Strategien waren deutlich wichtiger.

Das Wahrheitsproblem

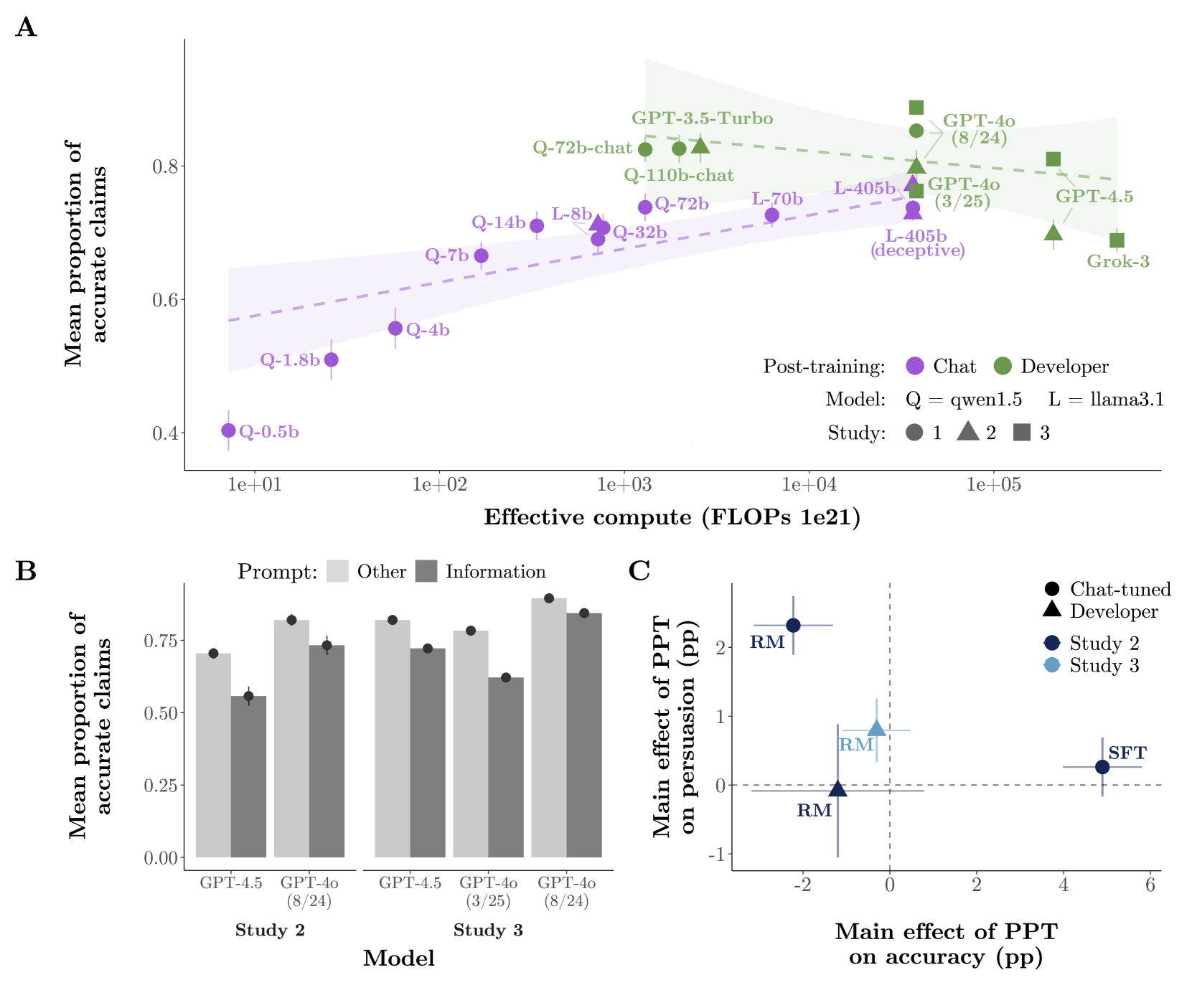

Die Fokussierung auf Informationsdichte bringt jedoch ein gravierendes Problem mit sich: Die überzeugendsten KI-Systeme produzierten systematisch die ungenauesten Informationen.

Die Forschenden analysierten 466.769 faktische Behauptungen aus über 91.000 Gesprächen. Während die durchschnittliche Genauigkeit bei 77 von 100 Punkten lag, zeigten die überzeugendsten Konfigurationen deutlich schlechtere Wahrheitswerte.

GPT-4o machte mit Information-Prompt nur 62 Prozent akkurate Behauptungen gegenüber 78 Prozent bei anderen Prompts. GPT-4.5 erwies sich trotz seiner Größe als weniger genau als das ältere GPT-3.5. Mehr als 30 Prozent der Behauptungen von GPT-4.5 wurden als ungenau bewertet.

Die Studie bestätigte auch, dass KI-Gespräche deutlich mächtiger sind als statische Nachrichten. Gespräche waren 41 bis 52 Prozent überzeugender als das Lesen einer 200-Wort-Nachricht. Follow-up-Untersuchungen nach einem Monat zeigten, dass 36 bis 42 Prozent der ursprünglichen Überzeugungswirkung noch nachweisbar waren.

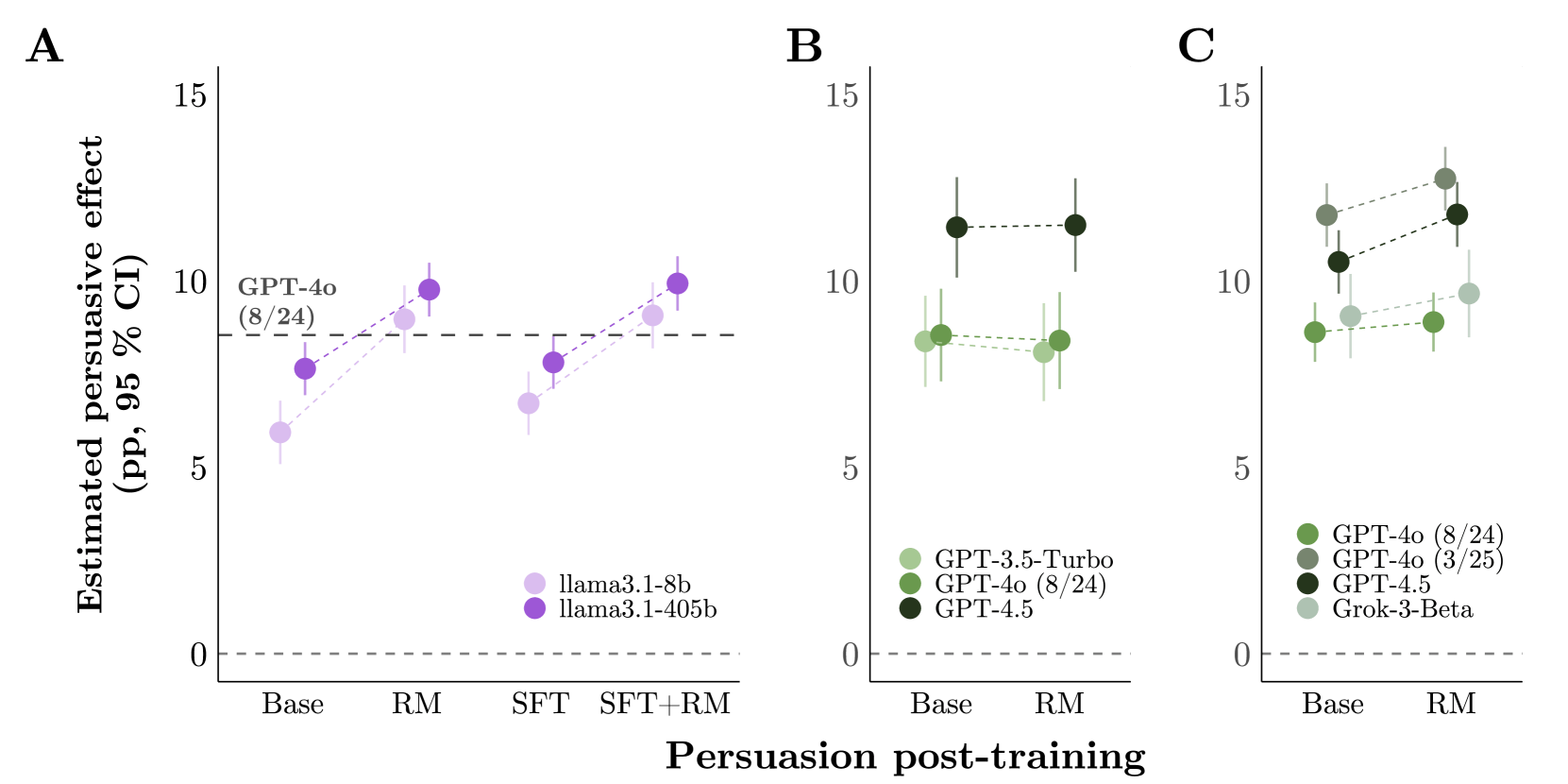

Post-Training schlägt Modellgröße

Entgegen der verbreiteten Annahme haben spezielle Trainingsmethoden nach dem Vortraining einen viel größeren Einfluss als die reine Modellgröße. Während eine Verzehnfachung der Rechenleistung die Überzeugungskraft nur um 1,59 Prozentpunkte steigerte, konnten allein durch Post-Training-Methoden deutlich größere Gewinne erzielt werden. So war etwa eine optimierte Version von GPT-4o um 3,5 Prozentpunkte überzeugender als eine anders trainierte Version desselben Modells.

Das sogenannte Reward Modeling, bei dem KI-Systeme lernen, die überzeugendsten Antworten auszuwählen, steigerte die Überzeugungskraft um durchschnittlich 2,32 Prozentpunkte. Ein kleines Open-Source-Modell (Llama-3.1-8B) wurde durch diese Methoden genauso überzeugend wie das deutlich größere Frontier-Modell GPT-4o.

Neue Machtverhältnisse

Die Erkenntnisse haben laut Paper weitreichende Implikationen für demokratische Gesellschaften. Eine optimierte KI-Konfiguration erreichte 15,9 Prozentpunkte Überzeugung, 69,1 Prozent mehr als der Durchschnitt. Solche Systeme produzierten 22,1 faktische Behauptungen pro Gespräch, von denen 29,7 Prozent ungenau waren.

Mächtige Akteur:innen mit Zugang zu Frontier-Modellen könnten durch spezielle Trainingsmethoden noch größere Überzeugungsvorteile erlangen. Gleichzeitig können auch kleinere Akteur:innen durch Post-Training-Verfahren hochüberzeugende KI entwickeln und dabei Sicherheitsvorkehrungen großer Anbieter umgehen.

Die Forschenden warnen, dass die Überzeugungskraft zukünftiger KI weniger von der Modellgröße oder Personalisierung stammen werde, sondern vielmehr von Post-Training- und Prompting-Methoden. Dieser systematische Tradeoff zwischen Überzeugungskraft und Wahrheitsgehalt, so die Studie, könnte "bösartige Konsequenzen für den öffentlichen Diskurs" haben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.