Forscher entwickeln KI-Architektur nach Vorbild des menschlichen Gehirns

Ein Start-up hat eine neue Architektur für Sprachmodelle entwickelt, die sich mehr am Aufbau des biologischen Gehirns inspiriert. Das System erreicht die Leistung älterer GPT-Modelle, arbeitet aber mit Neuronen und Synapsen.

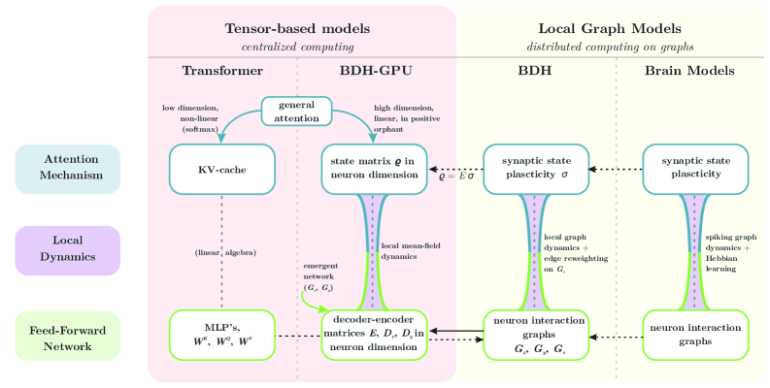

Die Architektur namens "(Baby) Dragon Hatchling" (BDH) vom polnischen, im Silicon Valley ansässigen Start-ups Pathway. Aktuelle Sprachmodelle basieren zumeist auf der Transformer-Architektur, die zwar durch Skalierung von Rechenleistung und Inferenzdauer immer bessere Ergebnisse erzielt, laut den Forschenden (trotz Gemeinsamkeiten) aber anders funktioniere als das menschliche Gehirn.

Transformer seien den Forschenden zufolge schwer zu verstehen und ihr Verhalten über längere Zeiträume schwer vorherzusagen. Das werde zum Problem für autonome KI-Systeme, deren Verhalten kontrollierbar bleiben muss.

Das menschliche Gehirn hingegen ist ein extrem komplexes graphbasiertes System mit etwa 80 Milliarden Neuronen und über 100 Billionen Verbindungen. Bisherige Versuche, eine Brücke zwischen Sprachmodellen und Gehirnfunktionen zu schlagen, hätten laut den Forschenden keine überzeugenden Ergebnisse geliefert.

Statt fester Berechnungsblöcke verwendet es ein Netzwerk aus künstlichen Neuronen, die über Synapsen miteinander kommunizieren. Wichtiger Baustein ist das sogenannte "Hebbian Learning", ein Prinzip aus der Neurowissenschaft: Neuronen, die zusammen feuern, verdrahten sich zusammen. Wenn zwei Neuronen gleichzeitig aktiv sind, verstärkt sich ihre Verbindung. So entstehen Gedächtnisinhalte nicht durch feste Speicher, sondern durch die Stärke der Verbindungen zwischen Neuronen.

Die Forschenden bezeichnen diese Dynamik als "Equations of Reasoning" oder Gleichungen des Denkens. Diese lokalen Regeln beschreiben, wie einzelne Neuronen miteinander interagieren und dabei komplexe Denkprozesse entstehen lassen.

Unbegrenztes Kontextfenster

In Tests erreichte BDH die gleiche Leistung wie das Modell GPT-2 bei Sprach- und Übersetzungsaufgaben – womit Pathway ein System zum Vergleich heranzieht,dass mittlerweile zwar als längst überholt gilt, aber auch die Grundlage war für die darauffolgenden Durchbrüche durch Skalierung.

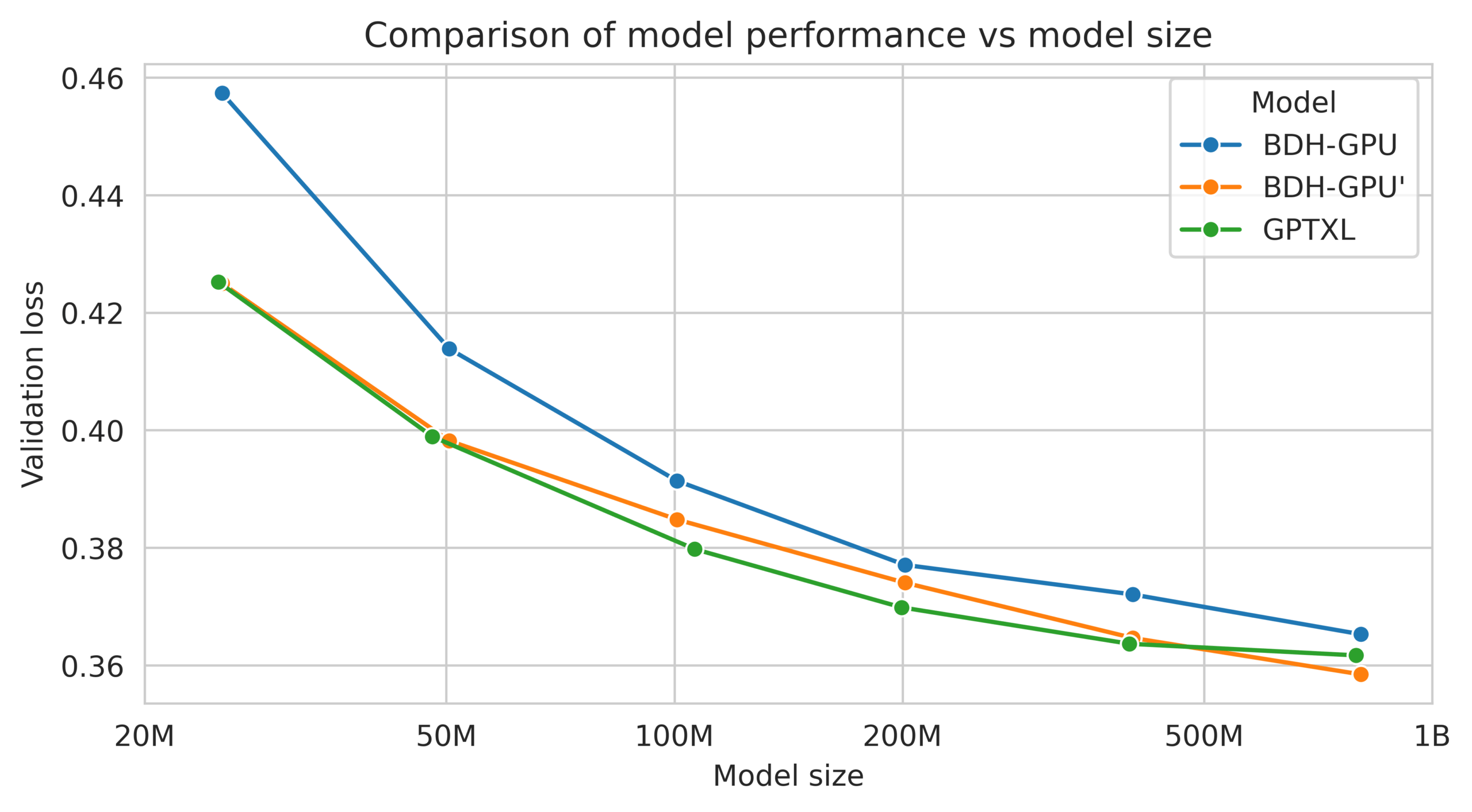

Die Forschenden testeten BDH-GPU direkt gegen GPT-2-ähnliche Transformer-Modelle bei identischer Parameteranzahl zwischen 10 Millionen und 1 Milliarde Parametern. Bei diesen kontrollierten Vergleichen mit gleicher Trainingszeit und identischen Datensätzen zeigte BDH mehrere Vorteile gegenüber herkömmlichen Transformern: Es lernte schneller pro Datentoken und erreichte bessere Verlustreduzierung, insbesondere bei Übersetzungsaufgaben.

Ein weiterer Vorteil ist die theoretisch unbegrenzte Kontextlänge. Da das System Informationen in den Synapsenverbindungen statt in einem begrenzten Zwischenspeicher speichert, kann es prinzipiell unbegrenzt lange Texte verarbeiten.

Nur etwa fünf Prozent der Neuronen sind zu einem Zeitpunkt aktiv. Diese spärliche Aktivierung macht das System nicht nur recheneffizienter, sondern auch deutlich interpretierbarer. Wenn nur wenige Neuronen gleichzeitig feuern, lässt sich nämlich leichter nachvollziehen, welche spezifischen Konzepte oder Informationen das Modell gerade verarbeitet.

Interpretierbare Synapsen

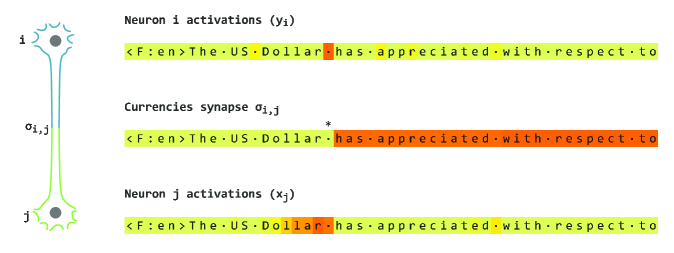

Die Forschenden konnten nachweisen, dass sich in BDH sogenannte "monosemantic synapses" entwickeln. Das sind Verbindungen, die spezifisch auf bestimmte Konzepte reagieren. In Experimenten mit europäischen Parlamentsprotokollen fanden sie Synapsen, die fast ausschließlich bei Erwähnung von Währungen oder Ländernamen aktiviert wurden.

Diese Synapsen reagierten sogar sprachübergreifend: Die gleiche Verbindung wurde sowohl bei "British Pound" als auch bei "livre sterling" aktiviert. Solche interpretierbaren Strukturen entstehen automatisch während des Trainings, ohne dass sie explizit programmiert werden müssen.

Zusätzlich entwickelt das System automatisch eine modulare, skalenfreie Netzwerkstruktur mit hoher Modularität. Diese Eigenschaften sind typisch für natürliche Informationsverarbeitungssysteme wie das Gehirn.

Praktische Anwendungen und Zukunftsaussichten

BDH könnte laut Pathway neue Möglichkeiten für das Modell-Engineering bieten. Die Forschenden zeigen, dass verschiedene Sprachmodelle direkt zusammengeführt werden können, indem ihre Neuronenschichten konkateniert werden. Das funktioniert ähnlich wie das Kombinieren von Computerprogrammen.

Die biologische Plausibilität könnte aufgrund ihrer Interpretierbarkeit auch für die KI-Sicherheit relevant sein. In der Gehirnforschung liefert die Studie konkrete Hinweise darauf, dass die im Gehirn beobachteten Effekte, wie modulare Netzwerkstrukturen, synaptische Plastizität und spärliche Aktivierung, direkt aus der Kernfunktion des Reasonings entstehen könnten.

Die Forschenden argumentieren, dass die komplexen Eigenschaften des Gehirns möglicherweise nicht aus speziellen Trainingsmechanismen resultieren, sondern aus den grundlegenden Anforderungen der Sprachverarbeitung und des Schlussfolgerns.

Laut Pathway bildet BDH den Grundstein für eine neue Theorie über das Verhalten sehr großer Sprachmodelle im Grenzbereich unendlicher Größe und Zeit. Das ultimative Ziel sind mathematisch beweisbare Aussagen darüber, wie gut und zuverlässig KI-Systeme über längere Zeiträume hinweg logisch schließen können. Ein vergleichbares Modell wäre die Thermodynamik, die das Verhalten von Gasen mit unendlich vielen Teilchen beschreibt.

Zwar scheint die aktuelle Sprachmodellentwicklung angesichts ausbleibender Durchbrüche tatsächlich ein Plateau erreicht zu haben. Nach immer größerer Skalierung von Trainingsdaten und -ressourcen versuchen Hersteller nun, bei der Inferenz etwa durch Reasoning-Ketten genauere und hilfreichere Ergebnisse zu erzielen. Der Transformer wird wohl nicht allzu bald abgelöst werden, allerdings entstehen mehr Mischsysteme, zum Beispiel in Kombination mit der Mamba-Architektur.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.