Kyutai veröffentlicht Open-Source-Assistent Moshi mit Echtzeitgesprächen

Update –

- Release-Informationen ergänzt

Das französische KI-Labor Kyutai veröffentlicht zwei Versionen seines KI-Assistenten Moshi, der natürliche Gespräche mit Nutzern führen kann.

Nachdem das Start-up im Juli seinen KI-Assistenten Moshi vorgestellt hat, hat Kyutai jetzt wie versprochen die Open-Source-Modelle veröffentlicht. Die Veröffentlichung umfasst mehrere Komponenten: Dazu gehören ein technischer Bericht, Gewichte für Moshi und seinen Mimi-Codec sowie Streaming-Inferenz-Code in PyTorch, Rust und MLX.

Video: Kyutai Labs

Laut dem Bericht besteht Moshi aus drei Hauptkomponenten: Helium, einem 7B-Sprachmodell, Mimi, einem neuralen Audio-Codec, und einer neuen Multi-Stream-Architektur. Das System kann Echtzeit-Gespräche mit Überlappungen und Unterbrechungen modellieren. Kyutai Labs stellt zwei Moshi-Modelle mit künstlich generierten Stimmen zur Verfügung. Weitere Details finden sich im veröffentlichten Paper und GitHub-Repository.

Ursprünglicher Artikel vom 04. Juli 2024

Das französische KI-Labor Kyutai präsentierte in Paris seinen KI-Assistenten Moshi, der natürliche Gespräche mit Nutzern führen kann. Die Technologie soll als Open Source veröffentlicht werden.

Das französische KI-Start-up Kyutai hat in Paris seinen neuen KI-Assistenten Moshi vorgestellt. Laut Kyutai ist Moshi der erste öffentlich zugängliche KI-Assistent mit Sprachfähigkeiten, der natürliche Gespräche führen kann. OpenAI hatte diese Funktion für GPT-4o vorgestellt, aber noch nicht veröffentlicht.

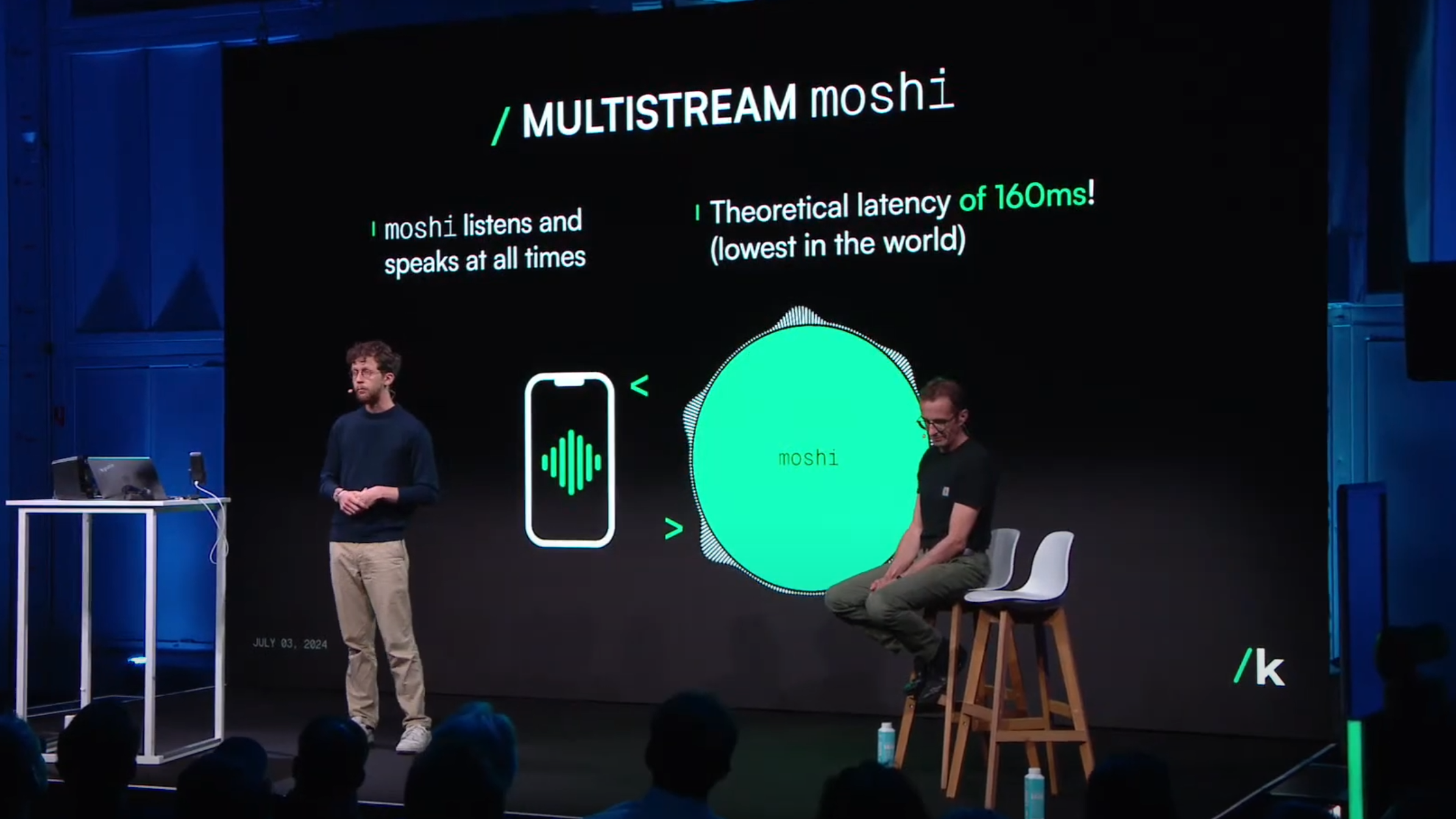

Kyutai-CEO Patrick Perez erklärte bei der Präsentation, dass Moshi in nur sechs Monaten von einem achtköpfigen Team entwickelt wurde. Das Besondere an Moshi ist seine Fähigkeit, in Echtzeit zu sprechen und zuzuhören. Laut Kyutai hat Moshi eine theoretische Latenz von nur 160 Millisekunden, in der Praxis liegt sie zwischen 200 und 240 Millisekunden.

Die Architektur von Moshi basiert auf einem neuen Ansatz, den Kyutai als "Audio Language Model" bezeichnet. Statt wie üblich Sprache in Text umzuwandeln, komprimiert das Modell Audiodaten stark und behandelt sie wie Pseudowörter. Dadurch kann es direkt mit Audiodaten arbeiten und Sprache vorhersagen, es ist also wie GPT-4o ein nativ multimodales Modell.

Video: Kyutai

Für das Training nutzte Kyutai verschiedene Datenquellen, darunter menschliche Bewegungsdaten und YouTube-Videos. Zuerst wurde ein reines Textmodell namens Helium trainiert. Anschließend wurde ein kombiniertes Training mit Text- und Audiodaten durchgeführt. Synthetische Dialoge wurden für die Feinabstimmung der Konversation verwendet. Da das zugrundeliegende Sprachmodell mit 7 Milliarden Parametern recht klein ist, weist es im Dialog die üblichen Einschränkungen kleiner Modelle auf. Dennoch sind die Sprachfähigkeiten und die Geschwindigkeit beeindruckend und lassen das Potenzial erahnen, wenn leistungsfähigere und größere Module mit dieser Technologie zum Einsatz kommen.

Um Moshi eine konsistente Stimme zu verleihen, arbeitete Kyutai mit einer Sprecherin namens Alice zusammen. Sie nahm Monologe und Dialoge in verschiedenen Stilen auf, die dann für das Training eines Sprachsynthesesystems verwendet wurden.

Moshi: Demo verfügbar, Open Source folgt

Kyutai sieht in Moshi ein großes Potenzial, die Art und Weise der Kommunikation mit Maschinen zu verändern. Insbesondere im Bereich der Zugänglichkeit für Menschen mit Behinderungen sieht das Unternehmen vielversprechende Anwendungsmöglichkeiten.

Die Moshi-Demo ist ab sofort online verfügbar. In den kommenden Monaten will Kyutai die Technologie als Open Source veröffentlichen, damit Entwickler und Forscher sie untersuchen, anpassen und erweitern können. Ein Paper soll ebenfalls folgen.

Kyutai wurde 2023 gegründet und erhielt im vergangenen November 300 Millionen Euro von französischen Milliardären wie Xavier Niel und Rodolphe Saadé. Als wissenschaftliche Berater konnte Kyutai renommierte KI-Forscher wie Yann LeCun und Bernhard Schölkopf gewinnen. Eines der Hauptargumente, mit dem Kyutai Forscher anzieht, ist das Bekenntnis zu offener Wissenschaft und die Möglichkeit, ihre Arbeit zu veröffentlichen: Alle Modelle von Kyutai sollen Open Source sein, und die Forscher planen, nicht nur die Modelle, sondern auch den Trainingsquellcode und die Dokumentation des Trainingsprozesses zu veröffentlichen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.